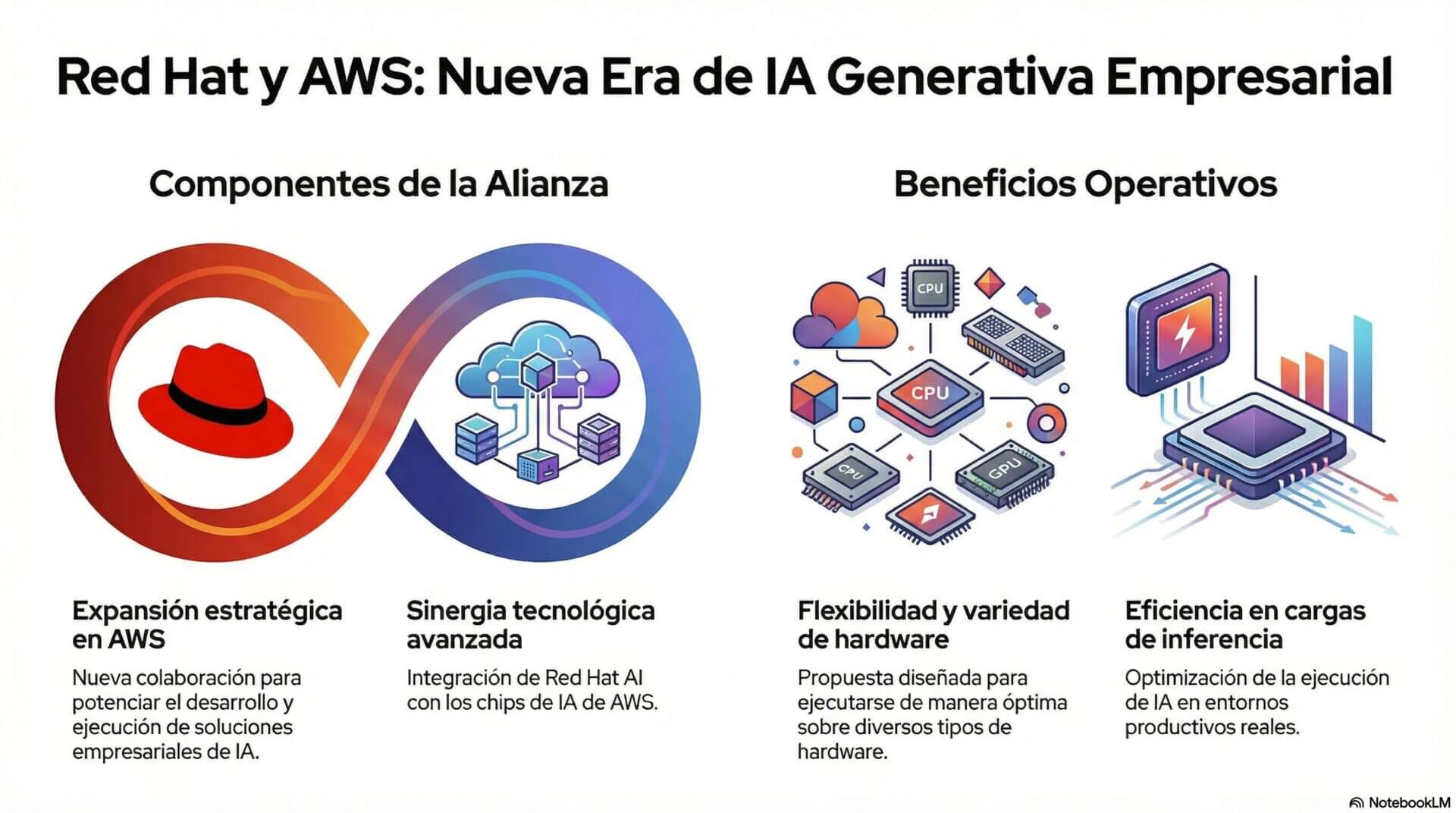

Red Hat y Amazon anunciaron la expansión de su colaboración estratégica en Amazon Web Services para potenciar el desarrollo y la ejecución de soluciones empresariales de inteligencia artificial generativa.

A partir de Red Hat AI y de los chips de IA de AWS, ambas compañías buscan dar mayor flexibilidad, variedad y eficiencia a las cargas de trabajo de inferencia en entornos productivos, con una propuesta diseñada para ejecutarse sobre distintos tipos de hardware. Si estás a cargo de decisiones tecnológicas, el foco está puesto en facilitar ese camino.

La iniciativa se basa en el uso de los chips Trainium e Inferentia de AWS y apunta a acompañar a los responsables de TI en un contexto en el que la demanda de inferencia escalable obliga a revisar las decisiones de infraestructura. En ese marco, Red Hat refuerza su rol como proveedor de una capa común de inferencia, integrada con la nube de AWS y alineada con modelos de código abierto.

Índice de temas

¿Por qué Red Hat y Amazon apuestan por nuevos chips de IA en AWS?

El crecimiento de la IA generativa llevó a muchas organizaciones a evaluar alternativas al uso exclusivo de GPU. Según IDC, “para 2027, el 40% de las organizaciones utilizará silicio personalizado, incluidos procesadores ARM o chips específicos para AI/ML, para satisfacer las crecientes demandas de optimización del rendimiento, eficiencia de costos y computación especializada”.

Esa proyección ayuda a entender por qué gana terreno el interés por arquitecturas pensadas para tareas concretas de inferencia y entrenamiento, sobre todo cuando tenés que escalar sin perder control.

Frente a esa tendencia, Red Hat y Amazon plantean una estrategia basada en software empresarial de código abierto junto con aceleradores propios de AWS. En ese esquema, los chips Inferentia2 y Trainium3 ocupan un lugar central, con el objetivo de mejorar el rendimiento y mantener los costos bajo control en despliegues de IA en producción, sin quedar atados a una sola arquitectura.

¿Qué aporta Red Hat y Amazon con el AI Inference Server?

Uno de los anuncios principales fue la habilitación de Red Hat AI Inference Server para ejecutarse sobre los chips de IA de AWS. Esta solución, basada en vLLM, plantea una capa de inferencia común capaz de soportar cualquier modelo de IA generativa. La meta es escalar aplicaciones con menor latencia y una eficiencia económica más alta, algo que impacta de lleno en los entornos productivos.

Según la información oficial, el uso de Inferentia2 y Trainium3 permite alcanzar una eficiencia entre un 30% y un 40% superior en comparación con instancias de Amazon EC2 basadas en GPU comparables. Esa mejora se refleja en un mejor aprovechamiento de los recursos en escenarios productivos donde la inferencia continua tiene un peso determinante.

¿Qué aporta Red Hat y Amazon con el AI Inference Server?

| Aspecto | Detalle |

|---|---|

| Anuncio principal | Habilitación de Red Hat AI Inference Server para ejecutarse sobre los chips de IA de AWS. |

| Tecnología base | Solución basada en vLLM, que propone una capa de inferencia común capaz de soportar cualquier modelo de IA generativa. |

| Objetivo | Escalar aplicaciones con menor latencia y mayor eficiencia económica, con impacto directo en entornos productivos. |

| Infraestructura utilizada | Uso de chips Inferentia2 y Trainium3 de AWS. |

| Beneficio en eficiencia | Entre 30% y 40% más eficiencia en comparación con instancias de Amazon EC2 basadas en GPU similares. |

| Impacto en producción | Mejor aprovechamiento de recursos en escenarios donde la inferencia continua tiene un rol determinante. |

¿Cómo impacta Red Hat y Amazon en OpenShift y la operación diaria?

La colaboración también se extendió al ecosistema OpenShift. Red Hat trabajó junto a AWS en el desarrollo de un operador de AWS Neuron para Red Hat OpenShift, Red Hat OpenShift AI y Red Hat OpenShift Service on AWS. Esta integración permite ejecutar cargas de trabajo de IA con aceleradores de AWS dentro de una plataforma de aplicaciones totalmente administrada, lo que simplifica la adopción de estos recursos si gestionás entornos productivos.

A ese anuncio se sumó el lanzamiento de la Colección Ansible Certificada amazon.ai para la Plataforma de Automatización Red Hat Ansible. La herramienta permite orquestar servicios de IA en AWS y simplificar tareas operativas vinculadas al despliegue y la administración de modelos, con un impacto directo en la gestión cotidiana de la infraestructura.

¿Qué rol cumple la comunidad en la estrategia de Red Hat y Amazon?

Red Hat y Amazon también pusieron el foco en el trabajo con la comunidad upstream. Ambas compañías colaboran en la optimización de un plugin de chips de IA de AWS para que esté disponible en vLLM. Como principal colaboradora comercial del proyecto, Red Hat impulsa su adopción en AWS con el objetivo de acelerar las capacidades de inferencia y entrenamiento, un punto clave si buscás escalar este tipo de cargas.

El modelo vLLM se apoya en la arquitectura llm-d, un proyecto de código abierto orientado a la inferencia a escala, que hoy está disponible como recurso comercial dentro de Red Hat OpenShift AI 3. Con este paso, la alianza suma un componente comunitario a una relación que ya cuenta con una trayectoria extensa en entornos híbridos, edge y nube pública.