La aparición de la inteligencia artificial revolucionó la forma en que las empresas trabajan. Esta tecnología ofrece oportunidades para mejorar aspectos como la eficiencia y la innovación en los distintos sectores. Sin embargo, a medida que los sistemas de IA se vuelven más complejos y omnipresentes, la necesidad de auditar a la IA para que opere de forma responsable se convirtió en una prioridad para la gran mayoría de las compañías.

El uso de la IA, aunque este lleno de ventajas, también conlleva algunos riesgos como la falta de transparencia en la toma de decisiones o sesgos ocultos en los datos. Estos problemas pueden provocar graves repercusiones para las empresas. Por lo tanto, auditar a la IA resulta ser una práctica importante para garantizar que las decisiones impulsadas por inteligencia artificial sean justas y precisas.

“Entre los principales desafíos se destacan la falta de una normativa específica actualizada y la complejidad técnica del funcionamiento de los algoritmos de IA que, en la mayoría de los casos, resultan imposibles de interpretar o explicar cómo llegan a un determinado resultado (cajas negras y opacidad)”, expresó Guillermina Favali, Abogada y Maestranda en IA, en diálogo con ID360.

En este contexto, la auditoría de IA se presenta como una herramienta para supervisar los modelos y algoritmos utilizados por las empresas. No se trata solo de una medida preventiva, sino que también de una práctica estratégica que contribuye a la sostenibilidad y la legitimidad de una corporación.

Índice de temas

¿Qué significa auditar a la IA y por qué es clave para las empresas?

Auditar a la IA es un proceso integral que evalúa distintos aspectos técnicos, éticos, legales y operativos de un sistema de inteligencia artificial.

Su objetivo principal es el de asegurar que el sistema funcione de forma correcta, sea transparente en sus decisiones, opere de manera ética y cumpla con las regulaciones tanto locales como internacionales que se encuentran vigentes. Además, este análisis, hace posible la eliminación del riesgo de que se produzcan sesgos, errores, violaciones de privacidad o incluso hasta la falta de explicabilidad en los resultados.

La importancia de auditar a la IA en el ámbito empresarial

En el ámbito empresarial, en donde la IA juega papel indispensable en la toma de decisiones, auditar estos sistemas se volvió fundamental para mitigar riesgos y regulatorios. Los fallos de un modelo pueden provocar sanciones legales, daños reputacionales e incluso poner en riesgo la seguridad y la confianza de los clientes y socios. Es importante en sectores críticos de la sociedad, ya que las decisiones automatizadas impactan de forma directa en la vida y el bienestar de las personas.

La auditoría de la inteligencia artificial también tiene un impacto directo en la confianza empresarial. Un sistema auditado y transparente genera mayor seguridad entre los usuarios y los consumidores. Además, también fortalece la reputación de una empresa.

Recomendaciones de los distintos organismos e instituciones

Para reforzar este enfoque, el Departamento de Comercio de Estados Unidos, a través de la Administración Nacional de Telecomunicaciones e Información (NTIA, por sus siglas en inglés), subrayó la importancia de las auditorías independientes en sistemas de IA, sobre todos en aquellos sistemas de alto riesgo.

En esta misma linea, el Berkman Klein Center de la Universidad de Harvard destacó la importancia de las auditorias para asegurar que las decisiones automatizadas no perpetúen prejuicios ni discriminen de manera injusta. Al implementar este tipo de revisiones, las empresas pueden garantizar el uso responsable de la inteligencia artificial.

Esta posición refuerza la necesidad de auditar a la IA no solo como obligación legal, sino como práctica esencial para la transparencia y la gestión de riesgos.

¿Qué elementos se deben revisar al auditar a la IA?

Al auditar a la IA, es fundamental revisar una serie de componentes que aseguren:

- La funcionalidad del sistema.

- cumplimiento ético.

- Cumplimiento legal.

- Cumplimiento de las operaciones.

Estos son los principales elementos que deben ser evaluados en una auditoría de inteligencia artificial:

| Elemento Crítico | Descripción | Relevancia |

|---|---|---|

| Calidad de datos | Verifique la calidad, integridad, representatividad y consistencia de los datos usados. | Datos de mala calidad generan resultados erróneos, sesgos o imprecisiones en el modelo. |

| Sesgos | Detectar sesgos inherentes en los datos y en el diseño del modelo que puedan conducir a decisiones injustas o discriminatorias. | Evitar impactos negativos, éticos y legales derivados de discriminación o injusticia. |

| Trazabilidad | Garantizar registro y documentación completa del ciclo de vida del modelo, incluyendo datos, versiones y decisiones. | Permite una auditoría transparente y reproducible, crucial para confianza y cumplimiento normativo. |

| Explicabilidad | Evaluar si las decisiones y resultados del modelo pueden ser entendidos y explicados a usuarios y reguladores. | Facilitar la transparencia y la adopción responsable, imprescindible en entornos críticos. |

| Desempeño | Medición de la precisión, recuperación, puntuación F1, tasas de error y otros indicadores relevantes para validar la funcionalidad. | Asegúrese de que el modelo cumpla su propósito sin afectar negativamente al negocio o usuario final. |

| Cumplimiento normativo | Verificación de que el modelo cumple con leyes, regulaciones sectoriales, políticas internas y estándares éticos. | Minimiza riesgos legales y reputacionales, garantizando operación conforme y ética. |

Datos a tener en cuenta para auditar a la IA

Esta lista cubre los aspectos más importantes que se deben revisar durante la auditoría de un sistema de IA. La calidad de los datos y la detección de sesgos son fundamentales para evitar decisiones erróneas o injustas.

Además, la trazabilidad y explicabilidad del modelo son esenciales para garantizar la transparencia y la comprensión, tanto para los usuarios como para los reguladores. Evaluar el desempeño del modelo también asegura que cumple con los objetivos sin causar efectos negativos en los usuarios o el negocio.

¿Cómo saber si un modelo de IA está tomando decisiones justas y no sesgadas?

Para asegurarse de que un modelo de IA tome decisiones justas y no sesgadas, se deben realizar una serie de prácticas y pruebas que ayuden a identificar y mitigar los sesgos presentes en el entrenamiento y la inferencia del modelo.

Estas son algunas de las prácticas más recomendadas para evaluar la equidad y la justicia al auditar a la IA:

Realizar pruebas de equidad (fairness testing)

Evalúar si el modelo produce resultados imparciales para diferentes grupos demográficos o segmentos afectados y analizar si ciertas poblaciones obtienen resultados desproporcionadamente positivos o negativos.

Segmentación por grupo afectado

Dividir los datos y los resultados por grupos específicos (por ejemplo, género, raza, edad, ubicación) para identificar sesgos específicos en el modelo que puedan estar presentes durante el entrenamiento o la inferencia.

Identificar tipos de sesgos

Detecta y medí diferentes tipos de sesgos, como:

- Sesgo de datos: mala representatividad de algunas poblaciones en los datos de entrenamiento.

- Sesgo algorítmico: preferencias o patrones erróneos que el modelo podría aprender de los datos.

- Sesgo de medición: errores que ocurren en la captura de datos o en su interpretación.

Preprocesamiento de datos

Aplicar técnicas para limpiar y equilibrar los datos antes del entrenamiento, con el objetivo de reducir la influencia de sesgos discriminatorios en la fase de entrenamiento del modelo.

Implementar algoritmos conscientes de la equidad

Utilizar algoritmos que ajusten las decisiones del modelo para promover equidad en lugar de maximizar únicamente la precisión.

Posprocesamiento para corregir resultados sesgados

Emplea técnicas que ajusten o calibren los resultados después de la inferencia, para corregir decisiones que puedan haber sido injustas.

Auditorías con supervisión humana

Implementar auditorías regulares que revisen las decisiones del modelo para facilitar la detección temprana de sesgos y asegurando transparencia en los procesos.

Métricas avanzadas de equidad

Además de la precisión tradicional, adopta métricas que midan la equidad y el impacto social de las decisiones del modelo. Esto permitirá hacer una evaluación más completa de su desempeño ético.

¿Qué normas o marcos existen para auditar a la IA de forma responsable?

Existen varios marcos y normas internacionales para auditar a la IA de forma responsable. Estas son relevantes tanto para las empresas como para los gobiernos de todo el mundo.

Estos son algunos de los marcos más importantes, sus aplicaciones y la explicación de como adoptarlos:

| Marco/norma | Descripción | Aplicación |

|---|---|---|

| ISO/IEC 42001 | Sistema de gestión integral para la IA, certificable, que establece un marco para implementar auditorías externas y garantizar el cumplimiento normativo. | Adoptado por grandes empresas e instituciones en la región. Facilita la implementación de un sistema estructurado de gestión de IA. |

| AI Act (Unión Europea) | Regulación legal que establece un marco normativo para la gestión de riesgos y protección de derechos en la IA. | Aunque es específico para Europa, varios países latinoamericanos están tomando inspiración para crear normativas similares. |

| NIST AI Risk Framework | Guía voluntaria que promueve la gestión de riesgos, la transparencia y la ética en los sistemas de IA, organizada en funciones de gobernanza y gestión de riesgos. | Utilizado como referencia en varios países de la región para adoptar buenas prácticas en la gobernanza de IA. |

| Guías de la OCDE | Principios éticos y operativos para una IA responsable, incluyendo transparencia, respeto a los derechos humanos y equidad. | Influyen en el diseño de políticas públicas y regulaciones en varios países latinoamericanos, sirviendo como base para una IA ética. |

Cómo adoptar estos marcos para auditar a la IA en Latinoamérica

- ISO/IEC 42001: las empresas pueden adoptar este estándar mediante la creación de sistemas de gestión internos y sometiéndolos a auditorías externas para garantizar su cumplimiento.

- AI Act: aunque todavía no es una regulación en América Latina, las compañías pueden adaptarse a sus principios mediante la implementación de políticas internas de gestión de riesgos y protección de datos.

- NIST AI Risk Framework: las empresas pueden utilizar este marco como referencia para establecer políticas de gobernanza y gestión de riesgos asociados a la IA.

- Guías de la OCDE: los gobiernos pueden integrar estos principios en el diseño de políticas públicas, y las empresas pueden adoptar estos valores éticos en el desarrollo y uso de sistemas de IA.

Regulaciones de Argentina a tomar en cuenta en una auditoria de IA

En términos generales, según comentó Favali, las regulaciones nacionales que deben tenerse en cuenta son:

- Articulo 43 de la Constitución Nacional (Habeas Data).

- Ley 25.326 de Protección de Datos Personales.

- Ley 27.483 que aprueba el Convenio 108 del Consejo de Europa para la protección de personas en el tratamiento automatizado de datos personales, Código Civil y Comercial y resoluciones de la Agencia de acceso a la información pública.

“Asimismo, deben tenerse en cuenta las normas específicas de acuerdo a la actividad o sector de que se trate, como por ejemplo salud, actividad financiera y bancaria, telecomunicaciones, consumo, etc.”, detalló la Abogada y Maestranda en IA.

“Si bien los marcos éticos resultan valiosos para fijar parámetros de buenas prácticas, debida diligencia y auditoría, en la actualidad se consideran “soft law”, es decir, instrumentos que orientan y sirven de guía, pero carecen de fuerza legal obligatoria”, añadió Favali.

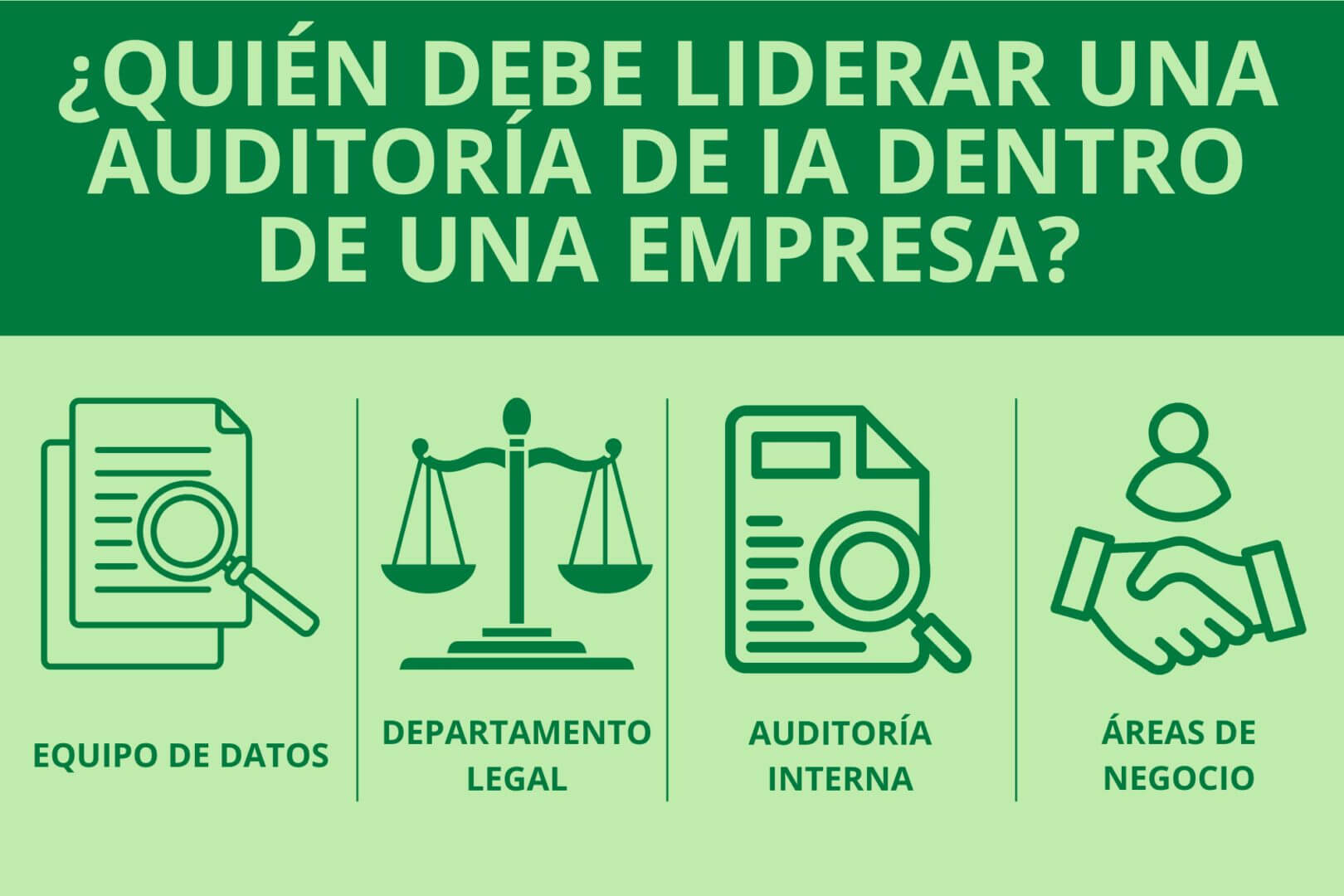

¿Quién debe liderar una auditoría de IA dentro de una empresa?

La auditoria de IA dentro de una empresa debe ser liderada por un equipo multidisciplinar que cuenten con competencias técnicas, legales y estratégicas para abordar los diferentes aspectos que conlleva el proceso. Solo un esfuerzo conjunto entre estos departamentos será efectivo para repeler los riesgos y asegurar la transparencia, confianza y cumplimiento en el uso de inteligencia artificial.

Estos son los perfiles que deben estar involucrados:

Equipo de datos

Este equipo, compuesto por científicos y analistas de datos, es responsable de evaluar el comportamiento de los modelos, la calidad de los datos, la detección de sesgos y el desempeño técnico. Su tarea principal es garantizar la integridad y la trazabilidad del ciclo de vida del modelo.

Departamento legal y de cumplimiento

Este grupo se encarga de garantizar que el modelo cumpla con las regulaciones vigentes y las políticas internas. Se enfoca en la gestión de riesgos legales, éticos y de privacidad, y supervisa que el modelo cumpla con los marcos aplicables para evitar sanciones y asegurar que las decisiones sean transparentes y responsables.

Auditoría interna

La auditoría interna tradicionalmente asegura controles y procedimientos, pero ahora debe incorporar competencias renovadas para auditar a la IA, que incluyen la gobernanza tecnológica y la ética. Este equipo debe ofrecer una visión independiente y objetiva sobre los riesgos y el desempeño del modelo para integrar las perspectivas técnica, legal y empresarial.

Áreas de negocio y dirección

El liderazgo estratégico es fundamental para alinear la auditoría de IA con los objetivos empresariales y la visión de la compañía. Las áreas de negocio deben proporcionar contexto sobre cómo las decisiones de la inteligencia artificial impactan en la estrategia y colaboran en la definición de los riesgos más importantes para una compañía.

¿Cada cuánto tiempo debe auditar a la IA en una empresa?

La frecuencia con la que se debe auditar a la IA varía según el tipo de modelo y el contexto en el que se utilice.

Estas son algunas recomendaciones específicas para diferentes tipos de modelos de IA, junto con algunos criterios para establecer revisiones periódicas:

| Tipo de IA | Frecuencia de Auditoría | Criterios |

|---|---|---|

| Estática | Anual o semestral | Estabilidad, cumplimiento, rendimiento, contexto externo. |

| Adaptativa | Trimestral o semestral | Trazabilidad, control de cambios, sesiones en tiempo real. |

| Generativa | Trimestral o monitoreo continuo | Sesgos, ética, precisión, impacto social y legal, monitoreo permanente. |

IA Estática

Los modelos estáticos utilizan datos y lógica fija, sin actualizaciones o aprendizaje en tiempo real. Estos modelos no se modifican durante su ciclo de vida, por lo que su auditoría puede ser menos frecuente. La frecuencia recomendada es una vez por semestre o incluso una vez al año.

Criterios a tener en cuenta:

- Verificar la persistencia de desempeño.

- Asegurar la estabilidad de los datos de entrada.

- Evaluar el cumplimiento de las normas.

- Detectar sesgos nuevos derivados de cambios en el contexto.

IA Adaptativa

Los modelos adaptativos se actualizan periódicamente con nuevos datos y ajustan su comportamiento en función de la información nueva. Este tipo de modelo necesita de una revisión más frecuente debido a que sus modificaciones se dan con frecuencia. Es recomendable auditar a la IA cada trimestre o semestre, de acuerdo al ritmo de actualización del sistema.

Criterios a tener en cuenta: :

- Evaluar la trazabilidad de los datos actualizados.

- Comprobar la efectividad de los controles para evitar sesgos.

- Asegurar la integridad de la gobernanza de los cambios.

- Responder rápidamente a desviaciones inesperadas en el modelo.

IA Generativa

Los modelos generativos producen contenido nuevo y presentan una alta variabilidad y complejidad. Dado su impacto potencial y los riesgos que pueden generar, es fundamental realizar auditorias trimestrales o incluso continuas mediante monitoreo automatizado.

Criterios a tener en cuenta: :

- Control exhaustivo de sesgos presentes en los resultados generados.

- Asegurarse de que el modelo cumpla con estándares éticos y no genere contenido dañino o engañoso.

- Verificar la exactitud en casos de uso.

- Monitoreo del impacto social y legal de los contenidos generados.

Criterios generales para auditar a la IA

Independientemente del tipo de inteligencia artificial que se utilice, existen varios factores comunes que deben influir en la frecuencia de las auditorías:

- Impacto en el negocio: las aplicaciones de IA más reguladas necesitan de una mayor frecuencia de auditoría.

- Cambios en el modelo: las actualizaciones o reentrenamientos del modelo deben motivar auditorías adicionales para garantizar que no se introduzcan errores o sesgos.

- Exposición a riesgos: los modelos que son susceptibles a sesgos o decisiones discriminatorias deben ser monitoreados con mayor frecuencia.

- Regulaciones: el cumplimiento de las normas locales e internacionales puede determinar la periodicidad de las auditorías.

- Automatización y monitoreo: las herramientas de auditoría basadas en IA realizan auditorías en tiempo real, lo que reduce la necesidad de tener que hacer chequeos de forma manual con frecuencia.

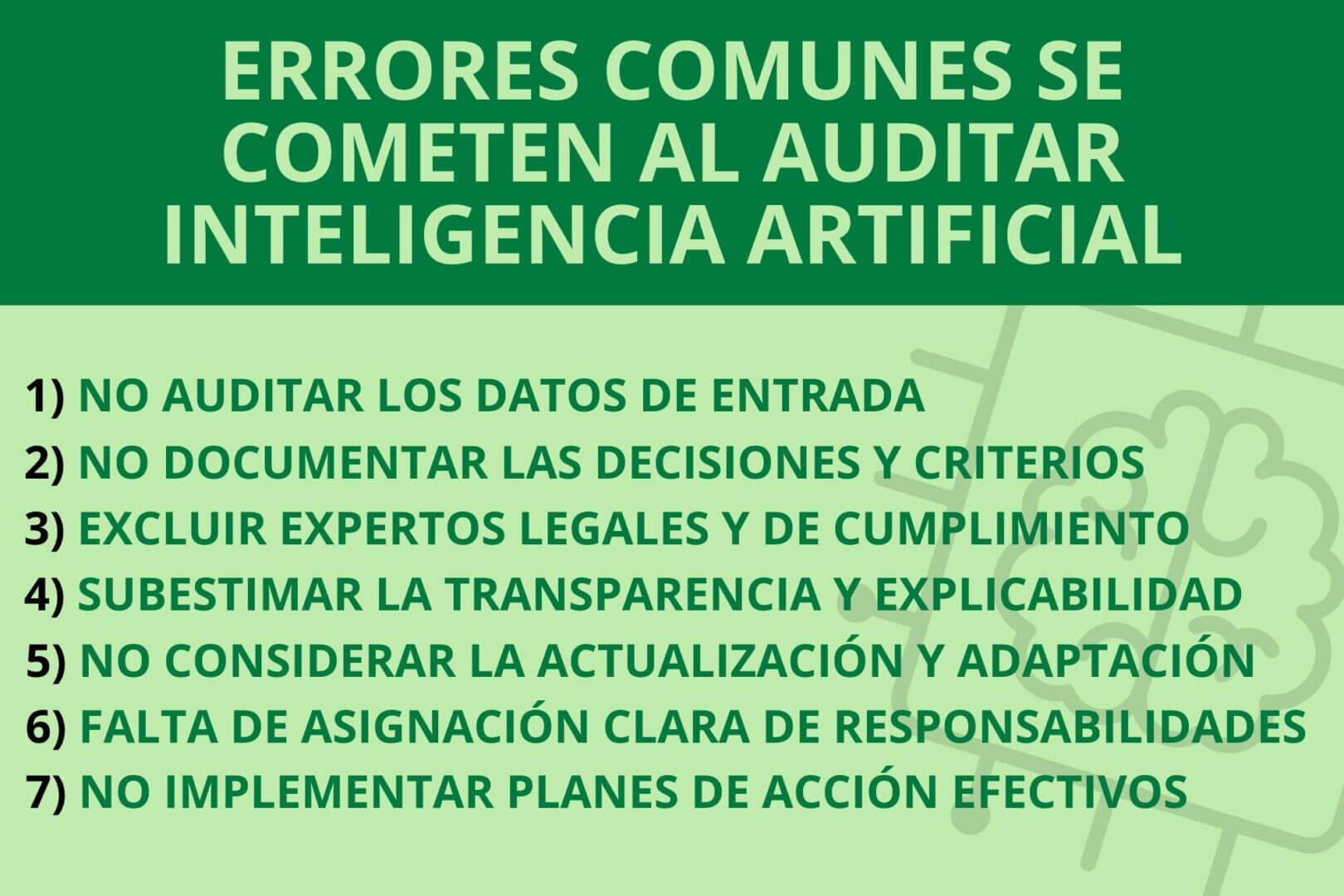

¿Qué errores comunes se cometen al auditar a la IA?

A la hora de auditar a la IA, es de vital importancia evitar estos errores comunes que pueden comprometer la efectividad de la auditoría y aumentar los riesgos para la empresa:

- No auditar los datos de entrada: ignorar la calidad, integridad y sesgos presentes en los datos base puede llevar a conclusiones erróneas y a riesgos no detectados.

- No documentar las decisiones y criterios utilizados durante la auditoría: la falta de trazabilidad dificulta la reproducibilidad de la auditoría, la realización de seguimientos y la explicación de los resultados.

- Excluir expertos legales y de cumplimiento: no incluir a estos profesionales puede derivar en incumplimientos regulatorios o éticos que afecten a una empresa.

- Subestimar la necesidad de transparencia y explicabilidad en los modelos auditados: la falta de claridad en cómo se toman las decisiones limita la identificación de errores o sesgos ocultos.

- No considerar la actualización y adaptación: auditar a la IA una sola vez sin realizar revisiones periódicas puede dejar pasar desviaciones generadas por actualizaciones o cambios en los modelos.

- Falta de asignación clara de responsabilidades: sin roles bien definidos, la supervisión y la mejora de la IA se vuelve débil o inexistente.

- Descuidar la supervisión posauditoría y no implementar planes de acción efectivos: no seguir con un plan de corrección posterior a la auditoría puede dejar sin resolver fallos detectados en el modelo

Preguntas frecuentes

¿Qué diferencia hay entre una auditoría ética y una auditoría técnica de IA?

La auditoría ética evalúa principios como equidad y derechos humanos, mientras que la técnica revisa aspectos como trazabilidad, precisión o desempeño del modelo.

¿Cómo se puede automatizar una auditoría de IA en tiempo real?

Mediante herramientas de monitoreo continuo que analizan decisiones, detectan desviaciones y generan alertas ante posibles riesgos o sesgos en producción.

¿Qué sectores deben priorizar auditorías más frecuentes?

Salud, finanzas, recursos humanos y justicia, donde el impacto de la IA sobre personas es más directo y regulado, requieren auditorías más estrictas y frecuentes.

¿Es posible auditar modelos de lenguaje como los LLMs?

Sí, pero se necesita aplicar técnicas especializadas para evaluar generación de contenido, trazabilidad, sesgos y seguridad contextual en tiempo real.

¿Qué métricas pueden indicar que una IA está tomando decisiones injustas?

Diferencias significativas en tasas de error o aceptación entre grupos demográficos, o patrones de salida que favorecen sistemáticamente a ciertos perfiles.

¿Cómo influye una auditoría en la reputación de una empresa?

Una auditoría transparente y bien comunicada genera confianza en clientes, regula riesgos legales y mejora la percepción de responsabilidad corporativa.