Mientras la inteligencia artificial (IA) se integra en los procesos de negocio cada vez más, entender qué es el Test de Turing es fundamental para los directivos de TI. Más que un ejercicio teórico, es un experimento que se convirtió en una referencia estratégica. Al momento de decidir qué soluciones de IA implementar, conocer esta prueba supone disponer de un criterio adicional para tener en cuenta.

Hoy en día, el Test de Turing ofrece un marco para evaluar si un sistema puede mantener conversaciones con una fluidez similar a la humana. Al mismo tiempo, es un punto de partida para discutir los límites de la IA en las empresas. Si bien existen métricas complejas sobre precisión, escalabilidad o integración, la prueba mantiene su vigencia al intentar responder una pregunta que invita a la reflexión. ¿Puede una máquina comprender y comunicarse en el nivel esperado por la organización?

Comprobar si una computadora puede “pensar” como un ser humano es bastante complejo, sobre todo porque ni siquiera está tan bien definido cómo pensamos nosotros. Sin embargo, el Test de Turing es la forma más clásica que existe para verificar si una máquina es digna de ser calificada como “inteligente”.

Índice de temas

¿Cuál es el origen del Test de Turing?

De acuerdo con el Laboratorio Nacional Lawrence Livermore (LLNL), en 1950, el matemático inglés y pionero de la informática Alan Turing se preguntó: “¿Pueden pensar las máquinas?”. Tras esto, en su artículo “Maquinaria Computacional e Inteligencia”, diseñó el Test de Turing con fin objetivo de hallar una respuesta.

El Test de Turing se basaba en una adaptación de un juego de estilo victoriano. Este consistía en aislar a un hombre y una mujer de un interrogador, quien debía adivinar cuál era cuál. No obstante, en la versión de Turing, el programa de ordenador reemplazaba a uno de los participantes. Así, el interrogador debía determinar cuál era el ordenador y cuál el humano. En caso de que no pudiera hacerlo, se llegaba a la conclusión de que el ordenador tenía la capacidad de pensar.

¿Cómo funciona el Test de Turing?

Tal como indica la Universidad IE, el Test de Turing propone una forma de identificar si una máquina exhibe una inteligencia similar a la humana. Para comprobarlo, un interrogador debe realizar consultas a ambos participantes sin tener conocimiento previo de cuál es cuál. De esta forma, solo con una serie de preguntas tendría que poder reconocer a cada uno.

En pocas palabras, la prueba es un juego de imitación en el que una máquina debe hacerse pasar por un humano. Las preguntas deben tratarse de un tema en concreto, en un formato y contexto determinado, y tienen que ser respondidas por escrito por ambos participantes.

Según la Enciclopedia Abierta de la Ciencia Cognitiva del MIT, el Test de Turing tiene cinco características clave. Estas son:

- La prueba evalúa la capacidad de la máquina para la conversación en dominio abierto. Esto lo diferencia de las pruebas de sistemas expertos, que se limitan a un campo estrecho.

- Si una máquina obtiene buenos resultados en la prueba, se considera que piensa en el sentido cotidiano de “pensar”.

- Si una máquina no obtiene buenos resultados en la prueba, no se deduce que no piense. La razón es que obtener buenos resultados es una condición suficiente, pero no necesaria, para pensar, por lo que no constituye una definición.

- La prueba es cualitativa y discursiva, y descarta las preguntas capciosas que suelen utilizar los informáticos para desenmascarar a los chatbots.

- La prueba es independiente de la arquitectura. Turing propuso diferentes modelos de máquina y sugirió la construcción de máquinas infantiles robóticas como vía hacia la inteligencia artificial.

En esencia, el Test de Turing no es un reto a una inteligencia artificial para que se comporte de forma humana. En cambio, es un desafío a un algoritmo para que se oculte mediante la aleatoriedad hasta el punto de dar la impresión de no existir.

¿Cuáles son las fortalezas del Test de Turing?

La permanencia del Test de Turing en el debate sobre la IA se debe, en gran medida, a las virtudes que lo sostienen. De acuerdo con Historytools, entre sus principales fortalezas se destacan tres aspectos que explican por qué mantiene su vigencia.

Uno de los beneficios del Test de Turing es que ofrece un punto de referencia práctico y tangible para medir la IA. Frente a métricas más abstractas o matemáticas, este enfoque se centra en la interacción conversacional, un terreno donde resulta más sencillo juzgar si una máquina logra imitar el pensamiento humano.

Por otro lado, el formato de diálogo libre permite escalar la dificultad de la prueba. A medida que las capacidades del lenguaje en los modelos de IA se sofistican, la prueba no queda obsoleta. En cambio, puede complejizarse con preguntas más abiertas, contextuales o desafiantes. De esta manera, se adapta al progreso tecnológico y mantiene su relevancia como mecanismo de evaluación.

Asimismo, el Test de Turing se distingue por basar la medición de la inteligencia en un criterio antropocéntrico como la conversación. Al utilizar la comunicación natural como estándar, refuerza una visión en la que la inteligencia se valora según la capacidad de replicar un rasgo central de la especie humana.

¿Cuáles son los riesgos y limitaciones del Test de Turing?

Si bien sus fortalezas lo mantienen en pie, el Test de Turing no está exento de limitaciones. En este sentido, según Science News Today, la prueba deja varios territorios sin explorar.

En primer lugar, el Test de Turing no demuestra comprensión. Una máquina puede generar respuestas convincentes sin comprender su significado. Esto fue ilustrado por el filósofo John Searle en su crítica conocida como la “Habitación China“. Si una persona que no sabe chino está sentada en una habitación con un conjunto de reglas para manipular símbolos chinos, puede producir resultados indistinguibles de los de un hablante nativo. Sin embargo, seguirá sin comprender el idioma.

En segundo lugar, la prueba no demuestra la consciencia. Una máquina puede parecer reflexiva a pesar de no tener experiencia interna. Puede escribir poemas sobre el amor sin sentir el amor, o hablar de la mortalidad sin percibir su propia finitud. En consecuencia, pasar la prueba no revela si existe algo parecido a ser esa máquina.

En tercer lugar, la prueba no garantiza una inteligencia general. Una máquina podría estar entrenada en trucos conversacionales, pero también podría ser incapaz de realizar razonamientos más profundos. Esta podría ganar la imitación sin poseer la inteligencia amplia y flexible que los humanos exhiben en innumerables contextos.

Ejemplos corporativos actuales del Test de Turing

Aunque el test de Turing no se utilice de forma literal en entornos empresariales, múltiples aplicaciones demuestran cómo los algoritmos buscan hacerse pasar por humanos. A continuación, algunos ejemplos corporativos actuales:

- Chatbots financieros: Bancos y fintech despliegan sistemas conversacionales que responden consultas sobre saldos, tarjetas o inversiones.

- Asistentes virtuales en salud: Hospitales y aseguradoras utilizan IA para orientar pacientes, brindar información sobre síntomas y gestionar turnos médicos.

- Soporte corporativo y de e-commerce: Plataformas como marketplaces o servicios de telecomunicaciones implementan asistentes que resuelven reclamos y dudas frecuentes.

- IA generativa en creatividad y comunicación: Se utilizan herramientas que redactan correos, generan presentaciones o diseñan borradores de campañas de marketing.

- Sistemas de voz y asistentes de productividad: Se emplean dispositivos y aplicaciones que permiten agendar reuniones, organizar tareas o responder llamadas.

Aplicación práctica del Test de Turing

El Test de Turing surgió como un experimento teórico. Pese a esto, hoy en día las empresas pueden utilizarlo de diferentes formas. Por ejemplo, esta lógica podría implementarse para probar chatbots de IA antes de lanzarlos a producción.

Se puede pensar en una empresa que desea implementar un asistente conversacional que responda consultas sobre licencias, beneficios o capacitaciones. Antes de habilitarlo a todos los empleados, el equipo de innovación organiza una prueba. Esta consiste en que un conjunto de colaboradores debe conversar con dos interfaces: una atendida por un humano y otra por el chatbot, sin saber cuál es cuál.

El objetivo es medir la fluidez y naturalidad de las respuestas del nuevo chatbot, la pertinencia de la información y la capacidad de manejo de desvíos. Esto es, si puede redirigir una consulta inesperada sin bloquearse.

Frente a esto, si los usuarios no logran diferenciar al chatbot del operador humano en la mayoría de los casos, el sistema puede considerarse listo para un piloto. En cambio, si la máquina queda expuesta con facilidad, la prueba se convierte en una señal de ajuste. Antes de lanzarlo, se deben revisar los datos de entrenamiento, mejorar el lenguaje natural o incorporar reglas de fallback.

¿Alguna máquina pasó el test de Turing?

Desde hace tiempo, existe cierto debate en torno a si alguna máquina pudo pasar el Test de Turing alguna vez. Según My Learning, dos de los casos más notables a lo largo de la historia son el de Eugene Goostman y LaMBDA de Google.

Eugene Goostman

Eugene Goostman fue un chatbot diseñado para imitar a un niño ucraniano de 13 años, generó titulares en 2014 al superar, o no, el Test de Turing en un evento organizado por la Universidad de Reading. Según los organizadores, el sistema convenció al 33% de los jueces de que era una persona real. Sin embargo, la noticia estuvo rodeada de fuertes cuestionamientos.

Las críticas apuntaron a que los criterios de la prueba se habían relajado en exceso. La caracterización del sistema como un adolescente extranjero con limitado dominio del inglés facilitó que sus fallos de lógica, gramaticales o culturales fueran percibidos como parte de su personaje. Además, el sistema recurría con frecuencia a respuestas evasivas, chistes y frases prefabricadas, lo que ponía en duda su auténtica capacidad de razonamiento. También se cuestionó el rigor del evento en sí, ya que hubo menos jueces de los previstos, no existió un grupo de control humano y la evaluación careció de revisión independiente.

LaMBDA de Google

Años más tarde, en 2021, Google presentó LaMBDA (Language Model for Dialogue Applications). Se trata de un sistema de procesamiento de lenguaje natural (PLN) que sorprendió por la fluidez y coherencia de sus respuestas en demostraciones públicas. Durante la conferencia de desarrolladores, el sistema mostró una notable capacidad para mantener el hilo lógico de un diálogo. Sin embargo, Google nunca afirmó que el modelo hubiera superado el Test de Turing.

El proyecto todavía es experimental y enfrenta limitaciones importantes. Por ejemplo, no cuenta con memoria ni objetivos propios, y responde solo en función de la interacción inmediata. Pese a que un ingeniero de Google llegó a sostener que había mostrado señales de “sensibilidad” tras una conversación sobre el alma, la compañía aclaró que se trataba de una interpretación errónea de las capacidades del sistema. En consecuencia, más allá de sus avances técnicos, LaMBDA no puede considerarse una máquina que haya pasado la prueba propuesta por Alan Turing.

¿Qué es el programa ELIZA?

El Test de Turing fue reformulado a lo largo de los años. Las razones van desde la imprecisión de la versión original hasta la aparición de nuevos problemas en la definición de una máquina inteligente. Uno de los programas que obligaron a repensar los criterios de las pruebas es conocido como ELIZA.

Tal como indica GeeksforGeeks, ELIZA es un programa informático desarrollado por Joseph Weizenbaum que simula una conversación mediante la coincidencia de patrones y sustitución. Fue diseñado con el fin de imitar a un psicoterapeuta rogeriano y, al responder a los usuarios, crear la ilusión de comprensión.

El funcionamiento de ELIZA se basa en tres pasos. El primero es el procesamiento de entrada, cuando recibe la información del usuario y busca palabras clave o frases específicas. Tras esto, el segundo es la coincidencia de patrones, cuando aplica reglas simples para responder. Por último, el tercero es la generación de respuestas, en donde recurre a respuestas genéricas.

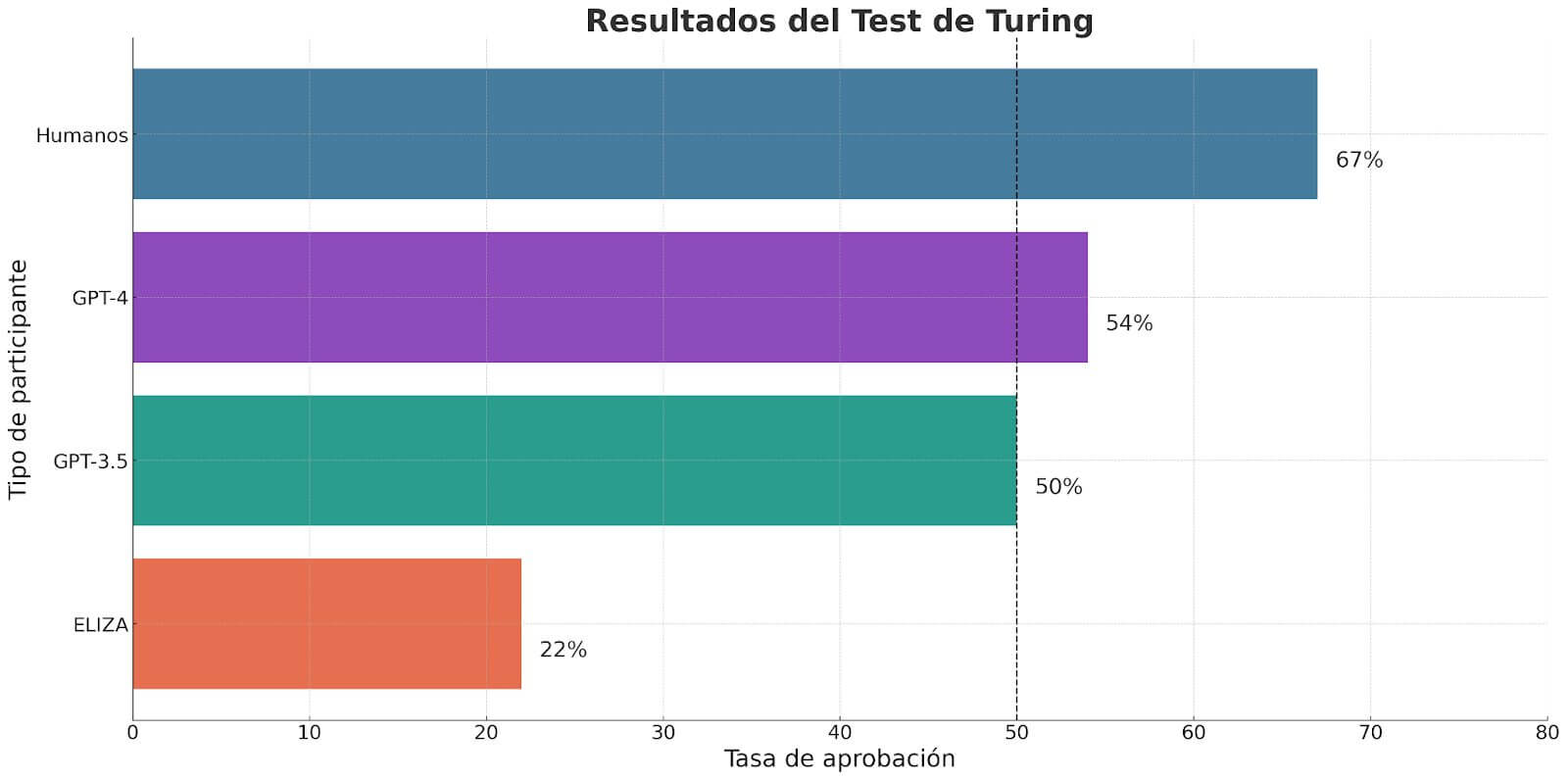

En un estudio reciente, publicado en arXiv, los investigadores de la Universidad de California en San Diego alojaron una implementación para dos jugadores del Test de Turing en un sitio web. Su objetivo era evaluar las respuestas de los sistemas ELIZA, GPT-3.5 y GPT-4. En caso de que en más del 50% de las oportunidades fueran reconocidos como humanos, conseguirían pasar la prueba.

El programa ELIZA fue identificado como humano el 22% de las veces. Por su parte, aunque quedó por detrás de los humanos reales, que registraron un 67%, GPT-4 hizo lo propio en el 54% de las ocasiones. De este modo, los resultados constituyeron la primera demostración empírica sólida de un sistema artificial que supera un Test de Turing interactivo de dos jugadores.

Variantes del Test de Turing

Desde que Alan Turing formuló su famoso experimento, surgieron diversas versiones y adaptaciones que buscan explorar diversos aspectos de la IA. Estas variantes reflejan los avances tecnológicos y los debates filosóficos en torno a la mente, el lenguaje y la creatividad. De acuerdo con Coursera, algunas de las más conocidas son:

| Variante | Descripción |

| Test de Marcus | Creada por el científico cognitivo Gary Marcus, se centra en comprobar si una IA puede interpretar el significado de un video. No solo se observa si entiende la trama, sino también si reconoce el humor, la ironía o el sarcasmo. Para superarla, la máquina debe describir la pieza audiovisual con la misma naturalidad que lo haría una persona. |

| Test de Lovelace | Inspirada en las ideas de Ada Lovelace, se utiliza para indagar si un sistema de IA es capaz de producir creaciones originales. Esto quiere decir, resultados que vayan más allá de la información con la que fue entrenado. |

| Test de Turing inverso | El objetivo es engañar a una IA que actúa como juez y hacerle creer que un humano es en realidad una máquina. Para ello, se necesita la participación de otra IA y un ser humano que respondan a las preguntas. El desafío consiste en que el juez automatizado identifique al participante humano. |

| Test de Turing visual | Diseñada por Michael Barclay y Antony Galton, examina si un sistema informático puede mostrar habilidades visuales comparables a las humanas. El reto consiste en reconocer elementos, detalles y características dentro de imágenes de la misma forma en que lo haría una persona. |

De Turing a Asimov: las tres leyes de la robótica

La intuición de Turing sirvió de base al pensamiento de otro gran visionario de la IA, el escritor Isaac Asimov. Asustado por el avance de los robots, inventó las tres leyes de la robótica, precursoras de la roboética o ética de la robótica. Se trata de reglas que rigen las relaciones entre los humanos y los robots, o mejor dicho, las diferentes formas de inteligencia artificial con las que ya convivimos.

Las tres leyes de la robótica de Asimov son:

- Un robot no puede dañar a un ser humano, ni puede permitir que un ser humano sea dañado por su falta de actuación.

- Un robot debe obedecer las órdenes dadas por los seres humanos, siempre que esas órdenes no contradigan la Primera Ley.

- Un robot debe proteger su propia existencia, siempre que salvaguardarla no entre en conflicto con la Primera o Segunda Ley.

Test de Turing en la era de la inteligencia artificial

Más de siete décadas después de que Alan Turing planteara su experimento, la pregunta sobre si una máquina puede pensar todavía está en el centro del debate. En plena expansión de la IA generativa, esta prueba vuelve a ser relevante, aunque también enfrenta nuevos cuestionamientos.

La aparición de modelos como ChatGPT-4, Gemini 3 o Claude 1.5 puso a prueba los límites del Test de Turing. Estas herramientas pueden mantener conversaciones fluidas, escribir textos complejos e incluso mostrar creatividad aparente. Sin embargo, los especialistas subrayan que la imitación del lenguaje no equivale a comprensión real ni conciencia. Además, señala que el Test de Turing, en su concepción original, puede resultar insuficiente para medir la verdadera inteligencia de las máquinas.

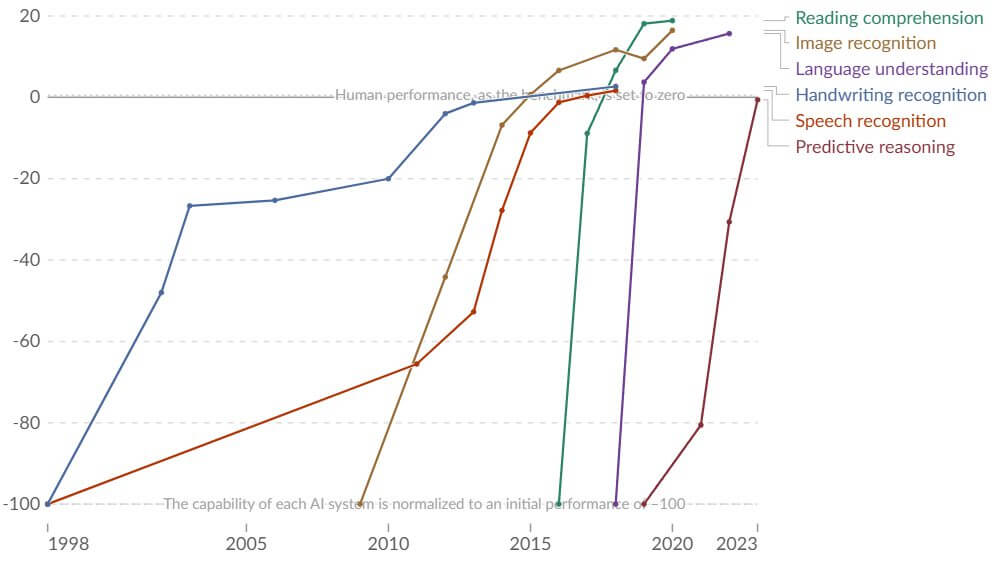

En un estudio reciente, publicado por Our World In Data, se analizaron las últimas dos décadas del desarrollo de la IA. Se evaluó el rendimiento de los humanos y de la IA en diferentes dominios, como el reconocimiento de escritura a mano, el reconocimiento de voz, el reconocimiento de imágenes, la comprensión lectora, la comprensión del lenguaje y el razonamiento predictivo.

Dentro de cada dominio, el rendimiento inicial de la IA se estableció en -100, y el rendimiento humano, establecido en 0, se utilizó como referencia. De esta forma, cuando la IA superara el cero, significaría que obtuvo más puntos que los humanos.

El estudio concluye que hace tan solo 10 años, ninguna máquina podía proporcionar reconocimiento de lenguaje o imágenes de forma fiable a nivel humano. Sin embargo, los sistemas de IA se volvieron mucho más capaces y ahora superan a los humanos en estos ámbitos, al menos en algunas pruebas.

A día de hoy, el debate se amplía hacia criterios más exigentes como la capacidad de razonamiento, la gestión ética de la información, la explicabilidad de los modelos y el impacto social de la IA. Sin embargo, la pregunta de Turing todavía sigue abierta.

Preguntas frecuentes sobre Test de Turing

¿Qué es el Test de Turing y qué busca demostrar?

El Test de Turing es una prueba diseñada para evaluar si una máquina puede imitar el lenguaje humano de forma convincente. Busca demostrar si un sistema de inteligencia artificial puede mantener una conversación tan natural que un interlocutor no pueda distinguirlo de una persona real.

¿Quién creó el Test de Turing y por qué sigue siendo relevante para las empresas?

El matemático Alan Turing propuso el test en 1950 como un criterio para determinar si una máquina puede “pensar”. En entornos corporativos, sigue siendo clave para evaluar la fluidez conversacional de soluciones de IA, como chatbots o asistentes virtuales, antes de su implementación.

¿Cómo aplicar el Test de Turing en una estrategia de IA empresarial?

Puede usarse como prueba piloto antes del despliegue de sistemas de IA conversacional. Involucra comparar las respuestas del sistema con las de un humano en escenarios reales para medir si la experiencia del usuario es indistinguible, asegurando calidad, naturalidad y pertinencia.

¿Por qué el Test de Turing no es suficiente para evaluar toda la inteligencia artificial?

Porque solo mide la capacidad de imitación conversacional, pero no evalúa comprensión, razonamiento profundo, ética ni consciencia. Las empresas deben complementarlo con métricas de rendimiento, precisión, sesgos, explicabilidad y cumplimiento normativo en sus sistemas de IA.