La velocidad de respuesta y la capacidad de adaptación son características que marcan la diferencia en el ámbito empresarial. Frente a esto, entender cómo se entrenan los modelos de IA deja de ser un asunto técnico para convertirse en una ventaja estratégica.

En este sentido, el entrenamiento de estos modelos permite transformar datos en conocimiento accionable, generar procesos más eficientes y elevar la productividad de los equipos.

El impacto de los modelos de IA va más allá de la eficiencia operativa. Su entrenamiento continuo abre la puerta a experiencias personalizadas para clientes y colaboradores. Además, las organizaciones que los adoptan desarrollan capacidades internas que las posicionan mejor frente a los desafíos del mercado.

Uno de los ejemplos más conocidos es ChatGPT. La forma en que se presenta al usuario final es ahora conocida por el gran público. Sin embargo, lo que se puede ver al ingresar en chat.openai.com es solo parte de una aplicación web con una interfaz conversacional que parece sencilla. Para comprender cómo se entrenan los modelos de IA, es necesario detenerse en lo que hay detrás de ellos.

OpenAI creó esta tecnología para ofrecer una aproximación accesible a herramientas avanzadas de inteligencia artificial (IA), que antes solo podían ser utilizadas por desarrolladores. Estas tecnologías, que operan detrás de las cortinas de ChatGPT, fueron creadas a partir de la combinación de algoritmos de IA y grandes volúmenes de datos, en un proceso de entrenamiento continuo que nos permite dimensionar su poder y potencial.

Índice de temas

¿Qué es un modelo de IA?

Según IBM, un modelo de IA es un programa entrenado con un conjunto de datos para reconocer ciertos patrones o tomar decisiones sin intervención humana. Se trata de un sistema que aplica diferentes algoritmos a las entradas de datos relevantes para lograr las tareas o resultados para los que fue programado.

En el caso de ChatGPT, utiliza los modelos GPT-3, GPT-4 y GPT-5 y se especializa en el procesamiento del lenguaje natural. Esto le permite comprender y generar texto de manera fluida y coherente.

¿Qué son los Modelos de Lenguaje Grande (LLM)?

Tal como indica la Universidad de Stanford, los Modelos de Lenguaje Grande (LLM) son un tipo de inteligencia artificial diseñada para comprender y generar textos de tipo humano a partir de la información que reciben. Estos se construyen mediante técnicas de aprendizaje profundo que les permiten procesar grandes cantidades de datos textuales y aprender patrones complejos del lenguaje.

GPT-3, GPT-4 y GPT-5 son parte de lo que llamamos modelos de lenguaje grande. Estos fueron entrenados en vastas cantidades de datos para responder a preguntas, generar contenido y realizar análisis complejos. Su impacto cambia la forma en que interactuamos con la tecnología, lo que se refleja tanto en tareas cotidianas como en soluciones empresariales especializadas.

Otros modelos como BERT y LaMDA de Google también juegan un papel importante en el desarrollo de la IA. Sin embargo, GPT-3, GPT-4 y GPT-5 destacan por su capacidad para procesar y generar texto en múltiples idiomas y contextos. Esto los convierte en herramientas útiles para diversas aplicaciones empresariales.

Entrenamiento de modelos de IA: cinco etapas clave de la optimización algorítmica

Según la Oficina de Responsabilidad del Gobierno (GAO), la información de entrenamiento se utiliza para ayudar a los modelos de IA a aprender sobre el lenguaje y responder preguntas. La cantidad de datos empleados puede variar según el tipo de modelo.

El entrenamiento de modelos de IA se estructura en cinco etapas principales. Cada una de ellas implica tomar decisiones críticas que impactan en su calidad y aplicabilidad. De acuerdo con AICompetence.org, estas son:

1. Recopilación y preparación de los datos

El primer paso es comprender los distintos tipos de datos, ya que el elegido depende del objetivo del modelo. Por ejemplo, los datos de imagen son comunes en visión artificial, mientras que los datos de texto son cruciales para el procesamiento del lenguaje natural.

Tras esto, se tienen que encontrar fuentes de datos de calidad. Algunos ejemplos pueden ser los repositorios de aprendizaje automático, que ofrecen conjuntos de datos ideales para principiantes, o portales gubernamentales, ya que los datos públicos son confiables. El uso de datos reales puede hacer que el modelo sea más sólido.

Lo siguiente es la limpieza y organización de los datos. Rara vez vienen en un formato listo para usar, por lo que es probable que sea necesario eliminar los duplicados, controlar los valores faltantes, eliminar los campos de datos vacíos y garantizar la coherencia del formato.

2. Construcción y entrenamiento del modelo

Para comenzar a construir un modelo de IA, es fundamental seleccionar la arquitectura adecuada. Algunas de las más comunes son las redes neuronales convolucionales (CNN), las redes neuronales recurrentes (RNN) y las Transformers.

Al pasar a cómo se entrenan los modelos de IA, esto implica alimentarlos con datos y ajustar sus parámetros internos hasta que funcionen de manera correcta. Durante esta fase, los modelos aprenden de los datos de entrenamiento, pero validarlos con datos nuevos asegura una buena generalización.

3. Evaluación y ajuste del modelo

Una vez entrenado, es necesario evaluar el rendimiento del modelo. Algunas métricas que pueden utilizarse son la precisión, la recuperación y el error cuadrático medio. Esto permite comprobar qué tan bien podría funcionar en el mundo real.

Por otro lado, es momento de ajustar los hiperparámetros que controlan cómo aprende un modelo. Técnicas como la búsqueda en cuadrícula o la búsqueda aleatoria pueden mejorar el rendimiento. A su vez, algunos frameworks ofrecen opciones de ajuste automático para simplificar el proceso.

Para evitar el sobreajuste, que ocurre cuando el modelo funciona bien solo con los datos de entrenamiento, se puede recurrir a capas de abandono, regularizar el modelo o ampliar los datos para mejorar la generalización.

4. Implementación y mantenimiento del modelo

Al momento de implementar un modelo de IA, se debe elegir una plataforma acorde al alcance del proyecto, las necesidades de escalabilidad y el presupuesto. Además, se debe realizar un seguimiento continuo en el que se verifiquen las métricas de rendimiento, la eficacia en el mundo real y la desviación de los datos.

Con respecto a la seguridad del modelo, sobre todo si maneja datos confidenciales, es recomendable utilizar API seguras para proteger el acceso. Asimismo, se pueden hacer actualizaciones periódicas y cifrar los datos para proteger tanto al proyecto como a sus usuarios.

5. Solución de problemas comunes

Durante el proceso de cómo se entrenan los modelos de IA, es posible que se produzcan errores, por ejemplo, al probar diferentes arquitecturas y configuraciones de datos. Algunos de los más comunes son las altas tasas de error, la pérdida divergente y las gradientes que desaparecen o explotan. Reconocerlos a tiempo puede ahorrar tiempo y mejorar la precisión y estabilidad del modelo.

En caso de que se produzca un desequilibrio de datos, el remuestreo, la generación de datos sintéticos y la pérdida ponderada pueden contribuir a solucionarlo. Equilibrar los datos mejora la solidez del modelo y garantiza que no favorezca demasiado a una clase.

Por último, entrenar modelos grandes de IA requiere una gran potencia de cálculo. Para optimizarlos, se pueden entrenar en lotes pequeños, en lugar de introducir todos los datos a la vez, para reducir la carga de memoria. También se pueden utilizar modelos entrenados previamente.

Pre-training, fine-tuning y RLHF

Las etapas del entrenamiento de los modelos de IA pueden recibir distintos nombres. Sin embargo, el pre-training y el fine-tuning son dos enfoques que suelen ser producto de una extensa comparación en torno a numerosos factores.

Según un reporte de la Oficina de Derechos de Autor, el término “preentrenamiento” distingue a un tipo de entrenamiento centrado en la predicción precisa de ejemplos a partir de un gran conjunto de datos. Esto significa que se puede realizar un preentrenamiento continuo en un modelo ya entrenado. También puede representar una etapa preliminar de menor importancia en el entrenamiento de modelos de IA, aunque suele requerir órdenes de magnitudes mayores de datos y potencia de cálculo que otros entrenamientos.

Por otro lado, con respecto al “ajuste fino”, se indica que puede referirse a diversas actividades realizadas con diferentes objetivos. Algunas técnicas se centran en adaptar un modelo de propósito general para realizar tareas estrictamente definidas o generar contenido específico. Otras mantienen la naturaleza de propósito general del modelo, pero se centran en mejorar su capacidad para seguir instrucciones o generar resultados que se ajusten a las preferencias o intenciones humanas.

A continuación, un resumen de las principales diferencias entre el preentrenamiento y el ajuste fino, de acuerdo con llmmodels.org:

| Aspecto | Preentrenamiento | Ajuste fino |

| Método de aprendizaje | Autosupervisado | Supervisado |

| Datos requeridos | Gran volumen de datos no etiquetados | Menor cantidad de datos etiquetados |

| Costo computacional | Alto, ya que requiere mucho cómputo en grandes volúmenes | Moderado, ya que tiene un costo menor que entrenar desde cero |

| Conocimiento específico de tarea | Bajo, ya que ofrece una comprensión general del lenguaje, sin especialización | Alto, ya que se adapta a tareas o dominios específicos |

| Ventajas | No requiere anotaciones humanas, presenta una alta capacidad de transferencia y tiene un bajo riesgo de olvidar conocimientos generales | Mejora la precisión en tareas específicas, tiene flexibilidad para adaptarse a nuevos dominios y requiere menos recursos que un entrenamiento desde cero |

| Desventajas | Puede no funcionar bien en tareas concretas y tiene riesgo de olvido catastrófico al hacer un ajuste fino | Requiere muchos datos etiquetados que son costosos y tardados de generar y es propenso al sobreajuste de datos específicos |

Por otro lado, el RLHF (Aprendizaje por Refuerzo a partir de Retroalimentación Humana) es un método para optimizar modelos de IA y generar resultados que los humanos prefieren, según BlueDot Impact. Es la etapa que consume más recursos en el proceso de alineación y, en ocasiones, va precedida de un ajuste fino supervisado.

Si bien el ajuste fino mejora la especialización, no garantiza que el modelo responda de forma útil o segura. Por esta razón, en la etapa de RLHF, las respuestas del modelo son evaluadas por personas que indican cuáles son más adecuadas. Con esa retroalimentación humana, el modelo aprende a priorizar devoluciones más alineadas con los valores, las expectativas y las necesidades de los usuarios.

¿Cuál es el proceso de entrenamiento y optimización algorítmica de los modelos GPT?

Los modelos GPT, que alimentan a ChatGPT, pasan por un preentrenamiento intensivo que implica el uso de grandes cantidades de datos textuales. Estos provienen de diversas fuentes como Common Crawl, Wikipedia y Reddit, entre otras. En total, se procesan miles de millones de frases, lo que le permite al modelo comprender el lenguaje en múltiples contextos.

Tras esto, los desarrolladores deben diseñar instrucciones claras y detalladas que guíen al modelo para obtener las respuestas deseadas. Así se pasa al ajuste fino supervisado, en donde los datos más relevantes para una tarea específica se utilizan para entrenar al modelo.

A medida que ChatGPT empieza a generar respuestas, es importante proporcionar retroalimentación constante, corregir errores y afinar la precisión del modelo. Esto permite que se adapte mejor a los casos de uso específicos de la empresa.

¿Cómo se entrenan los modelos de IA para casos de uso específicos en empresas?

Una vez que los modelos de IA pasaron por un proceso de aprendizaje automático empresarial general, las empresas pueden ajustarlos y especializarlos para resolver problemas concretos mediante el ajuste fino. En este caso, deben alimentar al modelo con datos propios de la organización. Estos pueden ser, por ejemplo, interacciones reales con clientes, documentos internos, manuales de marca, procedimientos operativos y otros insumos relevantes.

De esta manera, el modelo adquiere la capacidad de responder con coherencia, tono de comunicación corporativo y eficiencia operativa en distintos contextos de negocio. Más allá de esta, el impacto se traduce en indicadores de negocio concretos: reducción de costos en servicio al cliente, optimización de la cadena de suministro y ahorro energético en procesos intensivos.

En este sentido, algunos de los casos de uso específicos más comunes son:

- Chatbots para atención al cliente: entrenados con registros de conversaciones y preguntas frecuentes, los chatbots permiten ofrecer respuestas rápidas y consistentes a los usuarios. Esto permite la reducción de tiempos de espera, la coherencia en la comunicación y la posibilidad de escalar la atención sin aumentar costos de personal. Según implementaciones en retail y banca, un chatbot entrenado puede reducir hasta un 30% los costos en centros de contacto, manteniendo la satisfacción del cliente. Para Gartner, la adopción de soluciones de IA generativa en atención al cliente permite equilibrar valor y viabilidad, y los líderes de servicio estiman su uso como una estrategia de alto impacto para reducción de costos, crecimiento de ingresos y mejora de la calidad del servicio.

- Asistentes internos para empleados: estos modelos se entrenan con políticas internas, bases de conocimiento y manuales de procedimientos. Sirven para resolver dudas frecuentes del personal o guiar procesos complejos mientras mejoran la eficiencia interna, disminuyen la dependencia de áreas de soporte y aseguran la alineación con protocolos establecidos.

- Generación de contenido corporativo: al ser ajustados con el tono de voz, guías editoriales y materiales previos de la empresa, los modelos pueden producir artículos, presentaciones y comunicados, entre otras cosas. El beneficio es la coherencia con la identidad de marca, la rapidez en la producción de materiales y la reducción de errores de estilo.

- Análisis de datos y reportes automatizados: entrenados con históricos de reportes, métricas y terminología del sector, los modelos de IA pueden generar resúmenes, visualizaciones y alertas personalizadas. Esto aporta precisión en la información, ahorro de tiempo y mayor capacidad de reacción frente a cambios en los indicadores de negocio. En el sector logístico, las empresas que aplican modelos de IA en su supply chain han logrado una reducción del 15% en inventarios inmovilizados, liberando capital de trabajo.

- Soporte en procesos de ventas y marketing: con datos de clientes, segmentación y estrategias previas, la IA puede sugerir mensajes personalizados, estructurar propuestas o automatizar interacciones iniciales. Esto permite mayor personalización, coherencia con la estrategia comercial y mejores tasas de conversión. En marketing, el uso de modelos entrenados para segmentar clientes permite aumentar entre 10% y 20% la tasa de conversión sin incrementar el gasto en campañas.

¿Cómo se da el entrenamiento de modelos de IA más utilizados?

Existen muchas otras inteligencias artificiales (IA) además de ChatGPT, cada una con sus particularidades, y la forma en que se entrenan puede variar según el tipo de IA y para qué fueron diseñadas. Estas son algunas de las más conocidas y cómo se preparan para cumplir su propósito:

1. BERT (Bidirectional Encoder Representations from Transformers)

BERT fue creado por Google para la comprensión del lenguaje natural. Ayuda tareas como la clasificación de textos o la mejora de la precisión de los motores de búsqueda.

Para su entrenamiento, BERT utiliza una técnica de aprendizaje profundo, pero con un truco bajo la manga. Es capaz de leer en dos direcciones, algo que la diferencia de otros modelos como GPT, que solo leen de izquierda a derecha. Dado que lee tanto hacia adelante como hacia atrás, puede considerar tanto lo que viene antes como lo que viene después, lo que le permite entender mejor el significado de una palabra dentro de una oración.

El proceso de entrenamiento de BERT tiene dos pasos clave. En el preentrenamiento, se entrena en grandes cantidades de texto con ejercicios como “predecir la palabra que falta” o “detectar si dos oraciones están conectadas”. Luego, en el ajuste fino, se ajusta para cumplir tareas más concretas, como responder preguntas o clasificar mensajes.

2. LaMDA (Language Model for Dialogue Applications)

LaMDA fue creada por Google como un modelo conversacional. Esto quiere decir que tiene la capacidad de mantener diálogos abiertos y fluidos.

LaMDA, al igual que GPT, usa una arquitectura Transformer, pero está diseñada para mantener conversaciones. Su mayor desafío es lograr que las respuestas no solo sean correctas, sino que además mantengan un tono coherente y natural, como si se conversara con una persona real.

Para entrenarla, se alimenta con una enorme cantidad de datos conversacionales. La clave es que LaMDA debe ser capaz de entender el contexto de una conversación completa, en lugar de solo responder a preguntas aisladas. Se somete a varias fases de entrenamiento y ajuste fino, con diálogos reales y simulados, con el objetivo de que el modelo pueda participar en diálogos largos y complejos sin perder el hilo de la conversación.

¿Cuáles son los riesgos y desafíos de cómo se entrenan los modelos de IA?

Además de ser un reto técnico, el entrenamiento de modelos de IA implica una serie de riesgos y desafíos que afectan su calidad, su confiabilidad y hasta su impacto en la sociedad. Según la Red de Recursos de Aprendizaje de California (CLRN), los seis principales son:

- Requisitos de datos: los modelos de IA requieren grandes cantidades de datos para aprender eficazmente, y obtenerlos y etiquetarlos puede ser un obstáculo importante.

- Recursos computacionales: entrenar modelos complejos de IA puede ser costoso, ya que requiere hardware especializado.

- Sobreajuste: el sobreajuste ocurre cuando el modelo aprende demasiado bien los datos de entrenamiento y no logra generalizarlos a nuevos datos.

- Sesgo e imparcialidad: los modelos de IA pueden heredar sesgos presentes en los datos de entrenamiento, lo que resulta en resultados injustos o discriminatorios.

- Explicabilidad e interpretabilidad: comprender cómo los modelos de IA toman decisiones es crucial para generar confianza y garantizar la rendición de cuentas.

- Ataques adversarios: los modelos de IA pueden ser vulnerables a ataques adversarios, que buscan engañar al modelo y hacer que realice predicciones incorrectas.

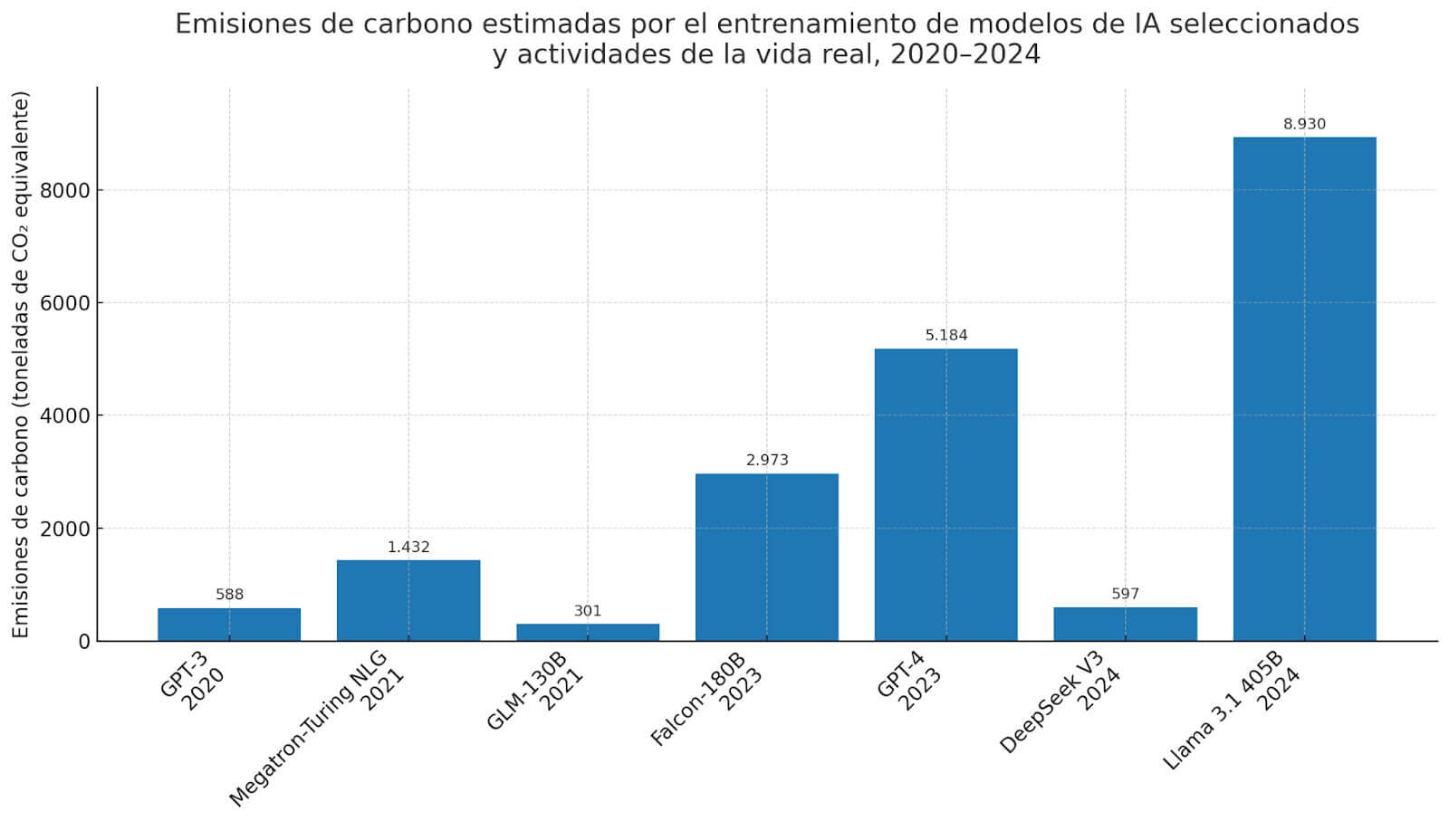

Asimismo, con respecto al impacto ambiental, el entrenamiento de modelos de gran escala demanda un gran consumo energético. Esto se traduce en emisiones de carbono que contribuyen al cambio climático y convierten a la sostenibilidad en un desafío clave para el futuro de la IA.

En este sentido, el Informe de Índice de IA 2025 de la Universidad de Stanford señala que las emisiones de carbono del entrenamiento de modelos de IA de vanguardia aumentaron de forma constante con el tiempo. Por ejemplo, GPT-3 emitió alrededor de 588 toneladas de carbono durante el entrenamiento, GPT-4 emitió 5.184 toneladas y Llama 3.1 405B emitió 8.930 toneladas.

El futuro de cómo se entrenan los modelos de IA

El entrenamiento de modelos de IA requiere de inversiones significativas y un trabajo constante de perfeccionamiento. Las empresas y desarrolladores deben asegurarse de que sus sistemas sean eficaces y fiables, minimizando los errores y maximizando el valor que estos modelos pueden ofrecer.

En un futuro próximo, es probable que la propia IA ofrezca nuevas herramientas para mejorar estos procesos, lo que llevará a resultados cada vez más precisos y adaptados a las necesidades de las empresas.

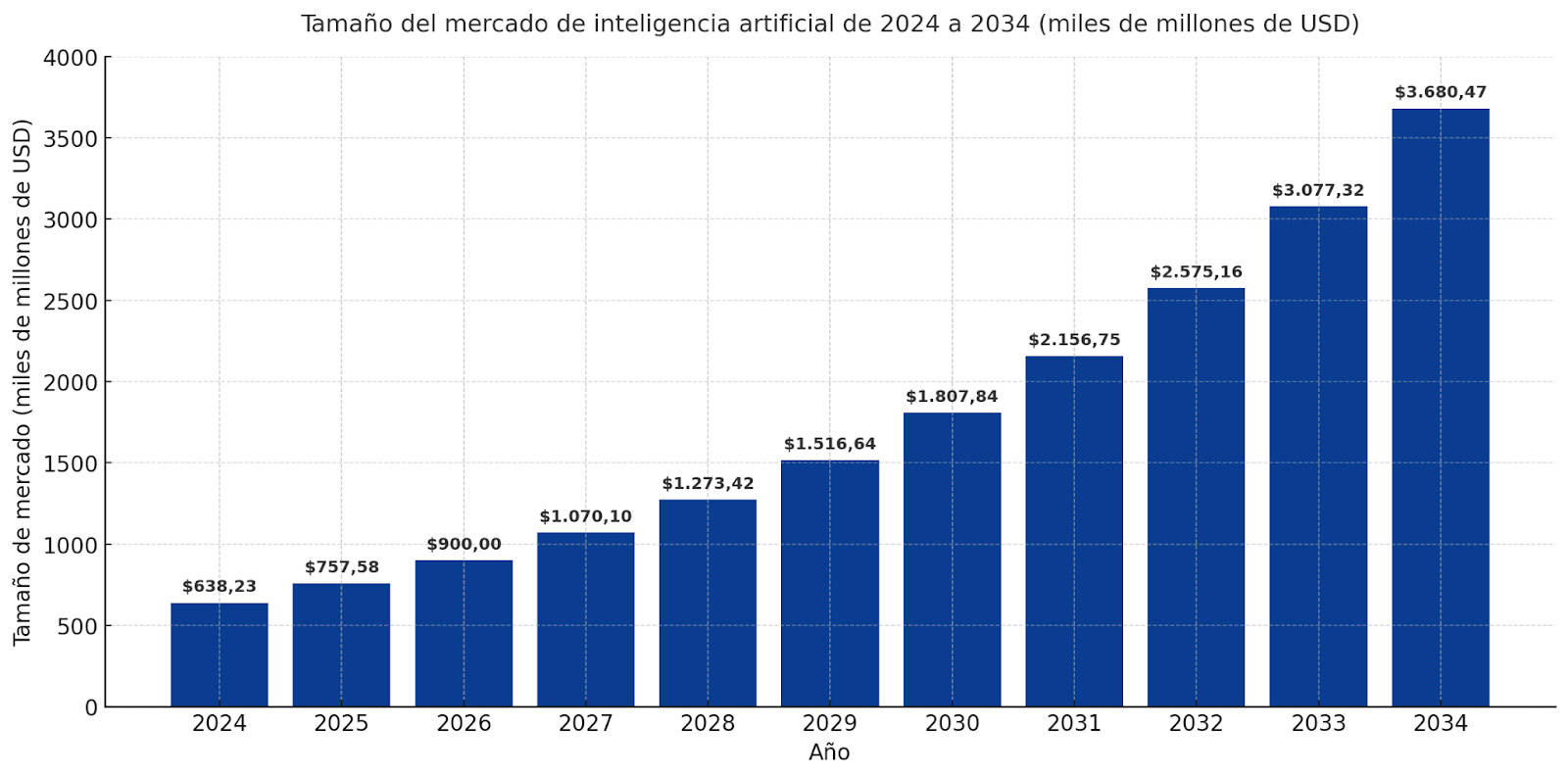

De acuerdo con Precendence Research, el tamaño del mercado global de inteligencia artificial (IA) fue de USD 638,23 mil millones en 2024 y se calcula que llegará a USD 638,23 mil millones en 2025. Además, se espera que alcance alrededor de USD 3.680,47 mil millones para 2034, lo que representa una tasa de crecimiento anual compuesta (TCAC) del 19,20%.

El entrenamiento de modelos de IA no solo implica innovación tecnológica, sino también un retorno medible: ahorro energético en data centers, reducción de costos operativos y mayor eficiencia en supply chain, factores que los directivos ya evalúan como diferenciales estratégicos.

De acuerdo con McKinsey, el impacto potencial de la IA en las empresas es enorme: según afirma en su reporte ‘Superagency in the workplace,’ estima un potencial de US $ 4,4 billones en productividad adicional derivado del uso corporativo de IA.

Preguntas frecuentes sobre el entrenamiento y aprendizaje automático de modelos de IA

¿Cuál es la diferencia entre fine-tuning y RLHF en el entrenamiento de modelos de IA?

El fine-tuning adapta un modelo general a tareas específicas mediante datos etiquetados, mientras que el RLHF (reinforcement learning with human feedback) optimiza las respuestas basándose en preferencias humanas. Ambos procesos mejoran la calidad, pero RLHF alinea mejor el modelo con criterios humanos.

¿Cuántos datos se necesitan para entrenar un modelo de IA desde cero?

Entrenar un modelo desde cero puede requerir desde millones hasta miles de millones de ejemplos, dependiendo del tipo (visión, lenguaje, tabular). Por eso, muchas empresas optan por modelos preentrenados y aplican fine-tuning con conjuntos más reducidos y específicos.

¿Qué retorno de inversión puede esperar una empresa al entrenar un modelo de IA interno?

El ROI se refleja en la automatización de tareas repetitivas, reducción de errores operativos y mayor agilidad en la toma de decisiones. Empresas que personalizan modelos con datos propios obtienen ventajas competitivas en precisión, eficiencia y fidelización de clientes.

¿Cómo se entrenan los modelos de IA de forma eficiente sin consumir recursos excesivos?

Para entrenarlos de forma eficiente, se aplican técnicas como transfer learning, entrenamiento por lotes pequeños y uso de modelos preentrenados. Además, se puede aprovechar infraestructura cloud con GPUs optimizadas y algoritmos que reducen el cómputo sin perder rendimiento.