Adobe está lista para revolucionar la forma en que las personas crean y editan audio y música personalizados. Gracias al trabajo experimental del equipo de investigación de Adobe, nació Project Music GenAI Control, una innovadora herramienta de generación y edición musical basada en inteligencia artificial generativa. Esta tecnología permite a los usuarios generar música a partir de instrucciones de texto simples y ofrece un control detallado para modificar el audio según sus necesidades específicas.

“Con Project Music GenAI Control, la inteligencia artificial se convierte en tu cocreadora. Ayuda a las personas a crear la música perfecta para sus proyectos, ya sean emisoras, podcasters o cualquier persona que necesite un audio con la atmósfera, el tono y la duración adecuados”, explica Nicholas Bryan, investigador senior de Adobe Research y uno de los creadores de la tecnología.

Índice de temas

Adobe y la inteligencia artificial

Adobe tiene una larga tradición de innovación relacionada con la inteligencia artificial. Firefly, la familia de modelos de IA generativa de Adobe, se convirtió en tiempo récord en el modelo más popular para generar imágenes para un uso comercial seguro a nivel mundial, y ya produjo más de 6 mil millones de imágenes. Adobe se compromete a desarrollar su tecnología de acuerdo con los principios éticos de la IA: responsabilidad, transparencia y rendición de cuentas. Todo el contenido generado con Firefly incluye automáticamente las credenciales de contenido, es decir, etiquetas de información digitales que permanecen asociadas al contenido dondequiera que se utilice, publique o almacene.

¿Cómo funciona Project Music GenAI Control?

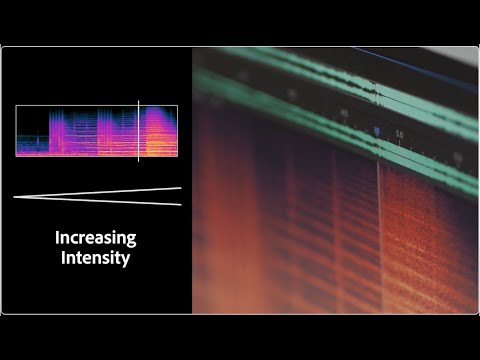

Las nuevas herramientas se basan en un mensaje de texto insertado en un modelo de inteligencia artificial generativa, un método que ya se utiliza en Firefly. El usuario introduce un mensaje de texto como “rock poderoso”, “baile feliz” o “jazz triste” para generar música. Una vez generada, la edición detallada se integra directamente en el flujo de trabajo. Gracias a una interfaz sencilla, los usuarios pueden transformar el audio generado en función de una melodía de referencia; ajustar el tempo, la estructura y los patrones repetitivos de una pista; elegir cuándo aumentar o disminuir la intensidad del audio; extender la duración de un clip; remezclar una sección; o generar un bucle perfectamente repetible.

Project Music GenAI Control puede ayudar a los usuarios a crear exactamente las piezas que necesitan, resolviendo los problemas de flujo de trabajo de principio a fin. Ya no es necesario cortar manualmente la música existente para crear intros, outros y audio de fondo. “Una de las cosas más interesantes de estas nuevas herramientas es que no solo generan audio, sino que llevan las cosas al siguiente nivel y ofrecen a los creadores el mismo control profundo para dar forma, ajustar y editar el audio. Es como tener el control píxel por píxel de la música“, explica Bryan.

Project Music GenAI Control se desarrolló en colaboración con colegas de la Universidad de California en San Diego, como Zachary Novack, Julian McAuley y Taylor Berg-Kirkpatrick, y con colegas de la Facultad de Ciencias de la Computación de la Universidad Carnegie Mellon, como Shih-Lun Wu, Chris Donahue y Shinji Watanabe.