La inteligencia artificial (IA) está transformando rápidamente la forma en la que operan las empresas de todo el mundo gracias a herramientas como la automatización y la generación de contenido.

Sin embargo, a medida que crece su uso, también lo hace en un riesgo poco reconocido: Shadow AI. Este fenómeno ocurre cuando los empleados adoptan herramientas de IA sin la supervisión del sector TI, lo que puede derivar en graves problemas de seguridad y cumplimiento.

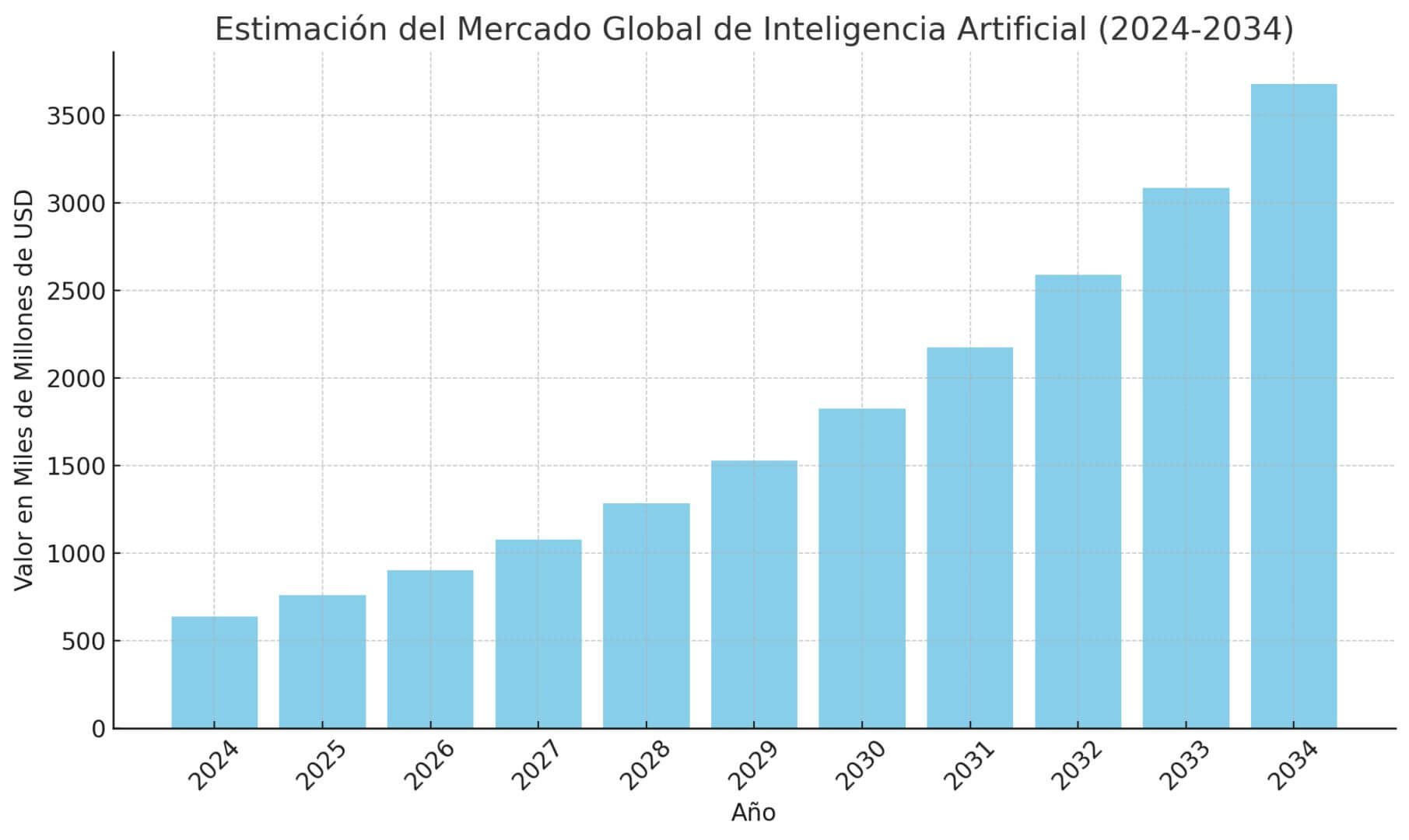

Para poner en contexto, un estudio de Precedence Research reveló que el mercado global de inteligencia artificial alcanzó los 638 mil millones de dólares en 2024 y se estimó que alcanzará los 757 mil millones en 2025. Además, podría alcanzar los 3.6 billones para el 2034 gracias a una tasa anual compuesta del 19,20%.

Este crecimiento proyectado refleja el potencial de la inteligencia artificial, pero también resalta los desafíos que se deberán gestionar para su uso adecuado dentro de las empresas.

A medida que la tecnología avanza, se hace más importante encontrar un equilibrio entre fomentar la innovación y garantizar la seguridad. En este contexto, las corporaciones deberán establecer controles efectivos para evitar el uso no autorizado y proteger sus datos.

Índice de temas

¿Qué es la Shadow AI y por qué representa un riesgo creciente para las empresas?

La Shadow IA se refiere al uso no autorizado o no supervisado de herramientas de inteligencia artificial por parte de los empleados de una empresa. Este fenómeno ocurre cuando los trabajadores adoptan soluciones de IA como chatbots, automatizadores de tareas o asistentes inteligentes, sin que los equipos de TI o de seguridad de una determinada compañía aprueben ni controlen el empleo de dichas plataformas.

¿Por qué ocurre la Shadow IA?

El aumento del uso de Shadow IA está directamente relacionado con la accesibilidad y facilidad de uso de las herramientas de inteligencia artificial disponibles en el mercado. Los empleados, al encontrar soluciones rápidas para mejorar su productividad, recurren a estas herramientas sin esperar la aprobación de los equipos técnicos de la empresa.

Aunque esto puede ser visto como una forma de optimización, trae consigo riesgos para la seguridad y la gobernanza.

Principales riesgos de la Shadow AI

El uso descontrolado de la inteligencia artificial en la sombra plantea varios problemas serios que pueden afectar a las distintas áreas de las empresas:

- Gobernanza: la adopción descentralizada de soluciones de IA crea silos de datos que complican la trazabilidad y la gestión centralizada. Además, los equipos de TI pierden visibilidad y control sobre las herramientas que se utilizan, lo que puede generar caos tecnológico y dificultar la alineación estratégica.

- Seguridad: los empleados pueden estar compartiendo información confidencial, lo que aumenta el riesgo de filtraciones. Muchas herramientas de IA almacenan o reutilizan información, lo que genera vulnerabilidades si se almacenan en servidores externos sin garantías claras de protección.

- Cumplimiento regulatorio: la falta de control puede llevar al incumplimiento de regulaciones como el GDPR o leyes locales de protección de datos. Por otro lado, transferir información sensible fuera de los límites corporativos puede resultar en violaciones legales y sanciones por parte de las autoridades.

En algunas empresas, los empleados pueden decidir usar aplicaciones de mensajería no oficiales para compartir información laboral, sin la supervisión de los equipos de TI. Aunque su intención sea mejorar la comunicación y la productividad, el riesgo es evidente. Debido a esta imprudente decisión, la empresa puede perder el control sobre la seguridad de la información, lo que puede terminar en una fuga de datos o en el mal uso de información valiosa.

¿Qué herramientas de IA suelen usarse sin control en entornos corporativos?

El uso no autorizado de herramientas de IA en las empresas está en aumento. Si bien estas soluciones pueden ser de gran utilidad para mejorar la productividad, también traen consigo riesgos importantes.

Estas son algunas de las plataformas de inteligencia artificial más comunes que se utilizan sin el control adecuado en el ámbito corporativo, junto con sus riesgos asociados:

| Herramienta | Usos típicos | Áreas | Riesgos principales |

|---|---|---|---|

| ChatGPT (OpenAI) | Redacción, generación de código, resúmenes | Marketing, TI | Fuga de datos, avisos inseguros, sesgos, incumplimiento |

| Géminis (Google) | Asistente de búsqueda, integración ofimática | Productividad | Exposición de info (Drive/docs), falta de trazabilidad |

| Copiloto (Microsoft) | Generación de código, automatización, textos | Desarrollo, Operaciones | Inyección de código inseguro, filtraciones, derechos de autor |

| Otter.ai, QuillBot, etc. | Transcripción, resumen, edición | RH, ventas | Filtración involuntaria, salidas con errores, privacidad |

| Chatbots IA externos | Atención a usuarios, respuestas automáticas | Soporte, Ventas | Datos sensibles a la nube no auditada, respuestas erróneas |

ChatGPT (OpenAI)

Es utilizado principalmente para:

- Generación de contenido.

- Redacción de resúmenes.

- Traducciones.

- Generación de código.

- Asistencia en investigación.

Se emplea en áreas como:

- Marketing.

- Soporte.

- Programación.

- Recursos humanos.

- Comunicación interna.

Géminis (Google)

Es usado principalmente como asistente de búsqueda, para la generación de información e integración en Google Workspace (como documentos y correos).

Se usa en áreas de:

- Productividad en oficinas.

- Análisis.

- Soporte.

- Investigación.

Copilot (Microsoft)

Esta herramienta está destinada a:

- Generación de código.

- Automatización en aplicaciones de Microsoft 365.

- Resumen y redacción de textos.

- Completado de presentaciones.

Se utiliza en áreas como:

- Programación.

- Operaciones.

- Administración.

- Contabilidad.

Claude, Perplexity, Poe, QuillBot, Liner, ConserjeAI, Otter.ai, CivitAI

Estas herramientas se usan principalmente para:

- Automatización de textos.

- Asistentes conversacionales.

- Resúmenes de reuniones.

- Transcripción de audio.

- Generación de imágenes/media.

Son comunes en áreas como:

- Comunicación.

- Ventas.

- Recursos humanos.

- Logística.

- Soporte.

Áreas donde suele verse Shadow AI

- Marketing y comunicación: generación automática de textos publicitarios, análisis de redes sociales, creación de artes y publicaciones automáticas.

- Atención al cliente y soporte: uso de chatbots no oficiales para responder consultas o gestionar tickets de soporte.

- Finanzas y recursos humanos: automatización de informes, resúmenes de hojas de cálculo, procesamiento de CV.

- Programación y tecnologías: utilización de asistentes de código para acelerar el desarrollo sin controles de seguridad.

- Productividad general: automatización de agendas, transcripción de reuniones, redacción de correos electrónicos.

¿Qué riesgos legales, éticos y de ciberseguridad implica la Shadow AI?

La adopción descontrolada de Shadow AI trae consigo graves riesgos en distintas áreas que abarcan lo legal, lo ético e incluso la seguridad. Es fundamental que las empresas comprendan estos peligros para poder mitigarlos de forma efectiva.

Según mencionó la Alianza de la Seguridad en la Nube (CSA, por sus siglas en inglés) en un artículo, los empleados recurren a estas herramientas para mejorar su productividad. Sin embargo, sin un control adecuado, estos sistemas pueden almacenar y procesar información confidencial, lo que podría provocar fugas de datos o incluso violaciones de privacidad.

Por otro lado, un estudio de la escuela HEC Paris liderado por David Restrepo Amariles reveló que la adopción no regulada de herramientas como ChatGPT beneficia a los empleados, pero no a las empresas.

En este, se determinó que los contenidos generados con IA fueron mejor evaluados, pero los gerentes subestimaron el esfuerzo de los analistas cuando sabían que se había utilizado inteligencia artificial. Por el contrario, cuando los empleados no revelaban el uso de IA, sus evaluaciones mejoraban, lo que pone de manifiesto los riesgos de la Shadow AI y su falta de transparencia.

Legal

- Incumplimiento de normas de privacidad: el uso no autorizado de herramientas de IA puede implicar el procesamiento y almacenamiento de datos fuera de los parámetros legales. Esto puede contravenir regulaciones como GDPR, HIPAA, o CCPA, entre otras.

- Multas, demandas y sanciones civiles o penales: las brechas de seguridad o el manejo inadecuado de información confidencial pueden resultar en fuertes multas o sanciones legales para una empresa.

- Violaciones contractuales: muchos acuerdos con clientes y proveedores incluyen cláusulas estrictas de confidencialidad. El uso de herramientas de IA sin control puede llevar a fugas de información que violen estos acuerdos, lo que puede exponer a una empresa a acciones legales.

Ética

- Introducción de sesgos algorítmicos: los modelos de IA no auditados pueden generar decisiones no éticas y discriminatorias basadas en género, edad, raza, entre otros. Estos factores afectan áreas como recursos humanos, marketing y atención al cliente.

- Falta de transparencia y trazabilidad: las decisiones tomadas por Shadow AI carecen de documentación y justificación, lo que dificulta la rendición de cuentas. Esto puede generar desconfianza entre empleados y clientes.

- Degradación de la confianza y reputación: la falta de supervisión humana y la producción de resultados erróneos pueden dañar la reputación de una empresa, además de generar contenido falso que afecte la relación con los clientes.

Ciberseguridad

- Fuga de datos críticos: los datos pueden ser almacenados y reutilizados al ingresar información sensible en las plataformas de IA sin la debida protección. Esto podría exponer contratos y las finanzas de una empresa a filtraciones.

- Vulnerabilidades a ciberataques: muchas herramientas de IA externas no cumplen con los estándares de seguridad corporativa, lo que las convierte en un punto débil para ataques de ransomware o phishing.

- Inyección de código malicioso: el uso de asistentes de programación o herramientas de generación de scripts sin revisión de seguridad puede provocar la inyección de código inseguro.

- Pérdida de visibilidad y control: el uso de shadow AI dificulta que los equipos de TI rastreen qué datos, aplicaciones y flujos se ven afectados, lo que complica la respuesta ante incidentes y la protección estandarizada en toda la empresa.

¿Cómo detectar si hay Shadow AI en la empresa?

Detectar la Shadow AI en una empresa no es tarea fácil, pero los equipos de TI deben estar atentos a las señales de alerta y utilizar diversas técnicas para identificar su uso no autorizado.

Estas son algunas de las señales más comunes, métodos de identificación, y una lista de verificación que te ayudará a realizar un diagnóstico básico:

Señales de alerta para detectar Shadow AI

- Uso frecuente de herramientas de IA no oficiales: empleados que utilizan chatbots, asistentes inteligentes o extensiones de IA no comunicadas al departamento de TI para mejorar su productividad.

- Comportamiento anómalo en sistemas o redes: un incremento inusual en el tráfico hacia plataformas externas de IA como OpenAI, Google Gemini, Microsoft Copilot, etc.

- Solicitudes frecuentes de acceso a servicios externos mediante API no registradas: el uso no autorizado de API para conectar herramientas de IA con sistemas corporativos.

- Errores o inconsistencias en los informes: fallas o datos inconsistentes generados por automatizaciones no documentadas.

- Fugas o exposiciones sospechosas de datos confidenciales: detectadas por herramientas de seguridad o denuncias internas.

- Silos de información: la falta de integración de sistemas con plataformas oficiales corporativas puede indicar el uso de herramientas externas de IA que funcionan de manera aislada.

Lista de verificación técnico/operativo para diagnóstico básico de Shadow AI

| Área | Acción | Descripción |

|---|---|---|

| Registros de tráfico | Revisar conexiones de red hacia dominios IA públicos | Identificar tráfico hacia servicios como openai.com, googleapis.com, azure.com, etc. |

| Gestión de APIs | Auditar claves API y accesos a servicios externos | Verificar si hay API no documentadas o usadas sin autorización. |

| Repositorios de datos | Escanear para binarios/modelos IA en sistemas | Buscar archivos asociados a entrenamientos o inferencia de IA. |

| Sistemas de monitoreo | Revisar alertas por comportamiento anómalo | Detectar picos inusuales de actividad o patrones atípicos. |

| Políticas internas | Evaluar cumplimiento de políticas TI y uso de IA | Confirmar que haya capacitaciones y normativas claras para los colaboradores. |

| Comunicación interna | Realizar encuestas o entrevistas al personal | Detectar usos no oficiales o necesidades no atendidas con herramientas oficiales. |

| Software especializado | Implementar soluciones para descubrir Shadow AI | Usar plataformas de gestión de Shadow IT con enfoque IA (ej. BigID). |

Cómo los equipos de TI pueden identificar el uso de Shadow AI

- Análisis de registros y tráfico: monitorear los registros de conexiones de red en busca de accesos hacia plataformas de IA públicas o no autorizadas. También se deberán revisar los logs de aplicaciones, correos electrónicos y APIs para detectar interacciones con servicios externos de IA.

- Análisis de comportamiento: detectar picos inusuales en patrones de uso de datos o en la frecuencia de envíos/conversiones hacia plataformas externas. También se deberá identificar automatizaciones no registradas que conectan con herramientas de IA.

- Detección de archivos y modelos: realizar escaneos en repositorios, servidores y computadoras para localizar binarios o archivos asociados a modelos de IA.

- Entrevistas y encuestas internas: realizar encuestas o entrevistas a los empleados para entender si están usando herramientas externas y detectar necesidades no cubiertas por las soluciones oficiales.

- Herramientas especializadas: implementar software especializado para detectar usos no autorizados de IA. Existen plataformas de inteligencia de datos y gestión de Shadow IT que pueden ayudar en esta tarea.

¿Qué políticas internas ayudan a prevenir la Shadow AI sin bloquear la innovación?

Prevenir el uso descontrolado de Shadow AI sin sofocar la innovación en una empresa es posible mediante la aplicación de marcos de gobernanza flexibles. Las políticas internas deben equilibrar la seguridad con la creatividad y la eficiencia.

Teniendo en cuenta esto, James Kerr, profesional del sector tecnológico en Estados Unidos, realizó un posteo en LinkedIn en el que explicó que es fundamental que las empresas establezcan directrices claras, formen a sus equipos y los supervisen para evitar los efectos negativos del Shadow AI.

Estas son algunas de las mejores prácticas y un ejemplo de política interna que pueden implementarse para lograr este equilibrio:

| Aspecto | Prácticas recomendadas | Beneficios |

|---|---|---|

| Definición de uso | Guías claras con herramientas permitidas y prohibidas | Reduce la Shadow AI y mejora la seguridad. |

| Control de acceso | Roles y permisos específicos | Minimiza la exposición y facilita el control. |

| Sandbox y pilotos | Entornos aislados para pruebas | Fomenta la innovación con riesgos controlados. |

| Procesos ágiles | Vía rápida para evaluación y aprobación de nuevas herramientas | Responde a necesidades reales sin bloqueos. |

| Monitoreo continuo | Supervisión proactiva del uso de IA | Previene el uso indebido y las fugas de información. |

| Capacitación | Programas formativos sobre riesgos y buenas prácticas | Fomenta la conciencia y responsabilidad. |

Políticas internas para prevenir Shadow AI sin bloquear la innovación

- Guías claras de uso de IA: definir qué herramientas de IA están aprobadas, cómo deben usarse y qué tipo de datos pueden procesar. Esto ayuda a reducir la necesidad de que los empleados busquen soluciones no autorizadas.

- Control de acceso por roles: asignar permisos específicos para el uso de herramientas de IA según el cargo y las funciones de cada empleado. Esto limita la exposición innecesaria a plataformas externas y facilita la auditoría del uso de IA.

- Sandbox: crear ambientes aislados y seguros donde los empleados puedan experimentar y probar nuevas herramientas de IA sin afectar los datos reales ni los sistemas de la empresa. Esto fomenta la innovación en un lugar controlado.

- Procesos ágiles para aprobación: implementar procesos rápidos y claros para que los empleados puedan solicitar el empleo de nuevas soluciones de IA. Este proceso debe incluir evaluaciones previas de seguridad, cumplimiento e impacto en la empresa.

- Monitoreo y auditorías: es necesario contar con software de monitoreo que identifique el uso no autorizado de IA y evalúe el cumplimiento de las políticas establecidas.

- Capacitación y sensibilización: implementar programas educativos sobre los riesgos asociados a la utilización de la IA, las mejores prácticas y las políticas internas para el manejo adecuado de herramientas de IA. Esto hará entender a los empleados tanto los beneficios como los riesgos de la Shadow AI.

Desde el punto de vista normativo, el Instituto Nacional de Estándares y Tecnología de EE. UU. (NIST, por sus siglas en inglés) publicó su Marco para la Gestión del Riesgo de IA (AI Risk Management Framework, AI RMF), que incluye directrices actualizadas para evaluar y mitigar riesgos asociados al uso no gobernado de herramientas de IA, como ocurre en el fenómeno de Shadow AI.

Entre las acciones para proteger el panorama de IA en la empresa, la Alianza de Seguridad en la Nube (CSA, por sus siglas en inglés) promueve la adopción de estrategias esenciales para implementar un sistema integral de inventario de inteligencia artificial:

- Integración con sistemas de gestión de activos existentes: identificar y mapear todos los recursos de IA dentro de la infraestructura actual de gestión de activos, integrando atributos y metadatos específicos de IA y alineando el inventario con los procesos del ciclo de vida de los activos para lograr una supervisión completa.

- Cumplimiento normativo y seguridad: aplicar estándares reconocidos como NIST AI RMF y NIST SSDF, establecer controles de acceso robustos, cifrado y protocolos seguros, y auditar de forma periódica los registros para proteger datos sensibles y detectar accesos no autorizados.

- Monitoreo e informes continuos: utilizar herramientas automatizadas para vigilar en tiempo real los activos de IA, registrar cambios y generar reportes que ofrezcan una visión clara del panorama, facilitando decisiones informadas.

- Definición de roles con modelo RACI: asignar responsabilidades precisas, donde los equipos de TI e IA actualicen el inventario, el CDO y CISO supervisen la gestión y seguridad, y líderes de negocio y cumplimiento participen en la alineación con necesidades operativas y regulatorias.

- Formación y concientización: capacitar al personal en desarrollo, implementación y gestión de IA. De esta manera se refuerza la importancia de documentar correctamente los activos y cumplir los protocolos de seguridad y gobernanza.

- Responsabilidad durante el ciclo de vida: evaluar el impacto de los sistemas de IA a lo largo de su vida útil, especialmente en aquellos de uso general, para asegurar que las obligaciones legales estén claramente distribuidas en toda la cadena de valor.

- Alineación con marcos y normativas internacionales: incorporar guías y estándares como IEEE 7010-2019, NIST AI RMF, NIST SSDF, ISO/IEC 38507:2022, los Principios de IA de la OCDE y la Ley de IA de la Unión Europea, garantizando que el inventario cumpla con las mejores prácticas y regulaciones aplicables.

Ejemplo de política interna para Shadow AI

Objetivo

Garantizar el uso responsable de herramientas de IA dentro de la empresa para minimizar los riesgos de seguridad y el cumplimiento.

Alcance

Aplica a todos los empleados, contratistas y terceros que utilicen herramientas de IA en nombre de la empresa.

Lineamientos

- Solo se podrán usar herramientas de IA aprobadas por TI y Seguridad.

- El acceso a herramientas de IA se otorgará según roles y necesidades justificadas.

- Se habilitarán entornos sandbox para pruebas y pilotos de IA.

- Se prohíbe ingresar datos sensibles o confidenciales en plataformas externas no autorizadas.

- Se realizará una revisión periódica y auditoría del uso de IA por parte de Compliance.

- Formación obligatoria sobre los riesgos y el uso correcto de herramientas de IA.

Procedimiento de solicitud

Los empleados podrán solicitar nuevas herramientas de IA a través de un formulario digital, que será revisado por IT y el área de legales.

Sanciones

El incumplimiento de las acciones establecidas en esta política conllevará sanciones disciplinarias según las normas internas.

¿Qué diferencia hay entre Shadow IT y Shadow AI?

Tanto Shadow IT como Shadow AI implican el uso no autorizado de herramientas dentro de una empresa, pero su naturaleza, impacto y los riesgos que presentan son muy distintos.

| Característica | Shadow IT | Shadow AI |

|---|---|---|

| Definición | Uso no autorizado de herramientas TI. | Uso no autorizado de herramientas de IA. |

| Ejemplos | Aplicaciones en la nube, software no aprobado. | ChatGPT, Copilot, Gemini, generadores IA. |

| Velocidad de adopción | Relativamente lenta. | Muy rápida, fácil acceso en la nube. |

| Impacto | Riesgos de seguridad y cumplimiento. | Fugas de datos y generación errónea. |

| Riesgos únicos | N/A | Entrenamiento con datos sensibles, sesgos. |

| Detección | Más fácil con herramientas tradicionales. | Difícil, requiere análisis profundo. |

Shadow IT se refiere al uso no autorizado de aplicaciones, servicios o dispositivos tecnológicos que no están aprobados por el departamento de TI. Esto puede incluir herramientas como aplicaciones de almacenamiento en la nube o software colaborativo no verificado.

Por su parte, Shadow AI es una subcategoría más reciente de Shadow IT, que involucra el uso no autorizado de herramientas de inteligencia artificial. Estas utilizan datos para procesos automatizados, lo que agrega una capa extra de complejidad y riesgo.

Ambos comparten el hecho de operar fuera del control oficial de TI, pero presentan diferencias en cuanto a la velocidad de adopción, el impacto y los riesgos que generan.

¿Cómo pueden los líderes de IT y datos tomar control del uso de IA en sus organizaciones?

Es fundamental que los lideres TI y de datos tomen el control dentro de sus empresas para garantizar la seguridad, el cumplimiento y la gobernanza, y evitar el Shadow AI.

Estos son una serie de pasos concretos para poder lograrlo:

| Etapa | Actividades clave | Objetivo |

|---|---|---|

| 1. Diagnóstico | Auditoría de herramientas y usos actuales de IA | Mapear el estado real y detectar Shadow AI |

| 2. Gobernanza | Definir políticas de uso y aprobar casos específicos | Establecer reglas claras y flexibles |

| 3. Capacitación | Formación de equipos y usuarios | Promover uso responsable y ético |

| 4. Implementación | Desplegar monitoreos y controles técnicos | Detectar y mitigar Shadow AI y riesgos asociados |

| 5. Evaluación continua | Auditorías periódicas y actualización de políticas | Adaptar estrategias según la evolución de la IA |

Auditoría exhaustiva de herramientas IA existentes

- Identificar todas las plataformas y servicios basados en IA que se utilizan en la organización, tanto los oficiales como los no autorizados (Shadow AI).

- Revisar cómo se usan estas herramientas, qué datos procesan y evaluar posibles vulnerabilidades o brechas de seguridad.

- Usar herramientas especializadas en descubrimiento y análisis para detectar servicios no autorizados y que no cumplen con las políticas internas.

Definición clara de casos de uso aprobados

- Establecer y comunicar una lista clara de aplicaciones, herramientas y tipos de IA autorizados para cada departamento o perfil dentro de la empresa.

- Definir qué datos pueden ser procesados y cuáles están prohibidos para prevenir filtraciones.

- Crear un proceso ágil para evaluar y aprobar nuevas herramientas de IA solicitadas por los empleados.

Formación y sensibilización

- Capacitar a los empleados sobre los riesgos, buenas prácticas y las políticas internas relacionadas con el uso de IA.

- Promover una cultura de cumplimiento sin frenar la innovación a través de capacitaciones en el empleo responsable y ético de las herramientas de IA.

- Formar a los líderes técnicos para que puedan seleccionar, supervisar y evaluar de manera efectiva las soluciones de IA dentro de sus equipos.

Monitoreo y control

- Implementar sistemas de monitoreo de tráfico, uso de aplicaciones y detección de comportamiento anómalo para identificar el uso no autorizado de la inteligencia artificial.

- Realizar auditorías periódicas de accesos, registros de datos y cumplimiento de las políticas establecidas.

Aplicar controles técnicos como sandboxing, gestión de accesos y límites de uso para minimizar los riesgos.

Preguntas frecuentes sobre Shadow IA

¿Cómo puede una empresa medir el impacto oculto de la Shadow AI en sus procesos?

Una forma efectiva es realizar auditorías de uso de IA que incluyan análisis de tráfico, revisión de logs de API y encuestas internas. Esto permite identificar automatizaciones no autorizadas y cuantificar su efecto en productividad, seguridad y cumplimiento.

¿Qué tipo de software ayuda a descubrir y gestionar Shadow AI en una organización?

Existen plataformas especializadas en Shadow IT con enfoque en IA, como BigID o Netskope, que permiten detectar herramientas no autorizadas, mapear flujos de datos sensibles y aplicar políticas de control centralizado.

¿Cuál es la diferencia entre políticas de uso de IA permisivas y restrictivas frente a la Shadow AI?

Las políticas permisivas promueven la innovación mediante entornos controlados como sandboxes y procesos ágiles de aprobación, mientras que las restrictivas pueden aumentar el Shadow AI al no responder a las necesidades reales de los empleados.

¿La Shadow AI puede afectar negativamente la precisión de los informes corporativos?

Sí. Automatizaciones no oficiales pueden introducir errores en los informes, ya que operan sin validación ni trazabilidad, afectando decisiones estratégicas basadas en datos incorrectos.

¿Qué responsabilidad tienen los líderes de datos frente al uso no autorizado de IA?

Los líderes de datos deben establecer marcos de gobernanza claros, definir casos de uso aprobados, formar al personal y supervisar los sistemas para garantizar un uso ético y seguro de la IA en toda la organización.

¿Cómo se puede equilibrar innovación y seguridad al gestionar la IA en la empresa?

El equilibrio se logra mediante políticas flexibles, control de acceso por roles, pilotos en sandbox, procesos de aprobación rápidos y monitoreo continuo, sin frenar la adopción responsable de nuevas herramientas de IA.