La inteligencia artificial avanzó a pasos agigantados durante los últimos años, y los Modelos de Lenguaje Grande (LLM) son una de las herramientas más poderosas en esta revolución tecnológica. En este contexto, elegir el mejor LLM se tornó un aspecto crucial para las empresas que buscan optimizar sus procesos y mejorar la interacción con los datos.

Estos modelos están transformando la forma en que las empresas generan contenido y automatizan tareas. Sin embargo, la variedad de opciones disponibles que hay en el mercado hace que la elección del mejor modelo resulte ser una tarea más compleja de lo que se cree, sobre todo cuando se trata de alinearlo con las necesidades y objetivos específicos de cada compañía.

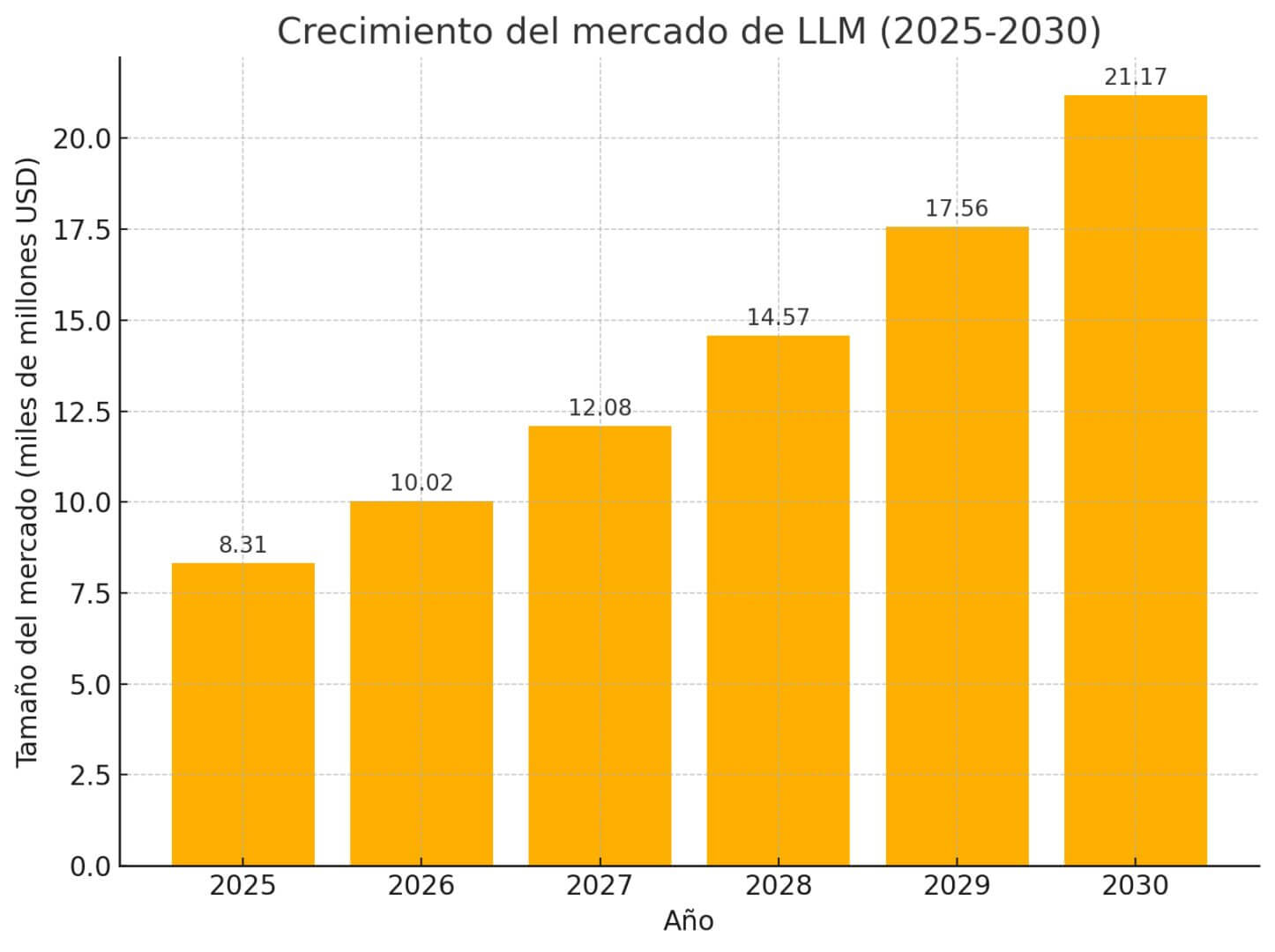

Según un reporte de Mordor Intelligence, el tamaño del mercado de los LLM se sitúa en 8,31 mil millones de dólares en 2025 y se prevé que alcance los 21,17 millones para el 2030, con una tasa de crecimiento anual compuesta del 20,57%. Estos números reflejan la creciente importancia de estos modelos dentro del panorama empresarial global, además de remarcar la necesidad de las compañías para seleccionar un modelo adecuado para mantenerse competitivas.

En este sentido, y teniendo en cuenta el avance de esta tecnología, elegir el mejor LLM se convierte en una oportunidad para liderar en innovación y optimización de procesos en un ámbito que es altamente competitivo.

Índice de temas

¿Qué es un LLM?

Los modelos lingüísticos grandes (LLM) son sistemas de inteligencia artificial diseñados para modelar el lenguaje de manera similar a cómo un ingeniero utiliza software para modelar componentes de un avión. Esta analogía, utilizada en un artículo por la Universidad de Georgetown, ilustra cómo los LLM buscan crear una representación digital de la lengua.

Su evolución fue impulsada principalmente por el uso de grandes volúmenes de datos y una mayor potencia computacional. Esto permitió entrenar modelos con una gran cantidad de parámetros para mejorar el rendimiento de estos modelos.

Según el Ministerio para la Transformación Digital y la Función Pública de España, su principal fortaleza radica en la capacidad de generalizar tareas, ya que no necesitan de un entrenamiento específico para abordar distintos temas de manera efectiva. Además, gracias a su comprensión contextual les permite generar textos coherentes y adecuados.

Por el momento, el término LLM sigue siendo algo ambiguo, ya que no existe consenso sobre el tamaño que debe tener un modelo para ser considerado “grande”, ni sobre lo que se considera un modelo de lenguaje.

Sin embargo, el concepto de modelo fundacional, popularizado por Stanford, hace referencia a sistemas con capacidades amplias que pueden adaptarse a diversas aplicaciones. Un ejemplo claro de esto es ChatGPT, que utiliza un LLM como modelo base y luego se especializa para realizar tareas concretas.

¿Cuál es el mejor LLM para empresas?

El mercado de los LLM creció de forma exponencial durante los últimos años y, hoy en día, ofrece una gran variedad de opciones avanzadas para las empresas que las quieran utilizar.

Estos modelos son fundamentales para tareas como:

- Procesamiento de texto.

- Atención al cliente.

- Generación de contenido.

- Análisis de datos.

- Y más.

Sin embargo, la elección del mejor LLM depende de la siguiente serie de factores:

- Tipo de uso.

- Complejidad.

- Idiomas requeridos.

- Costos.

- Necesidades específicas de personalización.

Juan Wisznia, licenciado en Ciencias de Datos por la UBA y consultor en sistemas de inteligencia artificial, reveló en diálogo con ID360: “Hoy ninguna empresa puede darse el lujo de atarse a un solo modelo, porque el panorama cambia demasiado rápido”.

Además, explicó: “La forma correcta de pensarlo es construir desde el primer día una infraestructura agnóstica respecto de modelos. Eso implica soportar al menos dos o tres proveedores en paralelo, por ejemplo, OpenAI y Gemini de Google, o Claude de Anthropic”.

Comparación detallada de los modelos más avanzados y utilizados para el uso corporativo

| Modelo | Fortalezas | Casos de uso ideales |

|---|---|---|

| GPT-4o (OpenAI) | -Análisis profundo -Resolución de problemas complejos | -Revisión de documentos -Análisis de datos -Asistencia en programación |

| Claude | -Escritura fluida -Tono humano -Excelente para creatividad | -Generación de contenido -Lluvia de ideas -Enseñanza de conceptos complejos |

| Gemini | -Rápido y adaptable -Ideal para consultas rápidas | -Atención al cliente. -IA interactiva -Respuestas rápidas |

| Mistral | -Eficiente -Multilingüe -Personalizable | -Implementación multilingüe -Análisis de datos -Personalización de sistemas |

| LLaMA (Meta) | -Código abierto -Fácil de personalizar -Económico | -Proyectos de código abierto -Tareas sencillas -Implementación interna |

| Falcon (Instituto de Innovación Tecnológica) | -Multilingüe -Optimizado para localización | -Marketing global -Análisis de sentimiento en varios idiomas -Sitios web multilingües |

| Copilot (Microsoft) | -Integración perfecta con herramientas de Microsoft -Optimización de la productividad en entornos corporativos -Soporte para tareas de desarrollo de software | -Asistencia en tareas de desarrollo de software -Automatización de procesos administrativos |

¿Cuál es el mejor LLM para el uso corporativo?

No existe un mejor LLM para todas las empresas, ya que la elección depende de las necesidades específicas que tenga de cada una de ellas. Sin embargo, entender las fortalezas de cada modelo y los casos de uso ideales, es una gran herramienta para seleccionar un modelo que se adapte mejor a los objetivos empresariales.

“Se debe construir como si ningún modelo fuera a permanecer en la cima por mucho tiempo, porque esa es la realidad”, sostuvo el especialista en inteligencia artificial. “Hay que poner la evaluación como brújula. Si podemos medir el rendimiento contra nuestros propios benchmarks, a través de múltiples proveedores, siempre sabremos qué opción nos conviene”, cerró.

¿Qué modelo de IA conviene según el objetivo del negocio?

La selección del LLM más adecuado depende directamente de los objetivos y necesidades de la empresa. Con el avance de la inteligencia artificial, cada vez son más los modelos que ofrecen capacidades especializadas para las diferentes aplicaciones corporativas. Cada modelo tiene fortalezas únicas que se alinean con casos de uso específicos.

“Cuando un modelo es ampliamente adoptado, suele significar que el ecosistema que lo rodea está maduro. Tiene mejores herramientas, más integraciones, más casos de uso documentados y una comunidad amplia que ya identificó los escollos”, contó Wisznia.

También añadió: “Esos factores importan enormemente al desplegar a escala. Entonces, la popularidad no es la trampa. La trampa es detenerse ahí y asumir que por eso el modelo encajará con nuestros objetivos sin probarlo”.

La siguiente matriz de decisión mapea los LLM más avanzados junto con sus distintas aplicaciones para que las empresas lo puedan aprovechar:

| Modelo | Atención al cliente | Copilotos internos | Análisis documental | Automatización | Generación de contenido |

|---|---|---|---|---|---|

| GPT-4o | Alta | Alta | Alta | Media | Alta |

| Claude | Alta | Alta | Media | Media | Alta |

| Gemini | Media | Media | Media | Baja | Media |

| Mistral | Media | Alta | Media | Alta | Media |

| LLaMA | Baja | Media | Media | Media | Baja |

| Falcon | Baja | Media | Media | Media | Media |

| Copilot | Alta | Alta | Alta | Alta | Media |

Atención al cliente

La atención al cliente es una de las áreas más comunes donde los LLMs están siendo aplicados. En esta área, GPT-4o y Claude se destacan por su capacidad para manejar interacciones complejas de manera fluida y empática.

Estos modelos tienen la capacidad de generar respuestas naturales y adecuadas en distintos contextos, lo que los hace ideales para bots conversacionales o sistemas de atención al cliente.

- GPT-4o es particularmente fuerte en interacciones profundas y respuestas detalladas. Esto lo convierte en la opción más destacada en este campo.

- Claude también sobresale en este aspecto. Ofrece respuestas claras y con un tono amigable, adecuado para empresas que priorizan la interacción humana.

Copilotos internos

Los copilotos internos son herramientas que asisten en la gestión y ejecución de tareas operativas o administrativas dentro de una empresa.

En este ámbito, tanto GPT-4o, Claude, y Mistral proporcionan un buen balance entre eficiencia y comprensión contextual. Estos modelos pueden asistir en tareas como la gestión de proyectos o la organización de agendas.

- Mistral es fuerte en ámbitos de trabajo multilingües y personalizables.

- GPT-4o y Claude también se destacan por su capacidad de proporcionar asistencia compleja en tiempo real.

Análisis documental

El análisis de grandes volúmenes de datos es otra de las aplicaciones más valiosas para los LLMs en el mundo corporativo. GPT-4o y Copilot son los más adecuados para este tipo de tareas debido a su capacidad para manejar documentos complejos y generar resúmenes precisos, así como identificar patrones dentro de grandes datasets.

- Copilot procesa largos documentos o informes que requieren una revisión exhaustiva y detallada.

- GPT-4o también sobresale en esta área. Es extremadamente efectivo para tareas de análisis y resumen de grandes cantidades de texto en contextos legales o técnicos.

Automatización

La automatización de procesos es fundamental para muchas empresas que buscan mejorar su eficiencia operativa. Mistral es fuerte en este campo debido a su eficiencia y capacidad de integración con los sistemas existentes. Este modelo automatiza procesos repetitivos como lo pueden ser la gestión de inventarios y la clasificación de datos.

- Mistral se destaca por su capacidad para implementar soluciones eficientes y adaptables en entornos multilingües y personalizados.

Generación de contenido

La generación creativa de contenido, como artículos, marketing, y otros tipos de redacción, es un campo donde Claude brilla. Este modelo está optimizado para la creación de contenido con un enfoque humano. Esto convierte a este LLM en el mejor cuando se necesita creatividad y capacidad explicativa.

- Claude ofrece un enfoque único en generación de contenido gracias a su habilidad para crear textos claros, creativos y bien estructurados. Es ideal para empresas de marketing y aquellas que necesitan crear contenido de alta calidad.

- GPT-4o también es altamente competente en esta área, ya que le permite a las empresas generar contenido en gran volumen sin tener que sacrificar la calidad.

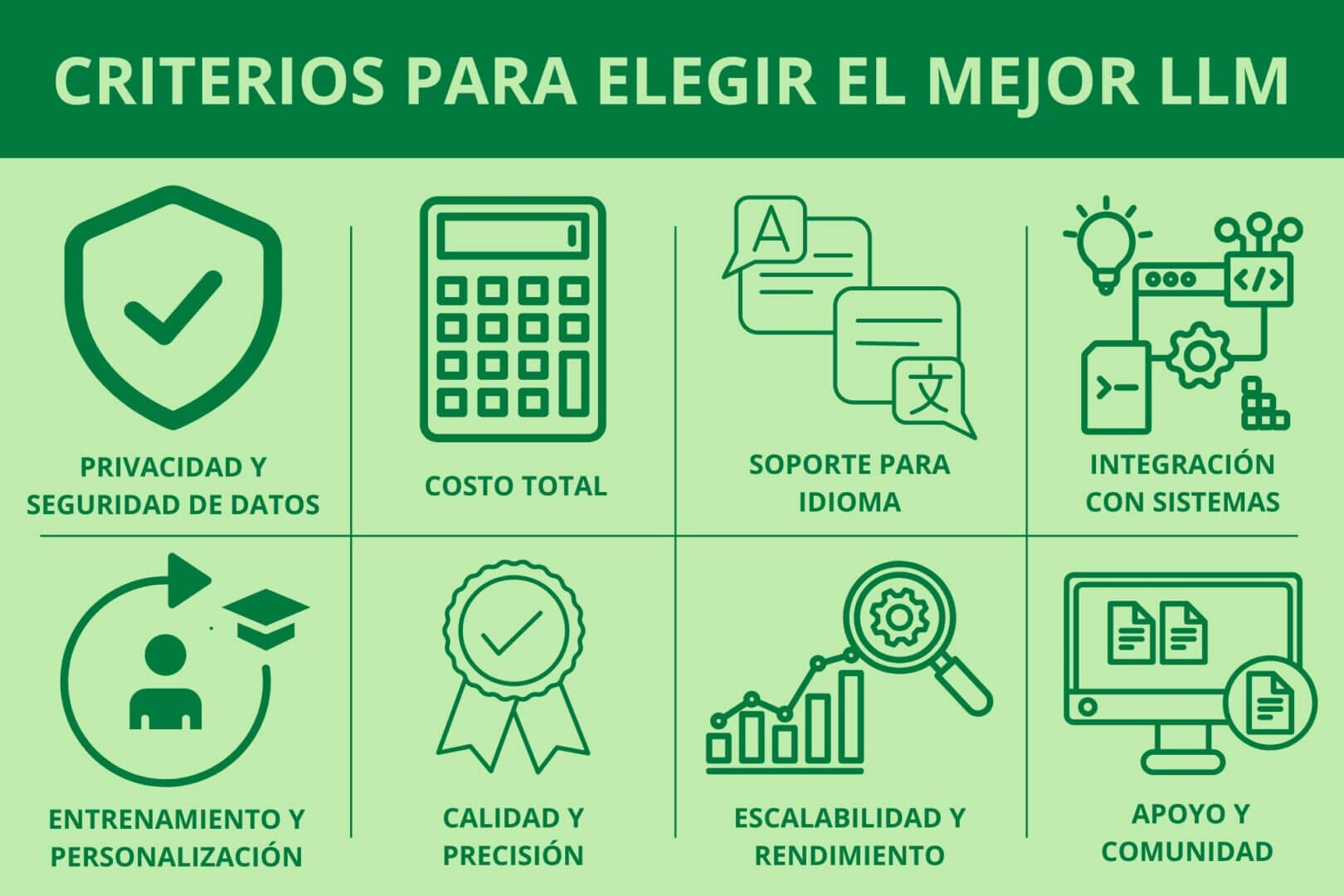

¿Qué criterios debe seguir una empresa para elegir un LLM?

La selección de un modelo de lenguaje grande adecuado es una decisión difícil para cualquier empresa que busque implementar inteligencia artificial de forma efectiva. Existen varios factores que influyen en el éxito del proyecto que abarcan áreas como la privacidad y el costo, e incluso hasta la facilidad de integración y la capacidad de personalización del modelo.

Estos son los principales criterios a considerar a la hora de elegir elegir un LLM para una empresa:

Privacidad y seguridad de datos

La privacidad y la seguridad de los datos son dos aspectos fundamentales, sobre todo si la empresa maneja información sensible. El LLM debe cumplir con las regulaciones y políticas de privacidad aplicables a la industria y región.

Esto incluye cumplir con regulaciones como:

- GDPR en Europa

- CCPA en California.

- Ley de Protección de Datos Personales de Argentina (Ley 25.326)

Además, el modelo debe ofrecer opciones de encriptación y control de acceso a datos sensibles.

- ¿Qué tener en cuenta?: se debe garantizar que el modelo no retenga ni comparta datos sensibles de manera no autorizada.

Costo total de implementación y uso

Los costos asociados con la implementación de un LLM no se limitan solo a las licencias iniciales. También deben incluirse los gastos relacionados con la infraestructura necesaria para ejecutar el modelo, el consumo de recursos computacionales, el entrenamiento, y el mantenimiento a largo plazo.

Además, es importante evaluar si el modelo cobra por uso (por consultas, tokens procesados, etc.), lo que podría generar costos adicionales a medida que aumenta el volumen de datos procesados.

- ¿Qué tener en cuenta?: costos de licencias, consumo de infraestructura, costos de entrenamiento y mantenimiento .

Soporte para idioma(s) requerido(s)

El LLM debe ser capaz de manejar correctamente los idiomas en los que la empresa opera. Si se espera que el modelo trabaje con varios idiomas o variantes de un mismo idioma, la calidad de la traducción y la generación de texto no debe verse comprometida. Algunos modelos, como Mistral o GPT-4o, tienen soporte multilingüe avanzado, mientras que otros modelos pueden tener limitaciones.

- ¿Qué tener en cuenta?: rendimiento en los idiomas específicos de la empresa.

Facilidad de integración con sistemas existentes

Un modelo de IA debe integrarse sin problemas con los sistemas ya existentes en la infraestructura de la empresa, como CRM, ERP u otras plataformas. La capacidad de integrar APIs y SDKs es fundamental para garantizar una adopción rápida y sencilla.

- ¿Qué tener en cuenta?: compatibilidad con plataformas tecnológicas existentes.

Capacidades para entrenamiento y personalización

Los LLM deben ser capaces de ajustarse a loas necesidades específicas del negocio. Esto incluye la posibilidad de entrenar el modelo con datos propios de la empresa y ajustarlo para adaptarse a un vocabulario técnico o sectorial específico. Algunos modelos, como GPT-4o y Mistral, permiten la personalización de modelos.

- ¿Qué tener en cuenta?: capacidades de fine-tunning y personalización para vocabulario específico.

Escalabilidad y rendimiento

El modelo debe ser capaz de escalar para satisfacer la demanda futura. La capacidad de procesar grandes volúmenes de datos sin que se degrade la calidad de las respuestas o el tiempo de respuesta es un factor fundamental a tener en cuenta.

- ¿Qué tener en cuenta?: rendimiento bajo cargas altas y la capacidad de adaptarse al crecimiento de la empresa.

Calidad y precisión del modelo

La precisión y coherencia en las respuestas generadas por el modelo son fundamentales para asegurar que los resultados sean útiles y válidos. Según el caso de uso, la empresa debe considerar cuán bien el modelo puede razonar, interpretar texto y generar resultados precisos y coherentes.

- ¿Qué tener en cuenta?: exactitud en la comprensión y generación de texto, además de la coherencia en las respuestas complejas.

Apoyo y comunidad técnica

Un modelo de IA debe contar con un soporte sólido y una comunidad activa que facilite la resolución de problemas. La existencia de documentación clara y foros de discusión es importante para que los equipos técnicos puedan aprovechar al máximo cualquier modelo.

- ¿Qué tener en cuenta?: soporte oficial, documentación completa y una comunidad activa.

Checklist ejecutivo para filtrar opciones de LLM

- Privacidad y seguridad de datos: ¿El modelo cumple con las regulaciones locales e internacionales (GDPR, LOPI, CCPA)? ¿Existen opciones de encriptación de datos?

- Costo total de implementación y uso: ¿Cuál es el costo total de propiedad (TCO) del modelo? ¿Cómo varían los costos con el aumento de la carga de trabajo?

- Soporte para idioma(s) requerido(s): ¿El modelo es eficaz en los idiomas que utiliza la empresa? ¿Existen limitaciones en la calidad de la generación de texto en diferentes idiomas?

- Facilidad de integración con sistemas existentes: ¿El modelo ofrece APIs y SDKs bien documentados? ¿Es compatible con el stack tecnológico de la empresa?

- Capacidades para entrenamiento y personalización: ¿Se puede entrenar el modelo con datos propios?

- Escalabilidad y rendimiento: ¿El modelo puede manejar grandes volúmenes de datos sin perder rendimiento? ¿Cuánto se tarda en procesar un volumen alto de consultas?

- Calidad y precisión del modelo: ¿El modelo ofrece respuestas precisas y coherentes? ¿Cómo maneja tareas complejas o ambiguas?

- Apoyo y comunidad técnica: ¿El modelo tiene soporte oficial adecuado? ¿Existen recursos técnicos como documentación, foros y tutoriales?

¿Es mejor usar un LLM vía API, como servicio SaaS o con modelo propio?

Las empresas deben considerar distintos factores relacionados con el control, escalabilidad, costos y recursos técnicos a la hora de implementar el mejor LLM en sus operaciones.

Existen tres modalidades principales:

- El uso del LLM vía API

- Como servicio SaaS (Software as a Service)

- Modelo propio instalado localmente.

Cada una de estas modalidades tienen sus ventajas y riesgos de acuerdo a las necesidades y capacidades que tenga una empresa.

| Criterio | Vía API | Servicio SaaS | Modelo propio |

|---|---|---|---|

| Nivel de control | Control depende completamente del proveedor. | El control está completamente en manos del proveedor. | Control total sobre el modelo e infraestructura. |

| Escalabilidad | Escalabilidad automática según demanda. | Escalabilidad gestionada por el proveedor. | Limitada por los recursos propios de la empresa. |

| Recursos técnicos necesarios | No necesita de infraestructura ni personal técnico especializado. | Todo gestionado por el proveedor. | Necesita de infraestructura y personal especializado en IA y DevOps. |

| Ventajas | -Rápida integración -Bajo costo inicial -Alta escalabilidad | -Solución integral -Fácil de usar | -Control total sobre datos -Personalización -Seguridad |

| Riesgos | -Dependencia total del proveedor -Limitación en personalización. | -Falta de control sobre la personalización -Dependencia del proveedor. | -Altos costos iniciales -Necesidad de un equipo especializado -Escalabilidad limitada. |

Vía API

En este caso, la empresa usa un LLM proporcionado por un tercero a través de una API. La integración de la IA en los sistemas de la empresa se realizan en la nube sin tener que gestionar la infraestructura o la instalación del modelo. Es ideal para empresas que necesitan integrar capacidades avanzadas de procesamiento de lenguaje natural sin gestionar costos operativos.

- Proveedores comunes: OpenAI (GPT-4), Anthropic (Claude), Google (Gemini), etc.

Servicio SaaS (Software as a Service)

En esta modalidad, se contrata un servicio completo en la nube, donde el proveedor se encarga del mantenimiento, actualización y escalabilidad del modelo. El usuario accede a la IA a través de una plataforma o aplicación. Este tipo de servicio es ideal para las empresas que buscan una solución integral y sin complicaciones técnicas.

- Proveedores comunes: Azure OpenAI Service, Amazon SageMaker, Google Cloud AI.

Modelo propio

La empresa instala y ejecuta un modelo LLM en su propia infraestructura. Esta modalidad necesita que la compañía tenga una infraestructura técnica adecuada, además del personal capacitado para gestionar, entrenar y mantener la IA. Esta modalidad resulta especialmente beneficiosa para las corporaciones que necesitan tener un control total sobre la privacidad de los datos y desean personalizar de forma profunda.

- Proveedores comunes: Modelos de código abierto como LLaMA (Meta) o Mistral (Mistral AI).

¿Qué modelos ofrecen mejor rendimiento en español y contexto latinoamericano?

Varios modelos de lenguaje LLM se destacan por su capacidad para entender y generar texto en español con matices regionalistas latinoamericanos. Algunas plataformas ofrecen modelos más adaptados a las particularidades de esta región, mientras que otras necesitan de ajustes adicionales para obtener una comprensión más precisa.

| Modelo | Calidad en español | Adaptación a matices regionales | Uso recomendado |

|---|---|---|---|

| GPT (OpenAI) | Alta | Buenas, con ajustes | Diálogo, generación de contenido natural |

| LLaMA (Meta) | Media | Limitada | Proyectos personalizados, código abierto |

| Falcón (Instituto de Innovación Tecnológica) | Alta | Excelente | Localización, sitios web multilingües |

| Claude (Antrópico) | Alta | Buena | Creatividad, generación de contenido |

| Géminis (Google DeepMind) | Alta | Buena | Traducción, interacción cultural |

| Latam-GPT | Media-Alta | Muy alta | Proyectos con enfoque latinoamericano, localización |

GPT (OpenAI)

GPT-4 y sus versiones superiores fueron entrenados con grandes volúmenes de texto en español de diversas regiones hispanohablantes.

Aunque el modelo es bastante competente para entender variantes regionales del español, es posible que necesite de algunos ajustes finos en contextos muy específicos de Latinoamérica.

Generalmente es utilizado en diálogo, generación de contenido natural y resolución de problemas complejos. Es adecuado para empresas globales con presencia en Latinoamérica que no necesiten adaptaciones específicas muy profundas.

LLaMA (Meta)

LLaMA fue diseñado principalmente para inglés, por lo que su desempeño en español es más limitado, aunque todavía competente. Aunque puede generar texto en español, no está ajustado para comprender todos los modismos, vocabulario o giros lingüísticos de Latinoamérica.

Es ideal para proyectos personalizados de código abierto, donde los desarrolladores puedan hacer ajustes específicos. Si se busca tener una solución que este totalmente adaptada a Latinoamérica es necesario realizar una mayor personalización.

Falcón (Instituto de Innovación Tecnológica)

Falcón tiene un enfoque fuerte en el multilingüismo y es capaz de procesar contenido en español de manera muy efectiva. Su entrenamiento tiene en cuenta las diferencias culturales y lingüísticas entre los países de habla hispana, lo que permite una comprensión precisa de los modismos y el vocabulario regional.

Es útil para empresas que operan en diferentes países latinoamericanos y necesitan una adaptación precisa del lenguaje, como en sitios web multilingües y contenido de marketing.

Claude

Claude está diseñado para tareas complejas y creativas, y tiene una buena capacidad para generar texto en español de calidad. Aunque no se especializa en en este idioma, es bastante efectivo para producir textos claros y naturales en la mayoría de las variantes del idioma.

Es ideal para la creación de contenido y generación de ideas cuando se necesitan explicaciones claras o tareas de lluvia de ideas en español.

Gemini (Google DeepMind)

Gemini tiene acceso a un gran volumen de datos de calidad, incluidos textos en español, ya que esta integrado con datos de Google Search. Si bien es un modelo robusto para distintas variantes del español, su entrenamiento está más orientado hacia un español neutro que puede adaptarse bien a la región latinoamericana.

Se recomienda su uso para la traducción, interacción cultural y la generación de contenido en múltiples idiomas.

Latam-GPT y modelos específicos de América Latina

Estos modelos fueron entrenados específicamente para comprender el español latinoamericano e incorporar el vocabulario y las expresiones típicas de la región.

Son diseñados para ofrecer un rendimiento de alto nivel con una excelente comprensión cultural de las distintas variantes de español en América Latina. Esto incluye todos los países entre México y Argentina.

Son ideales para proyectos con un enfoque 100% latinoamericano, como contenido local, estrategias de marketing regionales y asistentes virtuales que operan exclusivamente en el mercado de habla hispana.

¿Cuánto cuesta integrar un LLM en una empresa y qué factores afectan el precio?

Integrar un LLM en una empresa puede tener un costo considerable que puede variar según el modelo elegido, la modalidad de pago y los requisitos técnicos de la implementación. Existen varias formas comunes de cobro, y distintos factores que influyen en el presupuesto.

Tabla estimativa de costos según nivel de uso

| Nivel de uso | Descripción | Estimación costo mensual | Modalidad típica |

|---|---|---|---|

| Bajo | Proyectos piloto, pruebas limitadas | US$100 – US$1.000 | API por token o suscripción pequeña |

| Medio | Integración parcial en procesos de negocio | US$1.000 – US$10.000 | Suscripción media o uso API intensivo |

| Alto | Uso masivo en producción, análisis y generación | US$10.000 – US$100.000+ | Licencias privadas o modelos propios |

Modalidades de pago de un LMM

Cobro por token

Esta modalidad es muy común cuando se accede al modelo a través de una API. El costo se calcula según la cantidad de tokens procesados, que incluyen tanto los tokens de entrada (texto enviado al modelo) como los de salida (texto generado por el modelo).

- Ejemplo: GPT-4 cobra entre US$5 y US$15 por millón de tokens, según el tipo y la versión del modelo.

Suscripción

Algunos proveedores ofrecen planes mensuales o anuales con límites en el número de tokens o consultas. Esto posibilita a las empresas a tener una predictibilidad en los costos, aunque en algunos casos puede haber restricciones en cuanto al volumen de uso o la funcionalidad del modelo.

- Ejemplo: Azure OpenAI Service o Google Cloud AI pueden ofrecer planes de suscripción mensual con algunos límites.

Licencias privadas y modelos propios

Para empresas con altos volúmenes de uso o necesidades específicas, se puede optar por la licencia de un modelo propio. Esto implica costos de licencia, además de infraestructura, personal técnico y mantenimiento. La inversión inicial es elevada, pero los costos tienden a ser más controlados.

- Ejemplo: modelos privados como los de Meta (LLaMA) o Mistral permiten la instalación local o en la nube privada, pero con una inversión inicial importante en términos de en hardware y recursos humanos.

Aspectos más comunes que influyen en el presupuesto

- Volumen de uso y tokens procesados: el número de tokens procesados por mes tiene un impacto directo en los costos. Empresas que manejan grandes volúmenes de datos va a generar gastos más altos que aquellas con uso más limitado.

- Complejidad y tamaño del modelo: los modelos más avanzados suelen ser más caros debido a su capacidad para manejar tareas complejas y generar texto con mayor precisión.

- Nivel de personalización y entrenamiento adicional: si se necesita personalizar el modelo para tareas específicas o entrenarlo con datos propios de la empresa, esto puede incrementar considerablemente el costo, ya que se necesitan recursos adicionales.

- Infraestructura técnica: la empresa debe contar con los recursos adecuados para alojar el modelo, ya sea en servidores locales o en la nube. Esto puede implicar costos elevados de infraestructura y gestión.

- Requisitos de seguridad y cumplimiento regulatorio: si la empresa maneja datos sensibles o está sujeta a regulaciones específicas, los costos pueden aumentar debido a las medidas de seguridad adicionales y la necesidad de cumplir con las normas locales.

- Recursos humanos: la contratación de personal especializado en IA y DevOps para el desarrollo, soporte y mantenimiento del modelo incrementa los costos.

- Escalabilidad y latencias: el costo también dependerá de la escalabilidad que se necesita. En proyectos grandes, la tolerancia a latencias y la necesidad de adaptarse a picos de demanda pueden generar costos adicionales en infraestructura.

- Costos ocultos: la optimización y los ajustes realizados al modelo para mejorar la precisión pueden incrementar el presupuesto a largo plazo.

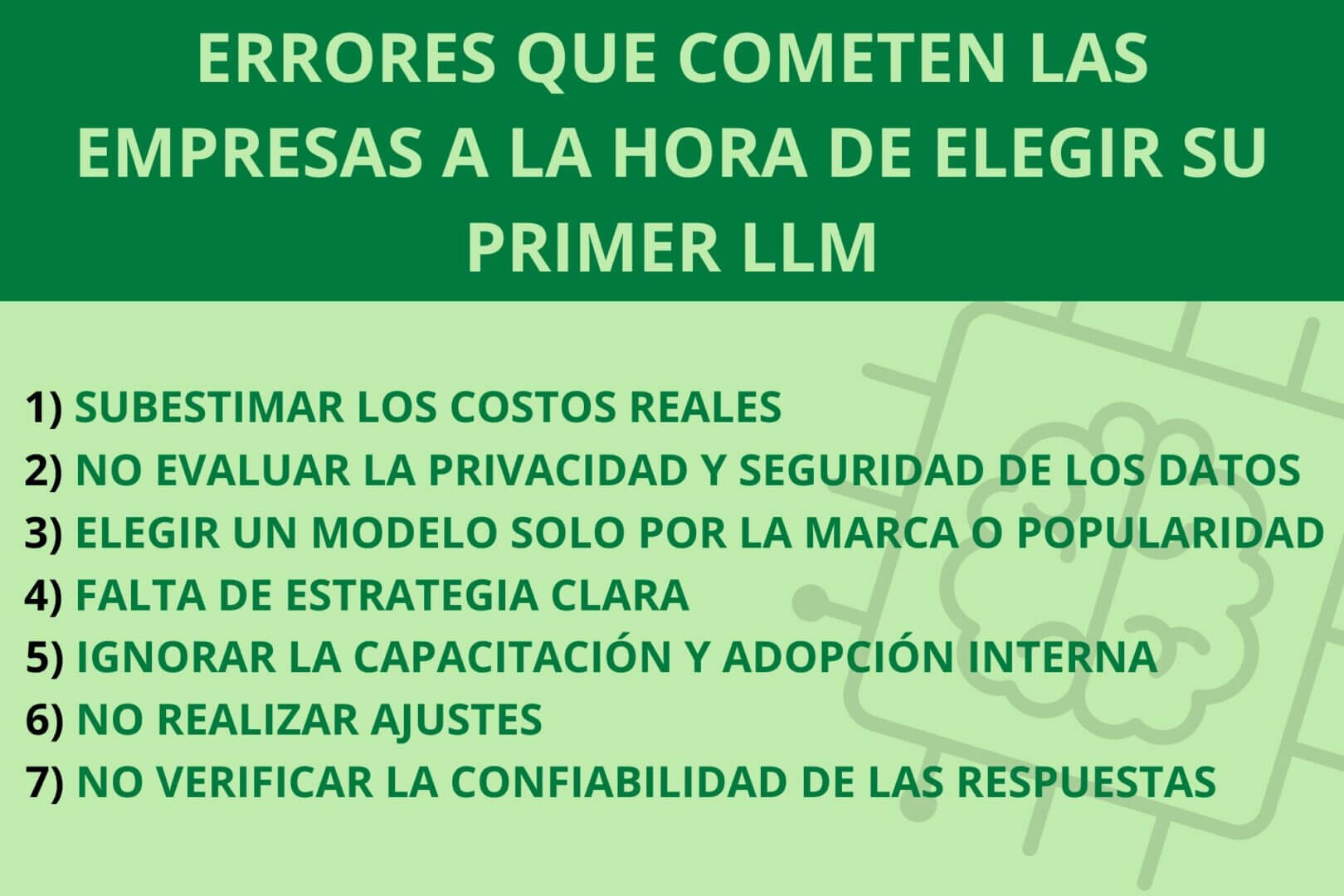

¿Qué errores cometen las empresas al elegir su primer LLM?

Muchas empresas caen en errores comunes que pueden afectar la eficacia, la seguridad y el retorno de inversión al implementar un LLM por primera vez.

“El verdadero desafío empieza después del prototipo”, comentó Wisznia. “Convertir esa primera demostración en un sistema que produzca valor medible y sostenido para el negocio es un problema completamente distinto. Es mucho más difícil, y la industria hoy subestima la brecha entre ambos estadios”, sostuvo.

Entre estos se encuentran:

Subestimar los costos reales

Algunas empresas no suelen considerar todos los gastos asociados, como los tokens consumidos, los costos de infraestructura, el personal técnico necesario y el mantenimiento. Esto puede derivar en sobrecostos inesperados.

- Prevención: asegurarse de incluir todos los costos ocultos y planificar un presupuesto detallado.

No evaluar adecuadamente la privacidad y seguridad de los datos

Según el sitio web del Supervisor Europeo de Protección de Datos, su uso plantea desafíos importantes en términos de privacidad y seguridad de los datos. Si bien los LLM pueden ayudar a identificar y gestionar datos personales en grandes cantidades de información no estructurada, también existen riesgos, como la posible revelación de información sensible durante su funcionamiento o entrenamiento

- Prevención: entender y cumplir con las normas de privacidad y seguridad desde el principio.

Elegir un modelo solo por la marca o popularidad sin validar el caso de uso

Optar por un LLM basado en su fama o popularidad, sin considerar si se adapta al caso de uso específico de la empresa, puede resultar en un desajuste entre la tecnología y los objetivos de negocio.

- Prevención: evaluar el caso de uso primero y luego seleccionar el modelo que mejor se alinee con las necesidades de la empresa.

Falta de estrategia clara

Implementar IA sin tener objetivos claros y medibles hace que sea difícil evaluar el retorno de inversión y seguir el progreso del proyecto.

- Prevención: definir objetivos claros y KPIs específicos para guiar la implementación y evaluar el impacto.

Ignorar la necesidad de capacitación y adopción interna

No preparar al personal para usar el LLM puede resultar en resistencia al cambio o uso ineficiente de la herramienta.

- Prevención: capacitar a tu equipo adecuadamente antes de implementar el LLM.

No realizar ajustes

Los modelos de IA requieren ajustes y optimización periódica para mantener su rendimiento y adaptarse a nuevas necesidades. Ignorar este aspecto puede hacer que el modelo pierda efectividad.

- Prevención: establecer un plan de monitoreo y ajustes regulares para mantener el modelo actualizado.

No verificar la calidad y confiabilidad de las respuestas generadas

Algunos LLM pueden generar información incorrecta o alucinaciones que afecten la calidad del servicio.

- Prevención: implementar protocolos de validación y filtros para garantizar la precisión de las respuestas generadas.