Amazon EMR es la plataforma de AWS para procesar y analizar grandes volúmenes de datos de manera rápida y escalable. Permite a las empresas ejecutar frameworks como Hadoop y Spark sin necesidad de gestionar infraestructura compleja.

En este artículo veremos cómo ayuda a optimizar proyectos de big data en la nube con eficiencia y reducción de costos.

Índice de temas

¿Qué es Amazon EMR y para qué sirve en proyectos de Big Data?

Amazon EMR es una plataforma de clúster administrado que facilita la ejecución de marcos de big data, como Apache Hadoop y Apache Spark, AWS. Ejecuta Apache Spark, Hive, Presto, así como otras cargas de trabajo de big data.

Gracias a estos marcos e iniciativas de código abierto relacionadas, permite el procesamiento de datos para analizar y realizar cargas de trabajo de inteligencia empresarial.

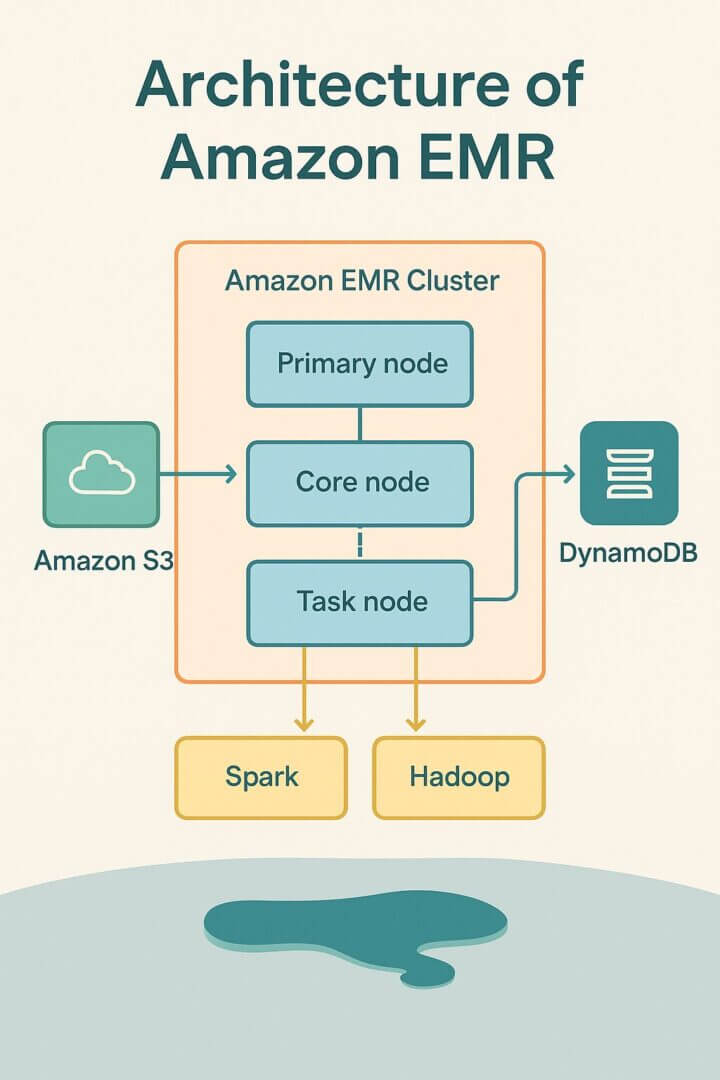

Amazon EMR también permite transformar y mover grandes volúmenes de datos hacia y desde otros almacenes de datos y bases de datos de AWS, incluidos Amazon Simple Storage Service (Amazon S3) y Amazon DynamoDB.

¿Cómo funciona Amazon EMR y cómo se estructura su clúster?

El clúster es el elemento central de Amazon EMR. Se trata de una colección de instancias de Amazon Elastic Compute Cloud (Amazon EC2), donde cada instancia del clúster representa un nodo. El nodo desempeña una función dentro del clúster, conocida como tipo de nodo.

Amazon EMR también instala diferentes componentes de software en cada tipo de nodo, invirtiendo cada nodo con una función en una aplicación distribuida como Apache Hadoop. Los tipos de nodo en Amazon EMR son: nodo primario; nodo de tareas. Veámoslos en detalle.

En Amazon EMR, el nodo primario se encarga de coordinar la ejecución del software y distribuir los datos y las tareas entre los demás nodos, además de supervisar la integridad del clúster.

En configuraciones multinodo, existen también los nodos principales, que pueden almacenar datos en HDFS y ejecutar cargas de trabajo distribuidas.

Por su parte, los nodos de tareas se destinan únicamente al procesamiento, sin capacidad de almacenamiento, lo que ofrece flexibilidad para escalar el rendimiento según la demanda del negocio

Envío de trabajos al clúster

Al ejecutar un clúster en Amazon EMR, las opciones sobre cómo especificar el trabajo a realizar varían. Es necesario ofrecer la definición total y completa de la carga de trabajo en funciones específicas como pasos durante la creación de un clúster. Esto es para clústeres que procesan una cantidad determinada de datos y luego concluyen al final del procesamiento.

Un clúster de larga duración debe crearse, utilizando la consola de Amazon EMR, la API de Amazon EMR o la CLI de AWS para enviar pasos que contengan uno o varios procesos.

Una vez creado un clúster, es posible conectarlo al nodo primario y a otros nodos mediante SSH y aprovechar las interfaces que ofrecen las aplicaciones instaladas para realizar tareas y enviar consultas, mediante scripts o de forma interactiva.

Tabla comparativa: Diferencias entre nodos en Amazon EMR

| Tipo de nodo | Funciones principales | Almacenamiento disponible | Obligatoriedad en el clúster | Casos de uso recomendados |

|---|---|---|---|---|

| Nodo primario (Master) | Coordina la ejecución del software; distribuye datos y tareas entre los demás nodos; supervisa la salud del clúster y gestiona el job tracker. | Limitado; principalmente metadatos temporales y archivos de configuración. | ✅ Siempre obligatorio (al menos uno por clúster). | Control central, orquestación, monitoreo, reinicio de servicios y logging. |

| Nodo principal (Core) | Ejecuta tareas de procesamiento y almacena datos en HDFS; mantiene la replicación de bloques y distribuye cargas de trabajo. | Sí, almacenamiento persistente en HDFS (replicado). | ⚙️ Recomendado para clústeres con datos persistentes o jobs prolongados. | Procesamiento distribuido, almacenamiento intermedio, ETL, análisis por lotes. |

| Nodo de tareas (Task) | Ejecuta únicamente tareas de cómputo; no guarda datos, ideal para escalar potencia de procesamiento bajo demanda. | ❌ Sin almacenamiento HDFS. | Opcional (se añaden o eliminan según la carga). | Escalado temporal, cargas intensivas en CPU, análisis en picos de demanda. |

¿Cómo permite Amazon EMR analizar grandes volúmenes de datos?

Amazon EMR es un servicio administrado que puede ejecutar Apache Hadoop y Spark de forma rápida, económica y sencilla. El objetivo es procesar grandes cantidades de datos.

Amazon EMR también es compatible con herramientas Hadoop potentes y probadas, como Presto, Hive, Pig, HBase, entre otros. En este proyecto, se puede desarrollar un clúster Hadoop totalmente funcional, listo para analizar datos de logs en cuestión de minutos.

Basta con lanzar el clúster de Amazon EMR y utilizar el script HiveQL para procesar los datos de registro de muestra almacenados en un bucket de Amazon S3. HiveQL es un lenguaje de scripting similar a SQL para el almacenamiento y análisis de datos. A continuación, se puede utilizar una configuración similar para analizar los archivos de registro.

En un caso real de 2024, GoDaddy migró parte de sus cargas de trabajo a Amazon EMR Serverless y reportó una reducción de costos de más del 60 %, junto con mejoras de rendimiento: sus trabajos en Spark se ejecutaron un 50 % más rápido.

Además, otra referencia destacada es el caso de una entidad financiera global que optimizó sus clústeres EMR sobre EC2 y logró reducir costos un 30 % en 3 meses mediante ajustes de configuración, escalado eficiente y adopción de instancias Spot.

Estas experiencias muestran que Amazon EMR no solo sirve para procesar logs o datos históricos: es una plataforma madura para cargas de trabajo críticas de negocio como análisis transaccional, detección de fraude, analítica en tiempo real o machine learning.

Por ejemplo, en el sector energético, la empresa ATAL mejoró el rendimiento analítico un 200% tras migrar su plataforma on-premises a AWS con EMR y Athena, reduciendo el tiempo de procesamiento de años de datos de 2-3 días a apenas 1-2 horas.

Comparativa: Amazon EMR frente a Azure Databricks y Google Cloud Dataproc

| Plataforma | Descripción general | Modelo de ejecución | Integración con ecosistema | Ventajas destacadas | Consideraciones |

|---|---|---|---|---|---|

| Amazon EMR | Servicio administrado de Big Data en AWS para ejecutar frameworks como Apache Spark, Hadoop, Presto o Hive. | En instancias EC2, EKS o en modo serverless. | Nativa con S3, DynamoDB, Redshift, Athena, Glue y herramientas de IA/ML de AWS. | Escalado automático, costos ajustables, soporte serverless y gobernanza integrada. | Requiere conocimiento del ecosistema de AWS para optimizar costos al máximo. |

| Azure Databricks | Plataforma unificada de análisis y machine learning basada en Apache Spark, optimizada para Azure. | Totalmente gestionada, con clusters autoescalables. | Integración directa con Synapse, Data Lake, Fabric, Power BI y servicios de IA de Azure. | Alto rendimiento en notebooks colaborativos, Delta Lake nativo y enfoque en IA generativa. | Costos algo superiores y curva de aprendizaje si se migra desde AWS o GCP. |

| Google Cloud Dataproc | Servicio de orquestación y análisis que ejecuta Hadoop, Spark y Hive en la infraestructura de Google Cloud. | Despliegue rápido en Compute Engine o en Kubernetes Engine. | Integración con BigQuery, Dataflow y Vertex AI. | Tiempo de inicio de clústeres muy corto y facturación por segundo. | Menos opciones serverless y ecosistema algo menos maduro para cargas híbridas. |

¿Cómo gestiona Amazon EMR el procesamiento de datos en tiempo real?

Amazon EMR facilita la realización y el funcionamiento de entornos y aplicaciones de big data. Se caracteriza por el aprovisionamiento simplificado, el escalado administrado y la reconfiguración de clústeres. En cambio, EMR Studio para el desarrollo colaborativo.

Permite la puesta en marcha de un clúster de EMR en cuestión de minutos, sin tener que asignar infraestructura ni establecer, configurar o realizar la optimización del clúster. Por lo tanto, permite a sus equipos centrarse en el desarrollo de aplicaciones de big data diferenciadas.

Permite escalar fácilmente los recursos, como la política de escalado gestionado de EMR, para satisfacer las necesidades del negocio. Permite que el clúster EMR gestione automáticamente los recursos informáticos para satisfacer las necesidades de uso y rendimiento. Permite optimizar la utilización del clúster, reduciendo los costos.

EMR Studio hoy no es solo un IDE: es un entorno colaborativo con notebooks Jupyter totalmente gestionados, integrados con capacidades interactivas serverless.

A partir de la versión 6.14, EMR Studio puede ejecutar cargas de trabajo interactivas sobre EMR Serverless directamente desde JupyterLab dentro de tu workspace sin necesidad de clústeres EC2 dedicados.”

Por ejemplo, según AWS, puedes ejecutar notebooks interactivos Spark sobre EMR Serverless dentro de EMR Studio, lo cual simplifica el aprovisionamiento y reduce costos de infraestructura.

Además, EMR Studio soporta múltiples lenguajes (Python, R, Scala, Spark, SQL) en un mismo notebook, colaboración en tiempo real, integración con repositorios Git, y permite orquestar pipelines usando herramientas como Apache Airflow o MWAA.

También permite adjuntar notebooks a clústeres EMR tradicionales o a instancias Serverless, acceder a Spark UI, YARN, SQL Explorer y depurar tareas sin ingresar a los nodos directamente.

Con alta disponibilidad con un solo clic, permite configurar la alta disponibilidad para aplicaciones multi-maestro como YARN, HDFS, Apache Spark, Apache HBase y Apache Hive.

Al activar el soporte multi-maestro, EMR configurará las aplicaciones para alta disponibilidad. En caso de errores, iniciará automáticamente el proceso de conmutación por error en un maestro para que la actividad del clúster no se interrumpa y los nodos maestros se coloquen en bastidores separados, lo que reduce el riesgo de errores simultáneos.

La monitorización de hosts permite detectar errores y, cuando se detectan problemas, se asignan nuevos hosts y se añaden automáticamente al clúster.

Escalado administrado de EMR

El escalado administrado de EMR escala automáticamente el clúster para mejorar el rendimiento y ahorrar costos. Además, se pueden especificar límites de procesamiento mínimos y máximos para los clústeres.

Amazon EMR los redimensionará automáticamente para conseguir el mejor rendimiento y utilización de los recursos. Además, el escalado muestrea continuamente parámetros clave relacionados con las cargas de trabajo que se ejecutan en los clústeres.

Reconfiguración de clústeres en ejecución

La reconfiguración de clústeres en ejecución permite cambiar la configuración de las aplicaciones que se ejecutan en los clústeres de EMR, incluidos Apache Hadoop, Apache Spark, Apache Hive y Hue, sin reiniciar el clúster.

Permite cambiar las aplicaciones sin necesidad de detener o volver a crear el clúster. Amazon EMR también aplicará las nuevas configuraciones, reiniciando fácilmente la aplicación reconfigurada. La consola, el SDK o la interfaz de línea de comandos permiten aplicar las configuraciones.

¿Cuáles son las tendencias más recientes de Amazon EMR en 2025?

Integración con IA generativa y LLMs para análisis avanzado sobre EMR

Amazon EMR hoy se usa como backbone de datos para preparar y orquestar pipelines que consumen o enriquecen LLMs desde notebooks Jupyter gestionados dentro de EMR Studio y también en modo serverless (sin gestionar clústeres EC2).

Desde Studio puedes desarrollar en Python/Scala/R y depurar con Spark UI; y si buscas menos fricción operativa, conectar notebooks a EMR Serverless vía endpoints Livy para ejecutar trabajos de Spark de forma interactiva y con control de costes.

A nivel de arquitectura, un patrón común es: ingestión en S3 → transformaciones distribuidas en Spark (limpieza, enriquecimiento, preparación de prompts/tablas) → llamada a un endpoint de LLM (por ejemplo, clasificar tickets, extraer entidades, resumir documentos) → persistencia de salidas y métricas para auditoría.

Spark Connect facilita que clientes ligeros (apps/servicios que invocan LLMs) se conecten de forma remota al clúster para operar con DataFrames, mientras que las ML Pipelines de Spark aportan trazabilidad y versionado de etapas (fit/transform, persistencia de modelos y pipelines).

Además, la guía de integración con object stores de Spark detalla buenas prácticas cuando trabajas sobre lagos de datos en la nube.

En rendimiento y costes, conviene separar responsabilidades: EMR/Spark para preparación y orquestación de datos a escala; la inferencia LLM en endpoints/servicios optimizados (o instancias con GPU) debido a su naturaleza compute/memory-intensive.

La literatura académica reciente describe técnicas para abaratar y acelerar la inferencia (por ejemplo, dynamic partitioning o phase splitting) que explican por qué la capa de inferencia suele residir en infra especializada, mientras EMR coordina datos, evaluación y postproceso a gran escala. Esto ayuda a contener el cost-per-query (costo por consulta) y la latencia en producción.

Sostenibilidad y optimización energética de clústeres en AWS

En 2025 el factor energético dejó de ser “nice to have” y pasó a ser una variable estratégica. Estudios recientes del Lawrence Berkeley National Laboratory (LBNL) muestran que la demanda eléctrica de los data centers en EE.UU. se triplicó en la última década y podría duplicarse o triplicarse hacia 2028, presionando tanto costos como metas ESG de las compañías.

Traducido al día a día: cada hora de cómputo innecesaria pesa en OPEX y huella de carbono, por lo que reducir capacidad ociosa en EMR tiene impacto directo en P&L y en la contabilidad de emisiones.

El primer acelerador en EMR es eliminar el “idle time”. Managed Scaling ajusta automáticamente el tamaño del clúster según la carga, evitando nodos sobredimensionados; y con EMR Serverless no hay infraestructura en espera: los recursos suben y bajan a demanda, lo que reduce energía y costo por trabajo.

En la práctica, clientes que migraron a EMR Serverless reportaron recortes relevantes en costo y tiempo de ejecución, una señal indirecta de menor consumo energético por unidad de trabajo. Para el gobierno de consumo, AWS publicó patrones de monitoreo para optimizar el uso de energía a lo largo del pipeline (ingesta → procesamiento → entrenamiento/inferencia).

La eficiencia por watt también se gana desde el hardware. Las instancias con AWS Graviton consumen hasta 60% menos energía para el mismo rendimiento que alternativas comparables, y las familias más nuevas (p. ej., Graviton4) mejoran la relación precio-rendimiento en cargas intensivas en memoria típicas de Spark.

Para EMR sobre EC2, priorizar flotas con Graviton donde sea compatible (bibliotecas, dependencias nativas) reduce consumo, calor y necesidad de refrigeración en el backend.

Medir bien importa tanto como optimizar. PUE (Power Usage Effectiveness) es el estándar para entender la eficiencia de infraestructura de data centers, con guías metodológicas de The Green Grid y material técnico del LBNL para instrumentar métricas y metering.

Aunque PUE no es una métrica de carbono, ayuda a detectar pérdidas de infraestructura que encarecen y “ensucian” cada hora de cómputo. Complementa con lineamientos de EPA ENERGY STAR para reducir desperdicios operativos en instalaciones compartidas.

Para el componente carbono, usa factores de emisión location-based. La base eGRID de la EPA ofrece tasas actualizadas por subregión eléctrica de EE. UU.; esas tasas permiten estimar Scope 2 y comparar regiones al decidir dónde ejecutar cargas batch sin requisitos estrictos de latencia.

Si tu gobernanza lo permite, programa ventanas de procesamiento cuando la intensidad del grid sea menor y documenta el cálculo con la guía oficial de eGRID.

Casos de uso en tiempo real: streaming analytics con Kinesis + EMR en 2025

El procesamiento en tiempo real ya no es una opción: es una exigencia en sectores como fintech, logística, marketing dinámico y ciberseguridad.

Con Amazon Kinesis Data Streams / Data Firehose ingieres datos continuamente (telemetría, eventos, logs), y con EMR puedes ejecutar jobs Spark Streaming o Structured Streaming casi al instante para producir insights, alertas o dashboards que impulsan decisiones inmediatas en tu empresa.

Por ejemplo, una empresa de pagos puede detectar fraudes en segundos analizando transacciones en flujo (Kinesis → EMR) y aplicar modelos de scoring que bloquean operaciones sospechosas al vuelo.

Otro caso: una plataforma logística que monitoriza sensores en flotas, analiza anomalías de comportamiento en tiempo real (velocidad, frenado brusco) y envía alertas a los operadores.

En marketing, campañas push pueden ajustarse automáticamente según comportamiento en tiempo real (clicks, rebotes) gracias a pipelines Kinesis + Spark sobre EMR.

Según el NIST, los sistemas de análisis en flujo deben priorizar la resiliencia, la coherencia de datos y el control de latencia para garantizar respuestas seguras en entornos críticos.

En este sentido, Spark Structured Streaming en EMR permite ventanas de procesamiento de apenas 200 ms, integradas con AWS Lambda o servicios de ML para inferencias casi instantáneas.

Además, el escalado automático del clúster ajusta recursos para mantener la latencia estable, incluso en picos de tráfico.

Tendencias claves 2025 a tener en cuenta:

- Micro-batches ultrafinos y latencia reducida: Spark Structured Streaming permite ventanas de 100–200 ms, acercándose al real streaming puro.

- Integración con funciones serverless: tras procesar un micro-lote, puedes invocar AWS Lambda o endpoints de ML para inferencia DE ultra baja latencia.

- Escalado automático dinámico: en picos, el clúster EMR puede escalar automáticamente para procesar el volumen sin degradar latencia; en calma, libera recursos para consumir menos energía.

- Procesamiento híbrido en el borde y nube: cierta lógica de filtrado o agregación preliminar puede ejecutarse en dispositivos Edge (IoT) antes de enviar al core (Kinesis → EMR), reduciendo ancho de banda y carga global.

Qué tener en cuenta al implementarlo:

- Diseñar tolerancia a fallos mediante checkpointing y estado repartido (stateful streaming).

- Controlar la retención de datos en Kinesis para balancear entre la ventana de análisis y el almacenamiento.

- Asegurar que los jobs en EMR estén optimizados para la latencia: evitar la recolección de basura pesada, particionar eficientemente, usar memoria adecuada.

- Añadir monitoreo en tiempo real (CloudWatch, métricas de Spark) para detectar cuellos de botella y ajustar.

Este enfoque híbrido de ingestión constante + procesamiento con EMR está siendo adoptado por grandes jugadores del sector (fintech, retail con IoT) como estándar de operación en 2025, transformando datos sin procesar en decisiones accionables al instante.

Gobernanza y seguridad de datos: cifrado y cumplimiento (AI Act, GDPR, HIPAA)

En entornos regulados, EMR debe partir de una configuración de seguridad que fuerce cifrado en reposo y en tránsito, control de claves y auditoría. En la práctica, combina Security Configurations de EMR para activar TLS en los nodos y cifrado de HDFS/EMRFS, con KMS para la gestión de claves (rotación, separación de funciones y registros de uso). Es la línea base del Well-Architected para workloads analíticas en AWS.

La gestión de claves (ciclo de vida, rotación, tamaños, algoritmos) no es cosmética: es el pilar que define tu postura de riesgo. Las guías de NIST SP 800-57 recomiendan políticas explícitas de generación/rotación y protección de material criptográfico; al adoptarlas, facilitas auditorías y reduces exposición cuando hay cambios de proveedores o incidentes. En paralelo, mantén cifrado en tránsito extremo a extremo (TLS) y segmentación de red para limitar el radio de impacto.

En privacidad y cumplimiento, mapea categorías de datos y bases legales: para la GDPR (Reglamento (UE) 2016/679) exige minimización, limitación de finalidad y DPIA cuando el riesgo es alto; el AI Act (Reglamento (UE) 2024/1689) añade obligaciones de gestión de riesgo, gobernanza de datos y trazabilidad para sistemas de alto riesgo que consuman datasets preparados en EMR.

En salud (EE.UU.), la HIPAA Security Rule requiere salvaguardas administrativas, físicas y técnicas —incluyendo cifrado y controles de acceso— con guías actualizadas por HHS. Traducción operativa: inventario de datos, retención, lineage, y controles de acceso granulares con logs inmutables.

Integración con Lakehouse y AWS Glue Data Catalog

El patrón Lakehouse unifica almacenamiento económico (data lake) con transacciones ACID y gestión de metadatos estilo warehouse. En EMR esto se materializa usando formatos de tabla abiertos (p. ej., Apache Iceberg, Delta Lake o Apache Hudi) sobre S3.

Por otro lado, AWS Glue Data Catalog centraliza esquemas, partitions y permisos para que Spark (en EMR) consulte datos con consistencia y time travel. Beneficio para el negocio: gobernanza coherente y agilidad para analítica y ML sin silos.

Con Iceberg, obtienes evolución de esquemas segura, snapshot isolation y manifest lists (aislamiento por instantáneas y listas de manifiestos) que estabilizan el rendimiento cuando crecen los archivos; Delta Lake aporta logs de commit y optimizaciones para merge/upsert; Hudi destaca por la ingesta incremental y el manejo eficiente de upserts para analytics near-real-time.

Elegir el formato es una decisión arquitectónica: prioriza interoperabilidad con tus motores (Spark/Trino/Presto) y los SLA de frescura.

A nivel conceptual, la literatura técnica sobre Lakehouse respalda este enfoque por su capacidad de unificar batch + streaming, mejorar governance y reducir costos frente a double-write entre lago y warehouse.

Para directivos, el takeaway es claro: un solo plano de datos gobernado (Glue Catalog) y tablas abiertas evitan encierros tecnológicos y aceleran casos de uso —desde BI hasta feature stores— con trazabilidad y control.

Desde la redacción de Innovación Digital 360, entendemos que Amazon EMR se consolida en 2025 como un eje estratégico en la evolución del Big Data corporativo. Su capacidad para combinar escalabilidad, analítica en tiempo real y sostenibilidad energética refleja hacia dónde avanza la gestión de datos empresariales: entornos cada vez más automatizados, eficientes y preparados para integrar inteligencia artificial generativa con gobernanza y seguridad de nivel corporativo.