El crecimiento de la inteligencia artificial en los últimos años despertó una serie de preocupaciones éticas. Tecnologías como la IA generativa están transformando sectores enteros, aunque también plantean riesgos vinculados a sesgos algorítmicos, privacidad e impactos negativos sobre personas y empresas.

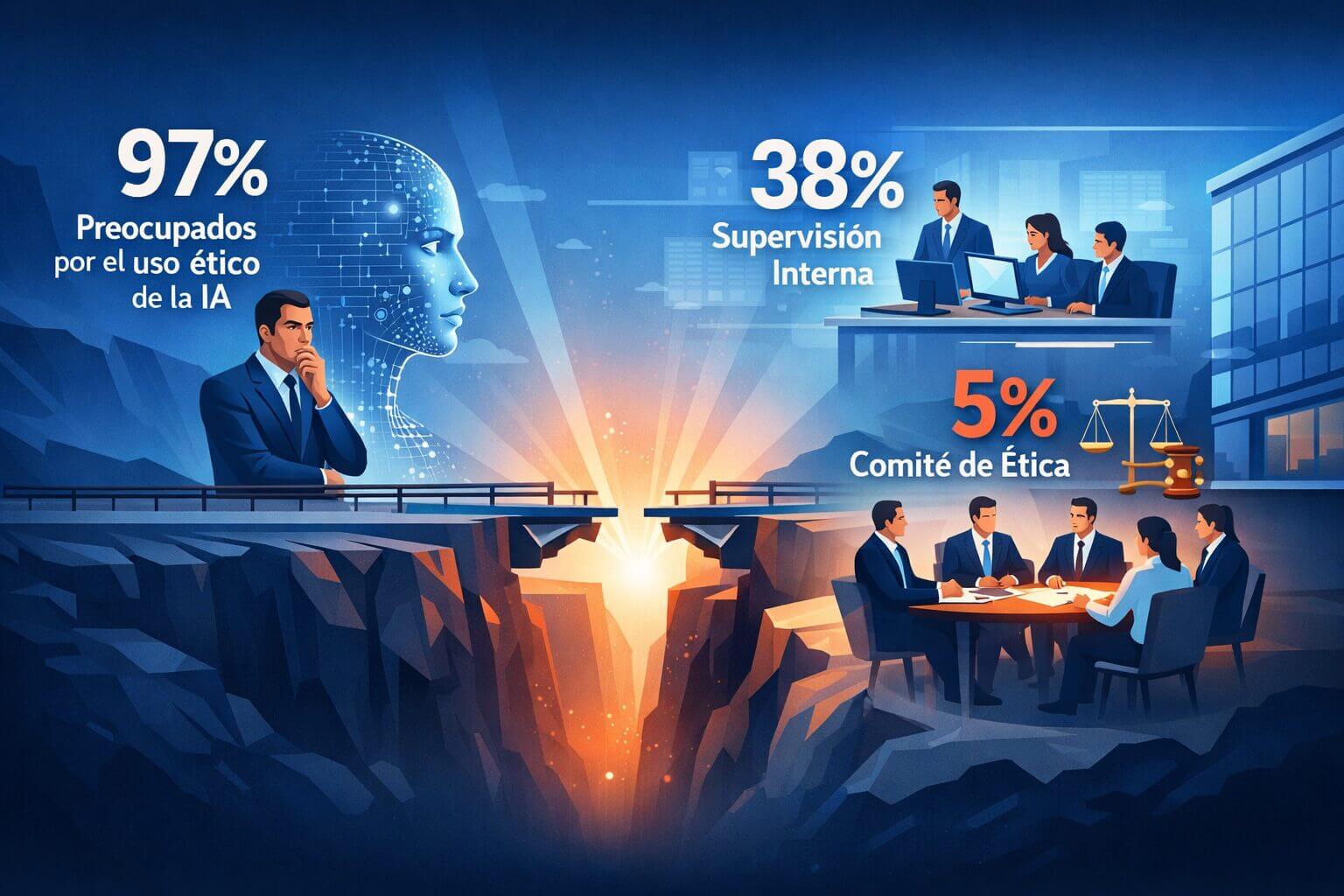

La distancia entre la conciencia del problema y la acción es notoria. El estudio “Investigación sobre IA 2025” de Solvd reveló que, si bien el 97% de los directivos de TI expresó preocupación por el uso poco ético de la IA, solo 38% de las empresas cuenta con una supervisión interna formal, y apenas 5% delegó esa responsabilidad en un comité específico de ética o cumplimiento.

Al mismo tiempo, la regulación avanza hacia una mayor exigencia en términos de ética aplicada a la IA. La nueva Ley de IA de la Unión Europea, también conocida como AI ACT, obliga a las empresas a implementar una gobernanza más estricta sobre sus algoritmos, que incluya mecanismos de explicabilidad y control de riesgos.

Por su parte, organismos internacionales como la UNESCO establecieron principios que priorizan la supervisión humana y la rendición de cuentas en los sistemas de IA.

En este escenario, son muchas las empresas que se preguntan si corresponde formar un comité de ética especializado en IA como parte de su respuesta frente a estas nuevas exigencias y desafíos.

Índice de temas

¿Qué es un comité de ética en inteligencia artificial?

Un comité de ética de IA es un grupo multidisciplinario dentro de una organización que se encarga de asegurar el desarrollo y uso responsable de la inteligencia artificial. Diversas guías señalan que conformar un comité de este tipo suele ser el primer paso para gestionar los dilemas éticos que plantea la inteligencia artificial.

Este grupo debe incluir representantes de diversas áreas como:

- Legales.

- Tecnología.

- Recursos humanos.

- Negocios.

- Alta dirección.

La inclusión de todos estos expertos tiene el objetivo de definir principios y evaluar riesgos en proyectos de IA.

Varias organizaciones líderes ya supieron implementar estructuras de este tipo, como por ejemplo:

- Microsoft cuenta con su comité AETHER, que revisa los proyectos de IA de alto riesgo para verificar que respeten los principios éticos de la compañía.

- El Instituto Mexicano del Seguro Social (IMSS) creó en 2025 una Comisión Interna de IA para supervisar y asegurar un uso ético en toda la institución de este tipo de tecnologías emergentes.

¿Qué riesgos éticos puede generar la inteligencia artificial sin supervisión?

Un ejemplo concreto de los riesgos de implementar sistemas de IA sin la supervisión ética adecuada se ve en la evaluación independiente de tecnologías de análisis facial. Un estudio demuestra que algunos de estos sistemas, incluidos desarrollos comerciales ampliamente difundidos, mostraban tasas mayores de errores al identificar a mujeres de piel más oscura comparado con otros grupos demográficos.

Esto pone de manifiesto cómo sesgos en los datos y el entrenamiento pueden traducirse en resultados desiguales en aplicaciones sensibles.

¿Cuáles son los beneficios de contar con un comité de ética?

Contar con un comité dedicado a la ética de la IA puede ofrecer varias ventajas. Desde Innovación Digital 360 les presentamos una tabla que resume algunos de los beneficios más importantes que tiene contar con una comisión para tratar estos temas:

| Rol del comité de ética en IA | Impacto principal |

|---|---|

| Supervisión ética temprana | Prevención de sesgos y conflictos |

| Gobernanza y control | Menor riesgo legal y regulatorio |

| Criterios éticos en el diseño | Innovación más confiable y sostenible |

Prevención temprana de sesgos y conflictos éticos

El comité funciona como un control especializado capaz de detectar sesgos, discriminaciones o impactos negativos antes de que se materialicen. Se observó que las empresas que cuentan con comités éticos registraron menos de violaciones éticas durante el despliegue de sistemas de IA. Esto demuestra que la vigilancia anticipada permite evitar conflictos.

Reducción de riesgos legales y regulatorios asociados a la IA

La supervisión ética disminuye las posibilidades de escándalos o demandas vinculadas al uso de IA. Las organizaciones que cuentan con comités éticos reportaron mayor confianza por parte de sus grupos de interés y menor riesgo de incumplimientos regulatorios.

En otras palabras, estos espacios ayudan a que las soluciones de IA estén alineadas con la legislación y los estándares éticos, lo que protege a la empresa y refuerza su reputación.

Innovación más confiable sin frenar el desarrollo tecnológico

Incluir criterios éticos no significa limitar el desarrollo tecnológico. Al contrario, puede potenciarlo. El 58% de los ejecutivos, según una encuesta de PwC, sostiene que las iniciativas de IA ética mejoran el retorno de inversión y la eficiencia.

Más de la mitad también percibe avances en la experiencia del cliente y en la capacidad de innovación. En ese sentido, un comité puede ayudar a diseñar soluciones de IA más confiables y de calidad, y fortalecer la confianza en los productos finales.

¿Qué desafíos enfrentan las organizaciones al crear un comité de ética?

Implementar un comité de ética para IA implica enfrentar varios retos. Entre ellos, se encuentran:

| Desafío clave | Qué debe garantizar el comité |

|---|---|

| Falta de criterios y expertise | Mirada multidisciplinaria y alfabetización en IA |

| Riesgo de frenar la innovación | Rol colaborativo desde etapas tempranas |

| Falta de respaldo y agilidad | Mandato claro y procesos proporcionales |

Falta de criterios comunes y escasez de conocimiento especializado en IA

La ética en inteligencia artificial es subjetiva y depende del contexto. Además, un comité eficaz necesita talento multidisciplinario, algo que no siempre es fácil de conseguir.

En ese sentido, Phaedra Boinodiris, líder en ética y gobernanza de IA de IBM, advirtió en un informe que “la alfabetización en inteligencia artificial es el desafío ético más importante: muchas organizaciones utilizan IA sin comprender plenamente sus implicaciones, lo que dificulta evaluar y mitigar riesgos de manera efectiva”.

Sin embargo, casi la mitad de los comités éticos corporativos no cuenta con suficiente conocimiento técnico como para evaluar sistemas complejos de IA. Sin una composición diversa, es probable que este no pueda detectar ciertos riesgos o carezca de autoridad para cuestionar desarrollos específicos.

Cómo evitar que el control ético frene la innovación

Un comité que impone demasiadas restricciones puede frenar la innovación y generar tensiones con los equipos de desarrollo. El desafío consiste en ejercer un control ético riguroso sin bloquear el avance de los proyectos. Por eso, es fundamental que esta comisión tenga un rol colaborativo y participe desde las primeras etapas, en lugar de actuar como una instancia de aprobación final.

Importancia del respaldo ejecutivo y procesos ágiles

Si no cuenta con respaldo de la alta dirección ni con facultades claras, el comité puede terminar como un órgano simbólico. Es fundamental que tenga un mandato definido y autoridad para hacer cumplir sus recomendaciones.

Además, si todos los proyectos deben pasar por su revisión, puede convertirse en un cuello de botella para el negocio, de acuerdo a un informe de PwC. En ese sentido, es recomendable establecer procesos ágiles.

- Ejemplo: definir qué desarrollos necesitan un análisis completo del comité y cuáles pueden gestionarse a partir de guías ya aprobadas.

¿Conviene formar un comité de ética para la IA?

A la luz de la evidencia, la recomendación es establecer algún mecanismo formal de gobernanza ética, y un comité específico sigue siendo una de las formas más efectivas.

Los beneficios en reducción de riesgos, cumplimiento normativo y reputación superan ampliamente las dificultades, siempre que el comité se conforme de manera adecuada. Ya en 2023, Sam Altman, CEO de OpenAI, le pidió publicamente al Congreso de Estados Unidos la regulación de la IA. “Mi peor temor es que causemos un daño significativo al mundo”, sostuvo.

¿Qué recomendaciones seguir para implementar un comité de ética en inteligencia artificial?

Estas son algunas recomendaciones para crear y sostener un comité de ética de IA:

- Mandato claro y respaldo ejecutivo: es importante definir por escrito sus funciones y facultades, con un documento aprobado por la dirección que le otorgue autoridad para frenar proyectos que no cumplan con los estándares. Los comités con mandatos formales tienden a ejercer una supervisión más efectiva.

- Composición multidisciplinaria: el comité debe reunir perfiles diversos. Si la empresa no cuenta con todos los conocimientos internamente, puede convocar expertos externos según la necesidad. Esa variedad de miradas permite evaluar los riesgos desde diferentes perspectivas.

- Integración en los procesos: es importante que el comité participe en todo el ciclo de vida de los proyectos de IA, desde sus primeras etapas. Además, la gobernanza debe entenderse como un proceso en evolución.

- Cultura ética y ejemplo desde la cima: la alta dirección tiene que apoyar al comité, respaldar sus decisiones y comunicar con claridad que la ética es una prioridad. El liderazgo no puede ceder ante presiones de corto plazo si estas ponen en riesgo los principios.

La evolución de los comités de ética en IA

Todo indica que los comités de ética en inteligencia artificial dejarán de ser instancias aisladas para convertirse en piezas centrales dentro de la gobernanza tecnológica. A medida que la adopción de IA se acelera y los marcos regulatorios se vuelven más exigentes, las organizaciones necesitarán modelos más dinámicos, capaces de integrar supervisión humana y auditorías continuas.

En ese contexto, la ética aplicada a la IA no solo funcionará como herramienta para mitigar riesgos, sino también como un elemento clave para sostener la confianza y acompañar el crecimiento a largo plazo.