La toma de decisiones informadas y precisas es esencial en una amplia gama de campos que abarcan desde la medicina hasta los negocios y la ciencia. Para abordar esta necesidad, los árboles de decisión surgieron como una poderosa herramienta en el arsenal del análisis de datos y de la inteligencia artificial.

Estos árboles gráficos, que representan secuencias lógicas de decisiones basadas en datos, brindan claridad y transparencia en el proceso de ejecutar medidas. En este artículo, vamos a explorar en profundidad qué, cómo se utilizan en diversas aplicaciones y cómo se construyen paso a paso, entre otros aspectos fundamentales.

Índice de temas

¿Qué es un árbol de decisión?

Un árbol de decisión es una representación gráfica de un proceso de toma de decisiones que se utiliza en una variedad de disciplinas como la inteligencia artificial, las elecciones empresariales e incluso las médicas.

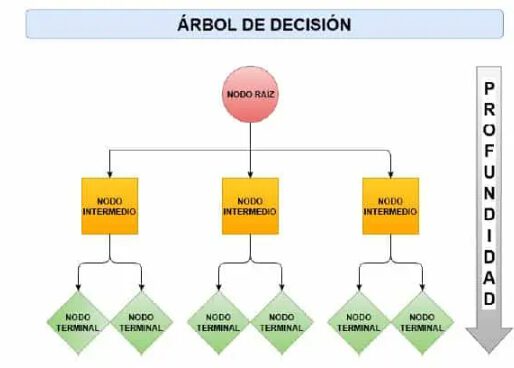

En otras palabras, según indicó un estudio de la Universidad de Massachusetts, “un árbol de decisión es una representación gráfica de un procedimiento para clasificar o evaluar un ítem de interés, cada nodo interior contiene un test”. En esencia, es una estructura que se asemeja a un árbol invertido, donde cada nodo del árbol representa una pregunta o condición, y las ramas que se desprenden de cada nodo representan las posibles respuestas o resultados.

Para qué se utiliza un árbol de decisión

Los árboles de decisión tienen un gran abanico de aplicaciones en distintas áreas. La organización sin fines de lucro Alliance for Decision Education indicó que el uso de arboles de desciones permite visualizar escenarios, ponderar riesgos y beneficios, y prever resultados antes de tomar una acción.

Su versatilidad los hace adecuados para una serie de tareas como:

- Diagnósticos médicos.

- Análisis de riesgo financiero.

- Toma de decisiones en negocios y marketing.

- Muchas otras aplicaciones basadas en datos.

Por otro lado, su flexibilidad los convierte en una herramienta valiosa para resolver muchos problemas en diferentes dominios, siendo fundamental en la caja de herramientas de los profesionales que se dedican al análisis de información y a seguir las tendencias clave en ciencia de datos.

Características, símbolos y componentes de un árbol de decisión

Un árbol de decisión se compone de varios elementos esenciales que lo hacen efectivo en la representación y resolución de problemas de toma de decisiones:

- Nodo raíz: es el punto de partida del árbol y representa la pregunta inicial o la condición que se debe evaluar para tomar una decisión.

- Nodos internos: estos nodos son preguntas adicionales o condiciones que se evalúan en el proceso de toma de decisiones.

- Ramas: las ramas conectan los nodos y hacen referencia a las posibles respuestas o resultados de las condiciones evaluadas en los nodos anteriores.

- Hojas: las hojas del árbol muestran las decisiones finales o las clasificaciones resultantes.

Además de estos componentes, en la representación gráfica de un árbol de decisión se utilizan símbolos específicos. Los nodos de decisión suelen representarse como rectángulos, mientras que los nodos de probabilidad (cuando se utilizan para problemas de regresión) se representan como óvalos. Las flechas conectan los nodos y las ramas e indican la secuencia de evaluación de condiciones y toma de decisiones.

Árboles de decisión como base de la inteligencia artificial explicable (XAI)

La inteligencia artificial explicable (XAI) es un área que busca hacer que los modelos de IA sean más transparentes y comprensibles para los humanos. Esto resulta fundamental en sectores regulados o de alto impacto.

Los árboles de decisión son uno de los métodos más clásicos y efectivos en XAI debido a su estructura intuitiva, donde el flujo desde el nodo raíz hasta una hoja representa una ruta lógica que se puede seguir paso a paso. Esto posibilita que los expertos y usuarios puedan entender fácilmente por qué una decisión fue tomada.

Además, algunas herramientas modernas extienden esta capacidad con visualizaciones interactivas y análisis de características, lo que ayuda a detectar patrones, posibles sesgos o incluso fallas en el modelo. Por este motivo, los árboles siguen siendo un pilar para desarrollar soluciones transparentes, sobre todo con técnicas explicativas para modelos complejos como por ejemplo, SHAP o LIME.

McKinsey indicó en la encuesta “El estado de la IA 2024” que el 60% de las empresas priorizan modelos explicables, como los árboles de decisión, para cumplir con regulaciones de transparencia en IA. Esta tendencia consolida a este método como una de las herramientas más confiables en sectores críticos.

Interpretación y análisis de resultados en árboles de decisión

Una de las ventajas más destacadas de los árboles de decisión es su capacidad para interpretar y analizar datos de manera relativamente sencilla. La estructura jerárquica del árbol hace posible entender cómo se llega a una decisión específica siguiendo un camino desde el nodo raíz hasta una hoja.

El análisis de un árbol de decisión implica identificar las características más influyentes en la toma de decisiones. Esto se logra observando qué nodos y características aparecen en los niveles superiores del árbol para determinar su importancia en la clasificación o predicción.

Además, se pueden calcular medidas de importancia de características, como la ganancia de información o la importancia de gini para cuantificar la contribución de cada característica al modelo. Esto aporta información valiosa sobre cómo se ponderan las variables en las decisiones del árbol.

Opciones de visualización avanzada para facilitar la interpretación

La interpretación es un punto fuerte de los árboles de decisión y se potencia con las siguientes herramientas de visualización avanzada:

- Gráficos interactivos: exploran rutas de decisión, cambian parámetros y observan efectos en tiempo real.

- Mapas de calor y diagramas de importancia: muestran la importancia de cada característica en el modelo para facilitar la comunicación con stakeholders.

- Integración con dashboards empresariales: posibilitan el monitoreo y la explicación de resultados para usuarios no técnicos.

- Visualización de SHAP values: para entender el impacto de cada variable en decisiones individuales.

Ventajas del uso de árboles de decisión

Los árboles de decisión brindan una serie de ventajas que deben ser consideradas antes de aplicar esta técnica:

- Interpretabilidad: los árboles de decisión son altamente interpretables, lo que significa que es fácil comprender cómo se llega a una decisión específica siguiendo las ramas del árbol.

- Manejo de datos mixtos: pueden manejar tanto datos categóricos como numéricos, lo que los hace versátiles en una variedad de aplicaciones.

- No necesitan normalización: a diferencia de algunos modelos, como las redes neuronales, los árboles de decisión no necesitan la normalización de datos, ya que simplifican el proceso de preparación de información.

- Identificación de características relevantes: ayudan a identificar las características más importantes en la toma de decisiones. Así, se pueden obtener tener indicios importantes en la comprensión del problema.

- Aplicabilidad en clasificación y regresión: son eficaces tanto en problemas de clasificación como en problemas de regresión.

Sostenibilidad y eficiencia computacional

Además, en un contexto en donde la eficiencia energética y computacional es cada vez más importante, los árboles de decisión presentan las siguientes ventajas en torno a la sostenibilidad

- Son menos demandantes en recursos que los modelos complejos de deep learning. Esto se traduce en un menor consumo energético durante entrenamiento e inferencia.

- Su estructura sencilla facilita la optimización en hardware específico apoyado en aplicaciones IoT y edge computing.

- La poda y las técnicas de reducción de complejidad contribuyen para desarrollar modelos compactos que consumen menos memoria y favorecen los despliegues sostenibles.

Apostar por árboles de decisión en proyectos de IA puede favorecer la sostenibilidad ambiental y la reducción de costos computacionales; dos aspectos clave para su adopción masiva en empresas.

Aplicaciones del árbol de decisión en diferentes campos

Los árboles de decisión tienen aplicaciones en una amplia gama de campos debido a su versatilidad y capacidad para resolver problemas complejos. Entre ellos se destacan:

| Campo | Aplicación principal |

|---|---|

| Medicina | Diagnóstico de enfermedades a partir de síntomas y pruebas |

| Finanzas | Evaluación de riesgo crediticio y detección de fraudes |

| Negocios y marketing | Segmentación de clientes y personalización de campañas publicitarias |

| Manufactura e industria | Control de calidad y optimización de procesos |

| Ecología y biología | Clasificación de especies y predicción de patrones ecológicos |

| Recursos humanos | Selección de candidatos y análisis de rotación de empleados |

| Educación | Predicción del rendimiento estudiantil y recomendación de tutorías |

Medicina

En el diagnóstico médico, los árboles de decisión ayudan a los profesionales de la salud a identificar enfermedades basadas en síntomas, historiales médicos y resultados de pruebas. Pueden ser particularmente útiles en el diagnóstico temprano de enfermedades como el cáncer.

En Estados Unidos, por ejemplo, la Agencia para Sustancias Tóxicas y el Registro de Enfermedades del CDC utiliza un árbol de decisión para evaluar exposiciones ambientales. Este esquema plantea una serie de preguntas binarias sobre vías de exposición, niveles y poblaciones afectadas, y determina si es necesario realizar evaluaciones de salud adicionales

Finanzas

Los árboles de decisión se utilizan para evaluar el riesgo crediticio al analizar la solvencia de los prestatarios. También se aplican en la predicción de precios de activos financieros y en la detección de fraudes financieros.

Negocios y marketing

Las estrategias de marketing se benefician de los árboles de decisión al segmentar a los clientes en grupos según su comportamiento y preferencias. Esto permite tener una mayor personalización de las campañas publicitarias y, como consecuencia, un aumento de la retención de clientes.

Manufactura e industria

En la industria se utilizan para el control de calidad y la detección de defectos en productos manufacturados. También ayudan en la optimización de procesos de producción y logística.

Ecología y biología

Los árboles de decisión se emplean en la clasificación de especies en biología y en la predicción de patrones ecológicos. Estos modelos pueden contribuir a la conservación de la biodiversidad y al estudio de los ecosistemas.

Recursos humanos

En la gestión de recursos humanos se utilizan para la selección de candidatos durante procesos de contratación y también para identificar tendencias de rotación y retención de empleados.

Educación

Los árboles de decisión pueden ser utilizados en el campo de la educación para predecir el rendimiento de los estudiantes y proporcionar recomendaciones de tutoría. Algo similar ocurre con el procesamiento de lenguaje natural en empresas, el cual se aplica para interpretar datos textuales complejos.

Casos de uso en IA empresarial

Más allá de las aplicaciones tradicionales, los árboles de decisión y sus extensiones se están utilizando en casos como:

- Detección de fraude en tiempo real: identifican patrones sospechosos rápidamente en operaciones financieras o transacciones digitales.

- Optimización de la cadena de suministro: en logística y manufactura, ayudan a predecir fallas, optimizar rutas y mejorar la gestión de inventarios.

- Análisis de sentimiento y comportamiento del cliente: integrados con modelos de procesamiento de lenguaje natural (NLP) para personalizar experiencias y mejorar la retención.

- IA para sostenibilidad: modelos que predicen consumo energético o impacto ambiental. Apoyan las decisiones empresariales más responsables.

Estos ejemplos reflejan cómo la adaptabilidad y el uso de árboles con otras técnicas está ampliando su valor estratégico en las empresas.

Cómo construir un árbol de decisión paso a paso

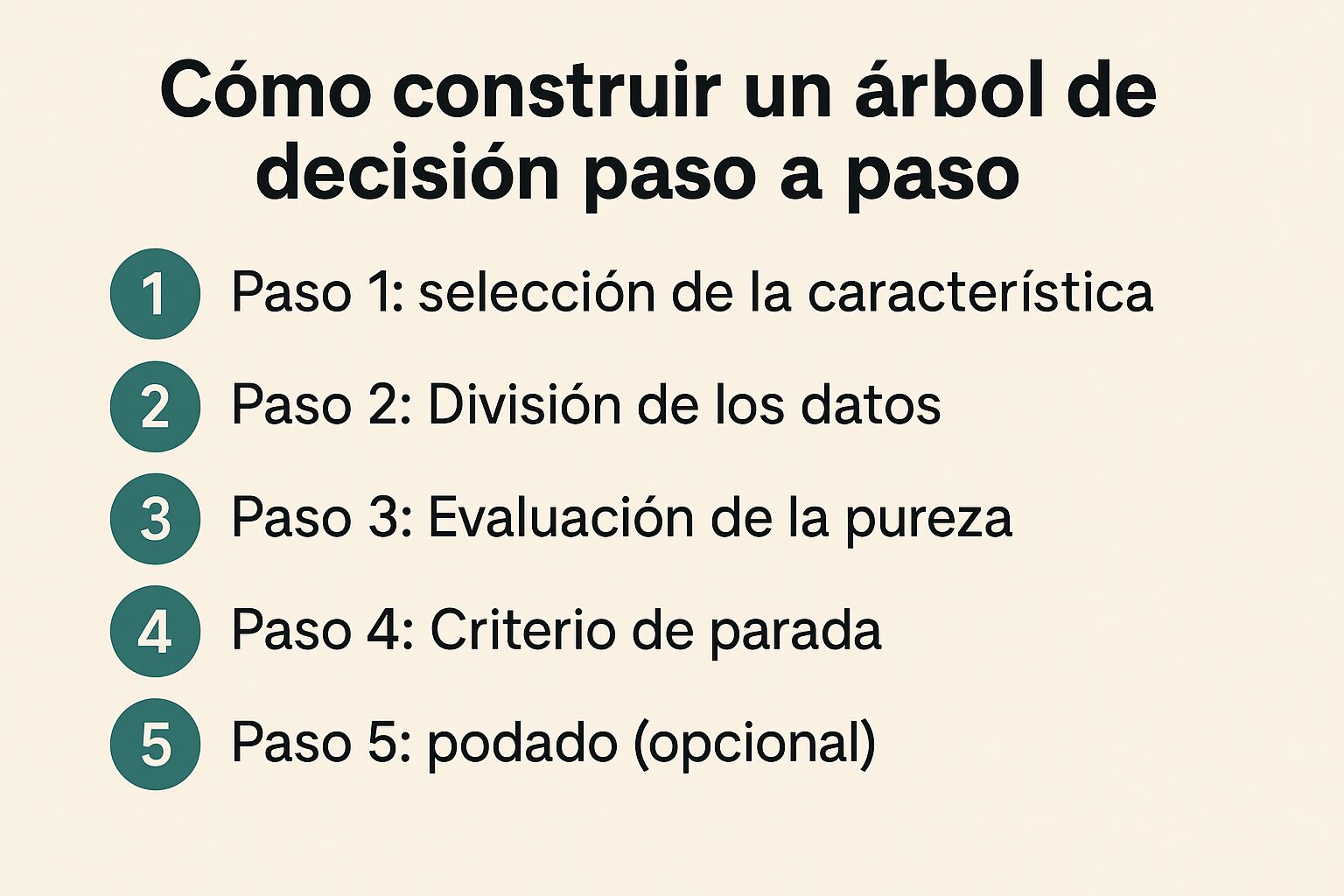

La construcción de un árbol de decisión es un proceso iterativo que implica los siguientes pasos clave:

Paso 1: selección de la característica

En cada nodo se deberá seleccionar la característica que se quiere utilizar para dividir los datos. Esta elección se basa en criterios como la ganancia de información o la reducción de la impureza.

Paso 2: división de los datos

Los datos se dividen en subconjuntos en función de los valores de la característica seleccionada. Cada subconjunto se asigna a un nodo hijo.

Paso 3: evaluación de la pureza

Se calcula la pureza o impureza de cada nodo hijo mediante la utilización de una métrica como la entropía o el índice gini. El objetivo es maximizar la pureza en cada nodo.

Paso 4: criterio de parada

Se establece un criterio de parada para determinar cuándo detener la subdivisión del árbol. Esto puede incluir la profundidad máxima del árbol o el número mínimo de muestras en un nodo.

Paso 5: podado (opcional)

Después de construir el árbol, se puede aplicar un proceso de poda para eliminar nodos que no contribuyen a la precisión del modelo. Esto ayuda a evitar el sobreajuste.

La construcción de un árbol de decisión es un equilibrio entre la simplicidad y la capacidad de generalización del modelo.

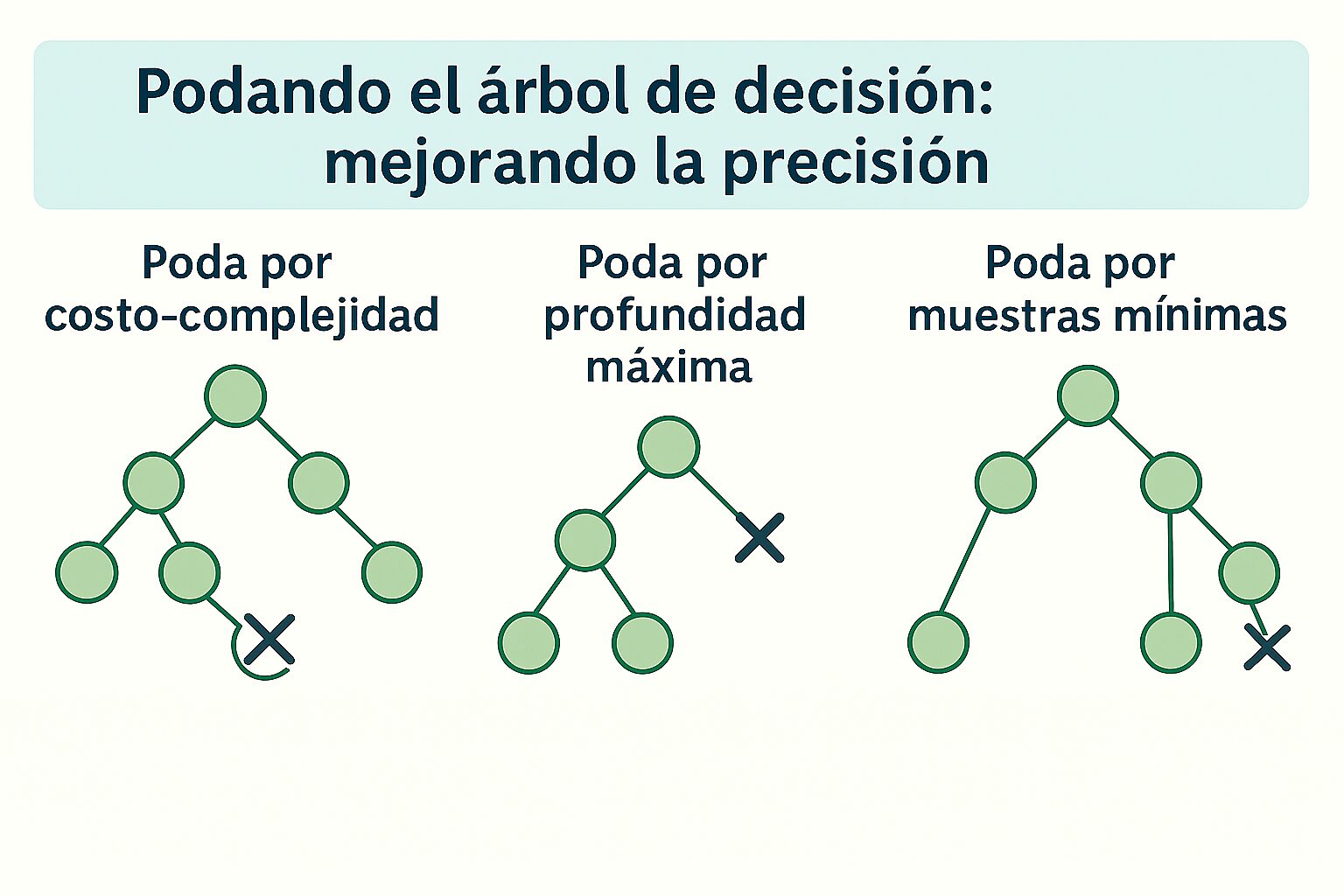

Podando el árbol de decisión: mejorando la precisión

Un aspecto crítico en la construcción de árboles de decisión es evitar el sobreajuste, es decir, donde el modelo se adapta demasiado a los datos de entrenamiento y no generaliza bien la nueva información.

La poda es una técnica que busca mejorar la generalización del modelo al eliminar nodos que no contribuyen a la precisión.

Este proceso se puede realizar de varias maneras:

Poda por costo-complejidad

Se calcula un parámetro de complejidad para cada nodo del árbol y se elimina el nodo que reduzca la complejidad global del árbol sin afectar su precisión.

Poda por profundidad máxima

Se limita la profundidad máxima del árbol, lo que evita que se desarrolle en exceso y se sobreajuste a los datos de entrenamiento.

Poda por muestras mínimas

Se establece un umbral mínimo de muestras requeridas en un nodo para que se considere válido. Los nodos con menos muestras se eliminan.

Métodos de aprendizaje y entrenamiento de árboles de decisión

Los árboles de decisión aprenden a partir de datos etiquetados mediante el uso de algoritmos específicos dentro del marco del machine learning y sus aplicaciones.

Algunos de los más conocidos son:

| Algoritmo | Características principales |

|---|---|

| ID3 | Usa ganancia de información. Solo datos categóricos. |

| C4.5 | Soporta datos numéricos y categóricos. Usa ganancia o índice Gini. |

| Random Forest | Combina árboles. Reduce sobreajuste. Alta precisión. |

| Gradient Boosting | Entrena árboles en secuencia. Corrige errores. |

Id3 (iterative dichotomiser 3)

Este algoritmo utiliza la ganancia de información como métrica para seleccionar la característica óptima en cada nodo. Id3 es efectivo para problemas con datos categóricos, pero no maneja bien características numéricas.

C4.5

Una evolución de Id3 es el algoritmo c4.5. Este es más versátil y puede manejar tanto datos categóricos como numéricos. Utiliza la ganancia de información o el índice gini para evaluar las divisiones de nodos.

Random forest

Aunque no es un algoritmo de árbol de decisión único, random forest es una técnica que cuenta con múltiples árboles de decisión para mejorar la precisión y reducir el sobreajuste. Cada árbol se entrena con una muestra aleatoria de datos y características.

Gradient boosting

Esta técnica también utiliza múltiples árboles de decisión, pero en lugar de entrenarlos de manera independiente como en random forest, los entrena de forma secuencial para corregir los errores del modelo anterior.

Librerías modernas: XGBoost, LightGBM y CatBoost

Entre las librerías más importantes y utilizadas para implementar árboles de decisión avanzados se encuentran:

- XGBoost (Extreme Gradient Boosting): muy popular por su rendimiento y velocidad. Es ampliamente usado en competiciones de ciencia de datos y proyectos empresariales.

- LightGBM: desarrollada por Microsoft, es eficiente en memoria y rápida, y es útil para grandes conjuntos de datos con características categóricas.

- CatBoost: creada por Yandex, sobresale en el manejo automático de variables categóricas y reduce el riesgo de overfitting. Facilita la construcción de modelos robustos.

Estas herramientas revolucionaron el uso de árboles de decisión con su velocidad, precisión y capacidad de manejo de datos heterogéneos que hacen posible su aplicación en proyectos a gran escala.

¿Cuál elegir?

La elección del algoritmo va a depender del tipo de datos, la naturaleza del problema y las necesidades de interpretación del modelo. Los árboles de decisión son adecuados cuando se trata de explicar el razonamiento detrás de las decisiones tomadas, lo que los hace valiosos en situaciones donde se necesita de transparencia.

Árboles de decisión en AutoML y MLOps

En los pipelines modernos de machine learning, los árboles de decisión y sus variantes se integran de forma automatica y son un componente esencial dentro de herramientas como:

- AutoML: plataformas como Google AutoML, H2O.ai o Auto-sklearn incorporan algoritmos basados en árboles (XGBoost, LightGBM) para automatizar la selección, entrenamiento y optimización de modelos. Esto facilita el desarrollo rápido de modelos sin necesidad de expertos en ML.

- MLOps: en operaciones de machine learning (MLOps), los árboles se integran en pipelines que producen, monitorean y actualizan los modelos para garantizar eficiencia y control de versiones. Su interpretabilidad simplifica la auditoría y el cumplimiento de regulaciones.

Estas integraciones hacen que los árboles de decisión formen parte de sistemas automatizados, escalables y confiables que son cada vez más usados en empresas que buscan acelerar sus procesos de inteligencia artificial.

Limitaciones del uso de árboles de decisión

A pesar de los múltiples beneficios, los árboles de decisiones no están exentos de desafíos y limitaciones:

- Sobreajuste: tienen una tendencia natural a sobreajustarse a los datos de entrenamiento, lo que puede resultar en un rendimiento deficiente en información de prueba no vista.

- Inestabilidad: son sensibles a pequeños cambios en los datos de entrenamiento. Esto puede llevar a árboles diferentes con pequeñas variaciones en los resultados.

- Limitación en modelar relaciones complejas: en comparación con algunos modelos más avanzados como las redes neuronales, los árboles de decisión pueden tener dificultades para modelar relaciones complejas en los datos.

- Baja precisión en problemas altamente no lineales: en problemas altamente no lineales, los árboles de decisión pueden no ser la mejor opción debido a su naturaleza recursiva.

- Sesgo hacia características con más categorías: las características con más categorías tienden a ser seleccionadas como las más importantes, lo que puede llevar a un sesgo en la toma de decisiones.

La elección de utilizar árboles de decisión debe basarse en la naturaleza del problema y en las necesidades específicas de interpretación y precisión. En muchos casos, se pueden superar sus limitaciones mediante técnicas de mejora y la utilización de otros modelos.

Estrategias para mitigar sesgos en decisiones automatizadas

Los árboles de decisión, al basarse en datos históricos, pueden heredar o amplificar sesgos presentes en los datos y afectar la equidad de las decisiones automatizadas.

Para mitigar estos riesgos, se recomiendan:

- Preprocesamiento de datos: detectar y corregir sesgos en los datos antes de entrenar.

- Incorporación de métricas de equidad: evaluar modelos con métricas específicas para asegurar que las decisiones no discriminen.

- Regularización y poda: evitar sobreajuste a patrones sesgados mediante técnicas de poda o limitando la profundidad.

- Auditoría continua y explicabilidad: usar la interpretabilidad de los árboles para identificar decisiones sesgadas y ajustar el modelo o el proceso.

Estas prácticas son fundamentales para desarrollar modelos de IA responsables y confiables.

Comparación de árboles de decisión con otros modelos de aprendizaje automático

Los árboles de decisión se diferencian de otros modelos de aprendizaje automático en varias dimensiones clave:

| Criterio | Árboles de decisión | Otros modelos (ej. redes neuronales) |

|---|---|---|

| Interpretabilidad | Alta: fáciles de entender y explicar | Baja: suelen ser cajas negras |

| Simplicidad | Modelo simple y explícito | Alta complejidad matemática y estructural |

| Precisión | Buena, pero limitada en problemas complejos | Alta en tareas complejas, pero menos interpretables |

| Preparación de datos | No requiere normalización, maneja datos mixtos | Requiere datos normalizados y preprocesamiento específico |

| Aplicación ideal | Cuando se prioriza la transparencia y comprensión del modelo | Cuando la precisión es más importante que la interpretabilidad |

Interpretabilidad

Los árboles de decisión son altamente interpretables, mientras que modelos como las redes neuronales suelen ser cajas negras difíciles de entender.

Simplicidad vs. complejidad

Los árboles de decisión son modelos simples y explícitos, lo que los hace adecuados para problemas donde la simplicidad y la transparencia son importantes. En contraste, modelos como las redes neuronales pueden ser extremadamente complejos y difíciles de interpretar.

Precisión vs. interpretabilidad

En problemas donde la precisión es fundamental y la interpretabilidad es menos importante, otros modelos como las redes neuronales profundas pueden superar a los árboles de decisión.

Requerimientos de datos

Los árboles de decisión pueden manejar datos mixtos y no necesitan normalización. Esto puede simplificar la preparación de datos en comparación con otros modelos que tienen requisitos más estrictos.

La elección entre árboles de decisión y otros modelos de aprendizaje automático depende de las características del problema, los objetivos del proyecto y los tipos de inteligencia artificial y su impacto en cada caso.

Árboles de decisión y tendencias futuras en la inteligencia artificial

Aunque los árboles de decisión son modelos clásicos y muy interpretables, en los últimos años se integraron de forma exitosa con modelos más avanzados de inteligencia artificial y aprendizaje profundo para poder utilizar la interpretabilidad y la potencia predictiva.

Por ejemplo, los modelos híbridos cuentan árboles de decisión con redes neuronales profundas para aprovechar lo mejor de ambos mundos. Por un lado, la capacidad de representación de las redes y, por el otro, la transparencia de los árboles. En algunos casos, se utilizan para interpretar o explicar las salidas de modelos complejos de deep learning para facilitar la comprensión de decisiones en aplicaciones críticas.

Además, algunas técnicas como el gradient boosting (con librerías como XGBoost, LightGBM y CatBoost) construyen modelos altamente precisos de múltiples árboles de decisión débiles. Esto tiene el objetivo de integrar conceptos de machine learning avanzado para mejorar la capacidad predictiva.

El uso de árboles de decisión en ámbitos donde tradicionalmente solo se aplicaban redes neuronales o modelos complejos está haciendo más accesible la explicación de decisiones automáticas.

Ejemplos de árboles de decisión

Para ilustrar el uso de los árboles de decisión en la práctica, consideremos dos ejemplos:

Ejemplo 1: diagnóstico médico

Supongamos que un médico utiliza un árbol de decisión para diagnosticar una enfermedad. El nodo raíz podría representar una pregunta inicial sobre los síntomas del paciente como por ejemplo la fiebre. Si la respuesta es “sí”, el árbol podría conducir a un nodo que evalúa la duración de la fiebre, y así sucesivamente. En este caso, las hojas del árbol representarían los posibles diagnósticos.

Ejemplo 2: clasificación de clientes en marketing

Un especialista en marketing utiliza un árbol de decisión para segmentar a los clientes en una campaña publicitaria. El nodo raíz podría preguntar si el cliente realizó compras recientes. Si la respuesta es “sí”, el árbol podría dividirse en función del gasto total del cliente. Las hojas podrían indicar segmentos como “clientes de alto valor” o “clientes inactivos”.

Los árboles de decisión demostraron ser una herramienta invaluable en la toma de decisiones basada en datos en una variedad de campos, como demuestran las tendencias de inteligencia artificial en Argentina. Su capacidad de interpretación, simplicidad y versatilidad los convierten en una opción atractiva tanto para expertos como para principiantes.

A medida que la inteligencia artificial avanza, la integración de árboles de decisión con modelos más avanzados y el enfoque en la transparencia de las decisiones van a seguir siendo áreas de interés.

Gracias. Aquí tienes el bloque completo generado según tu PROMPT DEFINITIVO, optimizado para SEO multibuscador y motores generativos, dirigido a un público técnico B2B: —¿Cómo documentar la trazabilidad de decisiones tomadas por árboles de decisión en entornos regulados?

La trazabilidad puede documentarse exportando el árbol como gráfico estructurado, registrando los parámetros de entrenamiento y guardando los conjuntos de datos originales. Herramientas como MLflow o DVC permiten versionar modelos y sus datos para auditorías.

¿Qué métricas se recomiendan para evaluar árboles de decisión en problemas empresariales?

En entornos empresariales se priorizan métricas como precisión, recall, F1-score y AUC-ROC. Para problemas de clasificación desequilibrada, es clave usar matriz de confusión y curvas PR para evitar falsas interpretaciones.

¿Se pueden explicar las predicciones individuales de un árbol de decisión a usuarios no técnicos?

Sí. Mediante visualizaciones simplificadas del camino desde el nodo raíz a la hoja correspondiente, o con herramientas como SHAP para mostrar el impacto de cada variable en la predicción individual.

¿Qué prácticas permiten implementar árboles de decisión en edge computing sin comprometer recursos?

Es recomendable usar árboles podados, limitar la profundidad, compilar el modelo a formatos optimizados como ONNX o CoreML, y utilizar librerías ligeras como Treelite para entornos de bajo consumo.

¿Cómo afecta la calidad de los datos a la estabilidad de los árboles de decisión?

Los árboles son sensibles al ruido y a los valores atípicos. Datos mal balanceados o con alta cardinalidad pueden inducir sobreajuste o selecciones erróneas. Por eso, es clave preprocesar y balancear adecuadamente antes del entrenamiento.