Este 10 de febrero, el Día de la Internet Segura vuelve a poner el foco en una urgencia que gana peso: cómo resguardar la identidad digital y los datos personales frente a tecnologías que avanzan más rápido que las leyes que intentan regularlas.

Expertos en ciberseguridad remarcan que los peligros se multiplicaron. Hoy, las amenazas abarcan desde la creación de deepfakes, la captura silenciosa de datos públicos para entrenar inteligencias artificiales, hasta ataques que operan desde el interior de los propios dispositivos.

Por eso, compañías como F5, Nubiral y Google destacan algo clave: la seguridad digital no depende solo de sistemas informáticos. Las acciones humanas, la educación y la responsabilidad individual son decisivas frente a fraudes y robos de identidad.

Índice de temas

La inteligencia artificial y el desafío de los deepfakes

Uno de los ejes más sensibles del debate actual gira en torno a la expansión y perfeccionamiento de los deepfakes. Estas piezas audiovisuales creadas con IA ya no representan una curiosidad técnica, sino una amenaza concreta contra la privacidad y la confianza digital. En redes sociales de uso masivo aparecieron chatbots capaces de generar imágenes íntimas no consentidas a partir de simples comandos, incluso con fotos de menores de edad.

Especialistas advierten que el problema excede lo técnico. El uso de estas herramientas expuso una falla estructural: la forma en que los datos compartidos voluntariamente pueden ser procesados por modelos de lenguaje (LLM) con fines maliciosos. Fotografías, audios y videos publicados sin restricciones alimentan sistemas que luego reproducen contenidos hiperrealistas, difíciles de distinguir de la realidad.

“El problema no es la herramienta. Es el entrenamiento de estos modelos con datos públicos sin su consentimiento explícito”, señalaron desde el sector. Esta práctica abrió interrogantes éticos profundos sobre la responsabilidad de las plataformas y de quienes desarrollan soluciones basadas en IA. También reavivó una discusión incómoda: la cadena de responsabilidades se fragmenta tanto que, en muchos casos, nadie asume las consecuencias.

La erosión de la confianza digital aparece como una de las secuelas más visibles. Ya no alcanza con proteger una cuenta. También resulta necesario garantizar que los contenidos que circulan no se utilicen para acoso, extorsión o fraude.

Infraestructura digital: APIs, datos y desinformación

Desde la mirada de la infraestructura tecnológica, F5 identificó tres áreas críticas donde la seguridad de los datos hoy queda comprometida. La primera se vincula con la exposición de APIs. Estas interfaces funcionan como puentes entre plataformas y permiten el intercambio de información personal. Cuando no cuentan con controles adecuados, habilitan la recolección masiva de datos por terceros, tanto para entrenar IA como para ejecutar ataques de ingeniería social.

El segundo foco se relaciona con el auge de la desinformación sintética. En Argentina, durante las elecciones de 2025, circuló un video falso generado con IA que mostraba a un dirigente político anunciando la baja de su candidatura. El impacto no se limitó a la coyuntura electoral. Este tipo de episodios profundizó la desconfianza sobre lo que se ve y se escucha en línea.

El tercer punto crítico se desplazó hacia el usuario. Los atacantes migraron sus estrategias al lugar donde se produce la interacción directa: navegadores y aplicaciones móviles. Allí, el código malicioso intercepta información antes de que llegue a servidores protegidos, lo que facilita el robo de identidad.

El vicepresidente de F5 para Latinoamérica, Roberto Ricossa, describió el escenario sin eufemismos: “El escenario actual es el de una batalla de inteligencia artificial buena contra una inteligencia artificial mala, entre quienes lanzan aplicaciones y quienes las hackean”.

La soberanía digital y las acciones de las empresas

En este contexto, la soberanía digital dejó de ser una noción abstracta para convertirse en una necesidad operativa. Las organizaciones, como actores centrales en la adopción de IA, enfrentan el desafío de proteger la información sin frenar la innovación. La recomendación principal apunta a implementar estrategias de seguridad de Aplicaciones y APIs, capaces de detectar comportamientos automatizados de bots y herramientas de IA que intentan extraer o manipular datos.

“Las empresas necesitan asegurarse de que, mientras equilibran las cargas de procesamiento, la información confidencial permanezca bajo un control estricto”, explicó Federico Aragona, director de ventas regional de F5 para Latinoamérica.

La infraestructura que sostiene internet —nubes de datos, plataformas y APIs— requiere capas de verificación de identidad más profundas. La lógica de Confianza Cero gana terreno, con controles continuos sobre cada acceso y cada interacción. La seguridad ya no funciona como un muro estático, sino como un proceso constante.

Para los usuarios, las recomendaciones resultan más directas. Revisar configuraciones de privacidad, limitar el uso de fotos personales para entrenar modelos de IA y evaluar qué información se publica forman parte de una nueva higiene digital. En plataformas con políticas de uso de datos poco claras, la cautela se vuelve una herramienta de protección.

“La seguridad depende de nuestras propias acciones y de hasta dónde permitimos el involucramiento de la tecnología en nuestras vidas”, afirmó Aragona.

El factor humano: ¿eslabón débil o primera defensa?

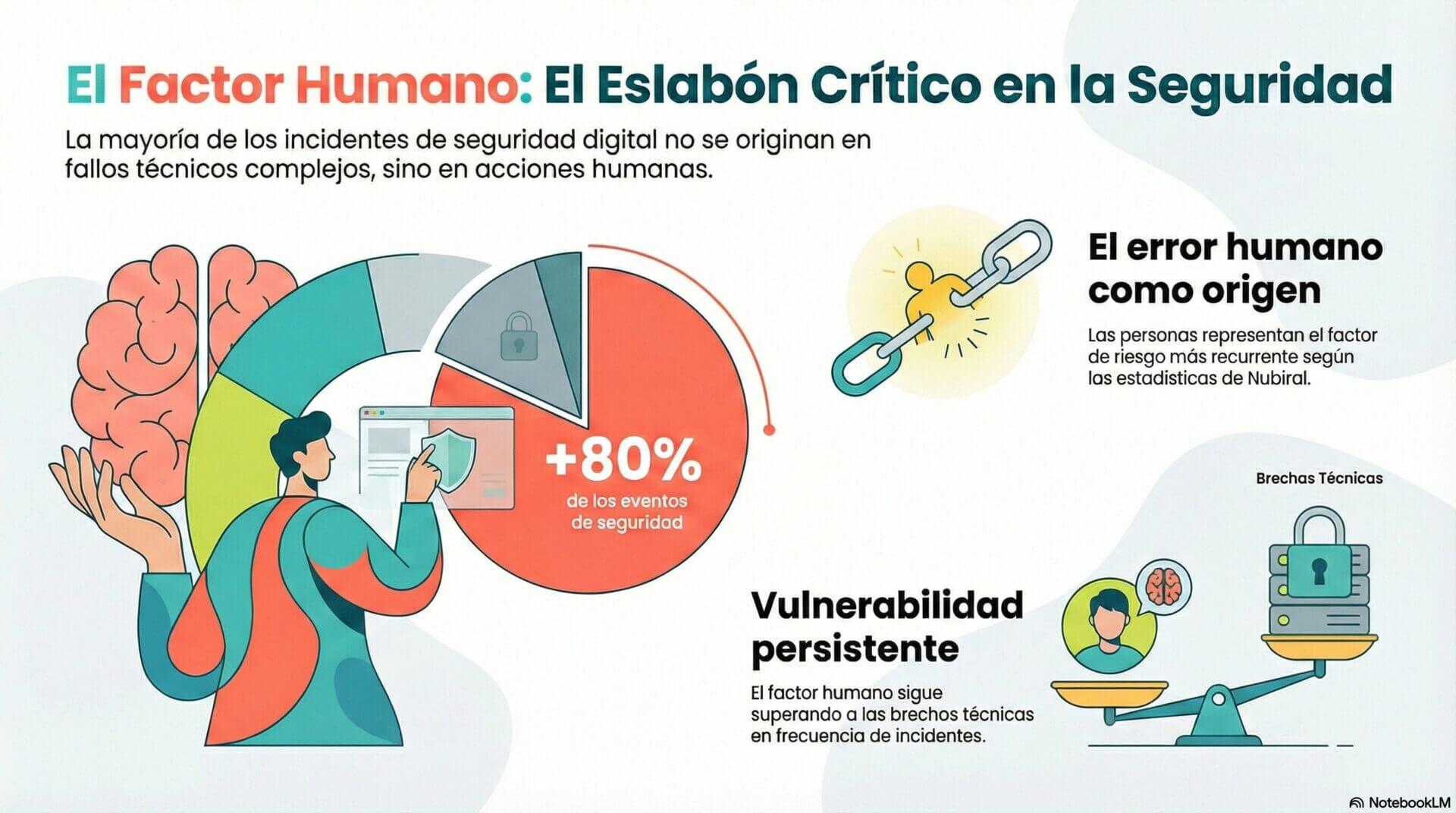

En el Día de la Internet Segura, Nubiral puso el foco en un aspecto que atraviesa todos los incidentes: el factor humano. Hoy, más del 80% de los eventos de seguridad involucran algún tipo de error cometido por personas. La estadística se repite en informes de todo el mundo y confirma una tendencia persistente.

Datos recientes refuerzan este diagnóstico. Según Fortinet, el 73% de las organizaciones de tecnologías operativas sufrió al menos un ataque cibernético durante 2024. A su vez, un informe de KPMG indicó que el 49% de las organizaciones continuó sin programas de ciberseguridad o con esquemas básicos.

“Muchas veces, los usuarios resultan ser el eslabón más débil en la cadena de ciberseguridad, causando el 74% de las filtraciones. Por ello la palabra clave es educación”, sostuvo Gustavo Pontoriero, líder en Ciberseguridad de Nubiral. “El objetivo es aumentar la relevancia de la ciberseguridad en nuestra vida cotidiana y animar a personas y empresas a tomar medidas de prevención”, agregó.

Errores como el uso de contraseñas débiles, la falta de atención al manejar información sensible o caer en phishing continúan entre las principales causas de incidentes. Frente a este escenario, la capacitación constante aparece como la herramienta más efectiva. Programas periódicos, simulaciones y actualización de políticas internas permiten reducir riesgos y acompañar los procesos organizacionales.

Pontoriero destacó además el rol de la IA en soluciones de seguridad, especialmente en tareas de detección y respuesta inicial. Estas tecnologías optimizan tiempos y permiten que los equipos humanos se concentren en análisis complejos y toma de decisiones críticas.

Gmail y las prácticas clave contra estafas digitales

En el marco de esta fecha, Google compartió cinco prácticas para reconocer y bloquear posibles estafas en Gmail, uno de los servicios de correo más utilizados en la región. El contexto resulta preocupante. El informe M-Trends 2025 de Mandiant señaló que el robo de credenciales representó el 18% de los vectores de ataque en América, por encima del phishing, que alcanzó el 16%. La explotación de vulnerabilidades lideró con 28%.

El estudio también mostró que el tiempo promedio de detección en la región fue de 10 días, mientras que en casos de ransomware se redujo a 6 días. Un dato alarmante completó el panorama: el 62% de las víctimas tomó conocimiento de la intrusión solo cuando el delincuente se comunicó.

Entre las recomendaciones centrales, Google destacó la validación rigurosa del remitente, el análisis de enlaces antes de hacer clic y la desconfianza frente a pedidos de datos confidenciales. Entidades financieras y organismos públicos no solicitan contraseñas ni números de tarjetas por correo electrónico.

Prácticas de seguridad en gmail y amenazas digitales

| Tipo de Amenaza o Práctica | Detalle o Estadística | Fuente |

|---|---|---|

| Phishing | Alcanzó el 16% de los vectores de ataque; la IA de Gmail bloquea más del 99,9% de estos intentos. | [1] |

| Robo de credenciales | Representó el 18% de los vectores de ataque registrados en América. | [1] |

| Explotación de vulnerabilidades | Se posicionó como el principal vector de ataque con un 28%. | [1] |

| Aprendizaje Automático e IA | Estas tecnologías permiten detectar un 20% más de amenazas actuales dentro del entorno de Gmail. | [1] |

| Autenticación multifactor (MFA) | Capa de protección esencial que bloquea el acceso no autorizado incluso si las credenciales de usuario se filtran. | [1] |

| Passkeys y Reportes | Se recomienda la adopción de Passkeys (llaves de acceso) y el reporte activo de mensajes sospechosos por parte del usuario. | [1] |

| Validación del remitente | Práctica recomendada consistente en realizar un análisis riguroso de la identidad de quien envía el correo electrónico. | [1] |

| Detección de intrusiones | El 62% de las víctimas descubre la intrusión únicamente cuando el ciberdelincuente se pone en contacto con ellas. | [1] |

| Tiempo de detección | El promedio de detección es de 10 días en la región y disminuye a 6 días en casos específicos de ransomware. | [1] |

La activación de la autenticación multifactor (MFA) sumó otra capa de protección clave. Incluso si las credenciales quedan expuestas, este mecanismo bloquea el acceso no autorizado. Además, Gmail utiliza modelos de aprendizaje automático que bloquean más del 99,9% del spam, el phishing y el malware, con sistemas que hoy detectan un 20% más de amenazas gracias a nuevos modelos de IA.

La recomendación final apunta a mantener una postura activa: prestar atención a las alertas, reportar mensajes sospechosos y adoptar alternativas como Passkeys. En un escenario donde los ataques se vuelven cada vez más sofisticados, la prevención cotidiana y las acciones individuales continúan como la primera línea de defensa frente a fraudes, estafas y robos de identidad.